1 tf.nn.conv2d( 2 input, 3 filter, 4 strides, 5 padding, 6 use_cudnn_on_gpu=True, 7 data_format='NHWC', 8 dilations=[1, 1, 1, 1], 9 name=None 10 )

input:输入数据

filter:过滤器

strides:卷积滑动步长,实际上可以解释为过滤器的大小

padding:图像边填充方式

--------------------------------------------------------------------------------------------->

在这里详细地对各个参数做出解释:

input:就是卷积的输入数据,该输入数据要求是一个Tensor,所以张量的shape为[batch, in_height, in_width, in_channels],batch为训练 [ 一个 ] batch图片数量,这是一个四维向量,所以类型为half,bfloat16,float32, float64.

filter:为一个张量,必须和input是一样的4D shape。[filter_height, filter_width, in_channels, out_channels],参数的第三维就是input内的第四维

padding:整数型的列表,只有“SAME”和“VALID”两个值,在这里SAME和VALID的计算需要说明一下

1 #“SAME” 计算方式 2 out_height = ceil(float(in_height)) / float(strides[1]) 3 out_width = ceil(float(in_width)) / float(strides[2]) 4 5 #“VALID”计算方式 6 out_height = ceil(float(in_height - filter_height + 1)) / float(strides[1]) 7 out_width = ceil(float(in_width - filter_width + 1)) / float(strides[2])

strides:在这里直接参考官方API吧。很详细!

1 tf.layers.conv2d( 2 inputs, 3 filters, 4 kernel_size, 5 strides=(1, 1), 6 padding='valid', 7 data_format='channels_last', 8 dilation_rate=(1, 1), 9 activation=None, 10 use_bias=True, 11 kernel_initializer=None, 12 bias_initializer=tf.zeros_initializer(), 13 kernel_regularizer=None, 14 bias_regularizer=None, 15 activity_regularizer=None, 16 kernel_constraint=None, 17 bias_constraint=None, 18 trainable=True, 19 name=None, 20 reuse=None 21 )

根据官方API文档说明,tf.layer.con2d的input和padding与tf.nn.conv2d一样。

但也有其它差别:

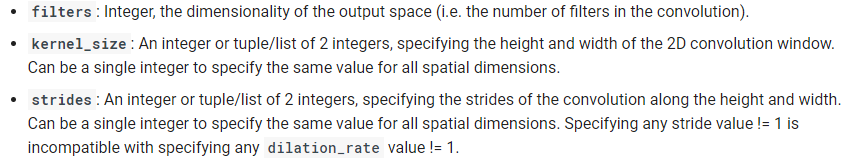

在这里filter为一个整数,该整数的数量为卷积数量 >>>整数,表示输出空间的维数(即卷积过滤器的数量)。

kernel_size,可以是一个整数,或list或tuple类型的两个整数。

strides:一个整数,或者包含了两个整数的元组/队列,表示卷积的纵向和横向的步长。如果是一个整数,则横纵步长相等。另外, strides不等于1 和 dilation_rate 不等于1 这两种情况不能同时存在。