08softmax分类器

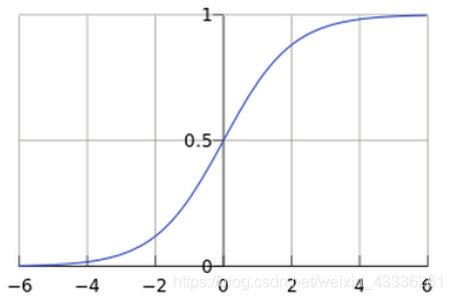

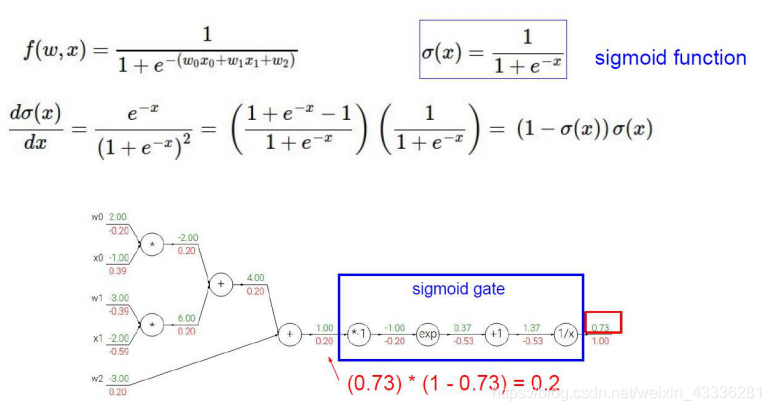

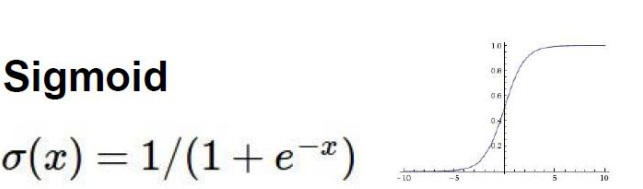

sigmoid函数

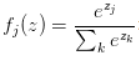

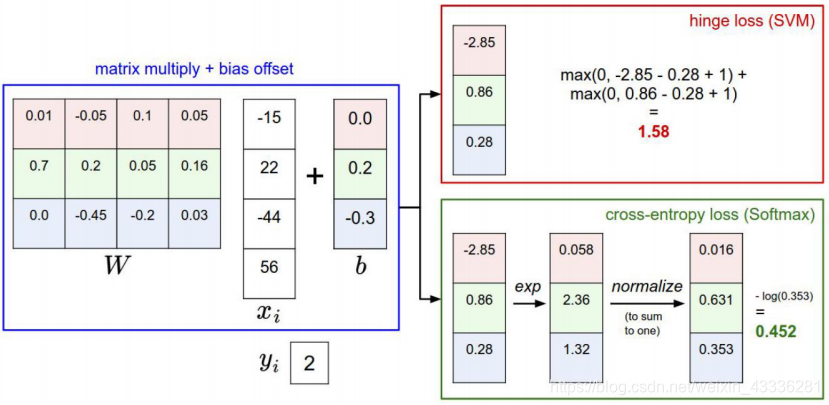

softmax分类器:

Softmax的输出(归一化的分类概率)

归一化参见:python人工智能——机器学习——特征工程 5.数据的特征预处理

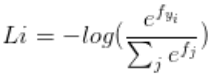

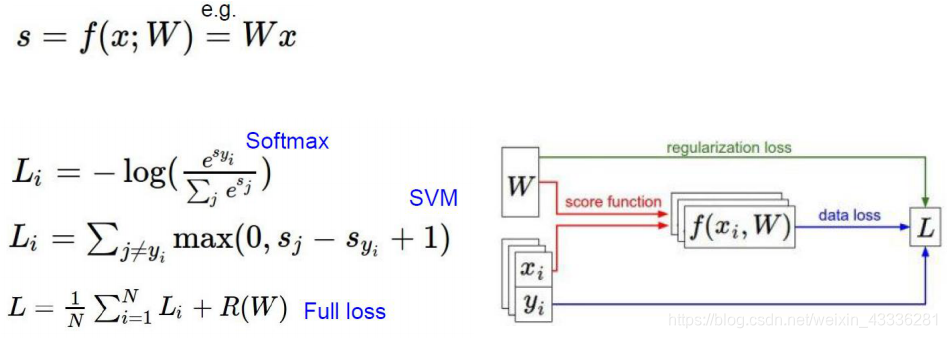

损失函数:交叉熵损失(cross-entropy loss)

被称作softmax 函数

被称作softmax 函数

其输入值是一个向量,向量中元素为任意实数的评分值。

输出一个向量,其中每个元素值在0到1之间,且所有元素之和。

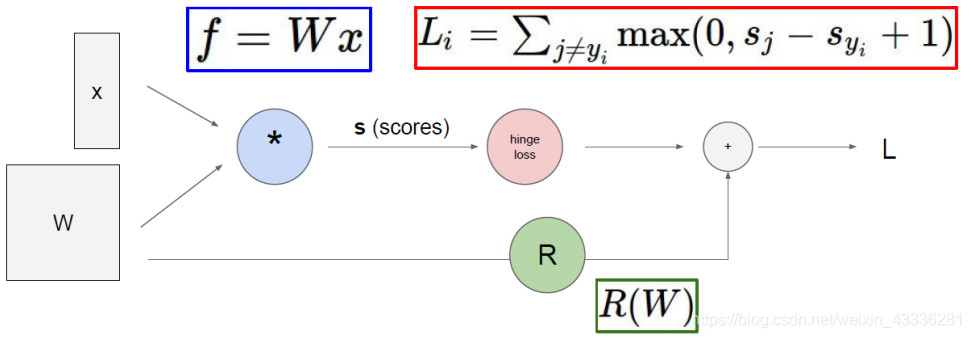

softmax分类的损失函数

损失函数对比

09最优化形象解读

结合人下山的方式考虑,找到一种下山最快的路径。

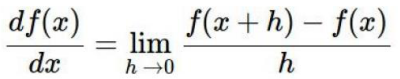

10梯度下降算法原理

跟随梯度

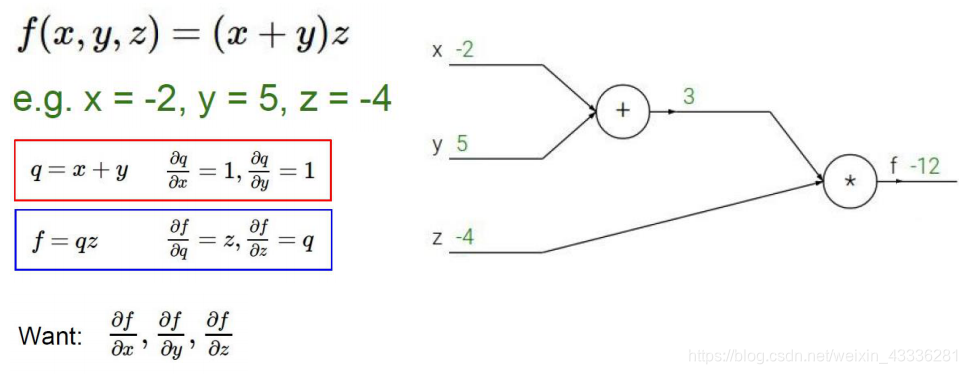

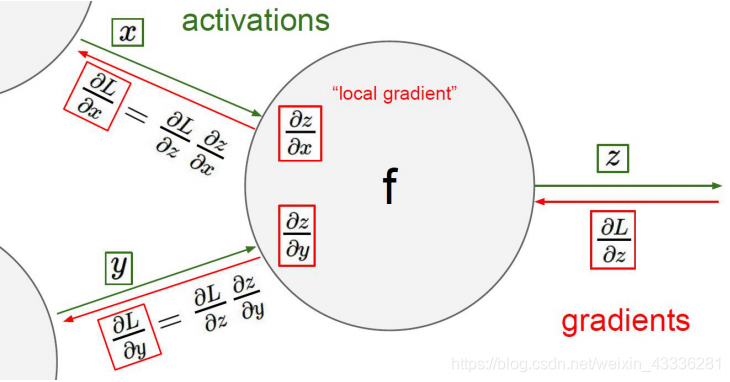

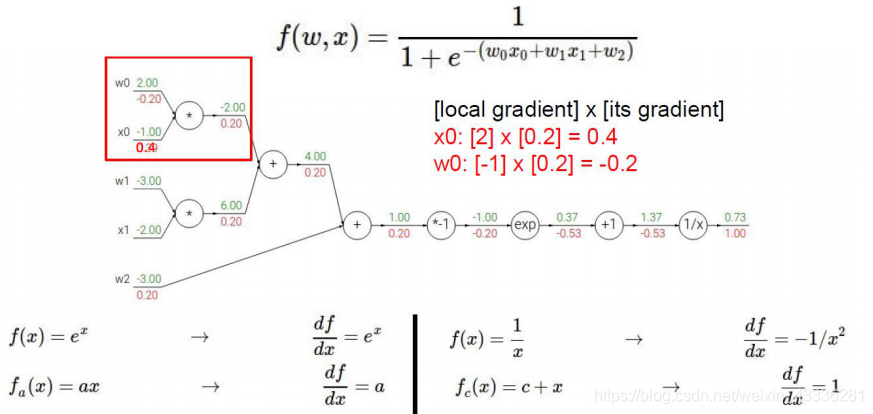

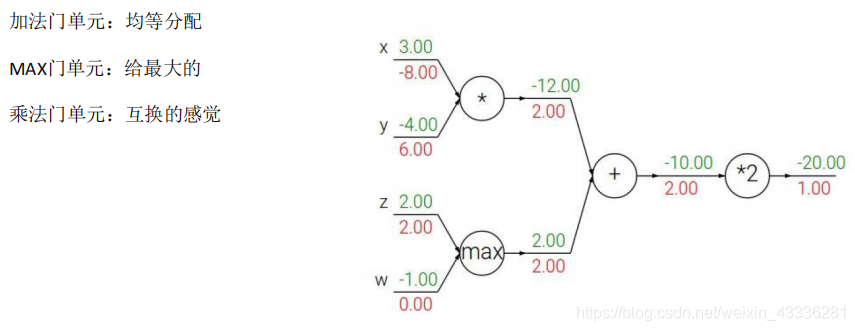

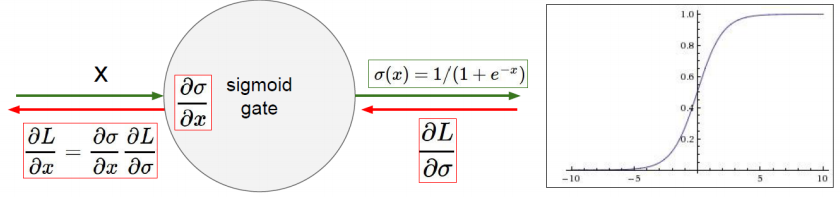

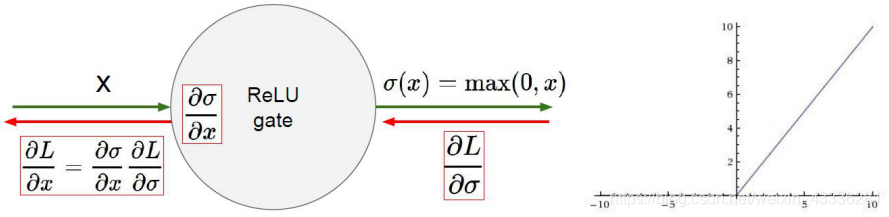

11反向传播

参见:PaddlePaddle训练营——公开课——AI核心技术掌握——第1章迈入现代人工智能的大门——深度学习的基础算法——反向传播算法简介

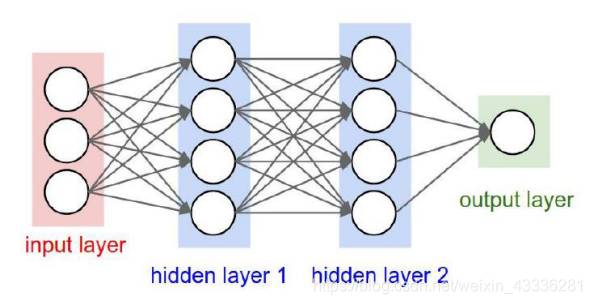

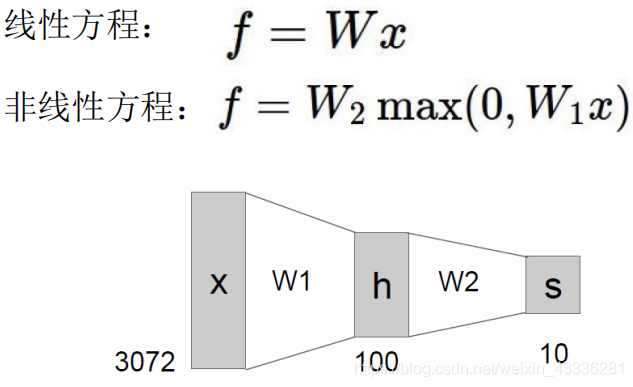

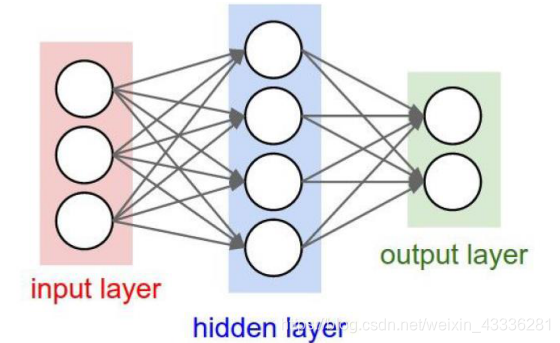

12神经网络整体架构

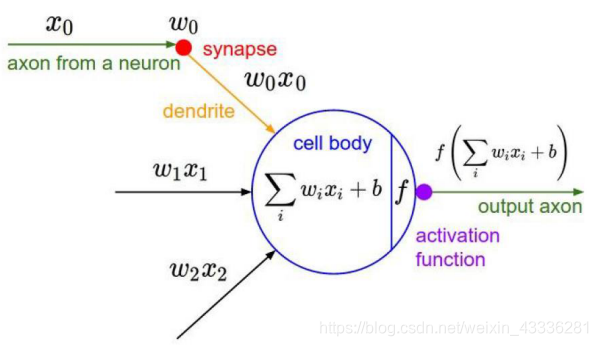

神经网络

激活函数

由于sigmoid会发生梯度消失,因此已经淘汰。

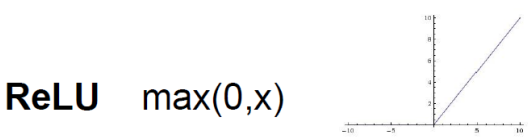

现在常用的激活函数

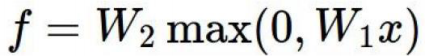

单层神经网络

双层神经网络

n层神经网络

13神经网络模型实例演示

layer_defs = [];

layer_defs.push({type:'input', out_sx:1, out_sy:1, out_depth:2});

layer_defs.push({type:'fc', num_neurons:7, activation: 'tanh'});

layer_defs.push({type:'fc', num_neurons:7, activation: 'tanh'});

layer_defs.push({type:'softmax', num_classes:2});

net = new convnetjs.Net();

net.makeLayers(layer_defs);

trainer = new convnetjs.SGDTrainer(net, {learning_rate:0.01, momentum:0.1, batch_size:10, l2_decay:0.001});

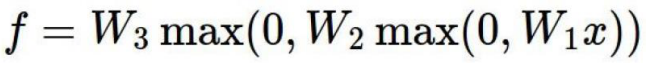

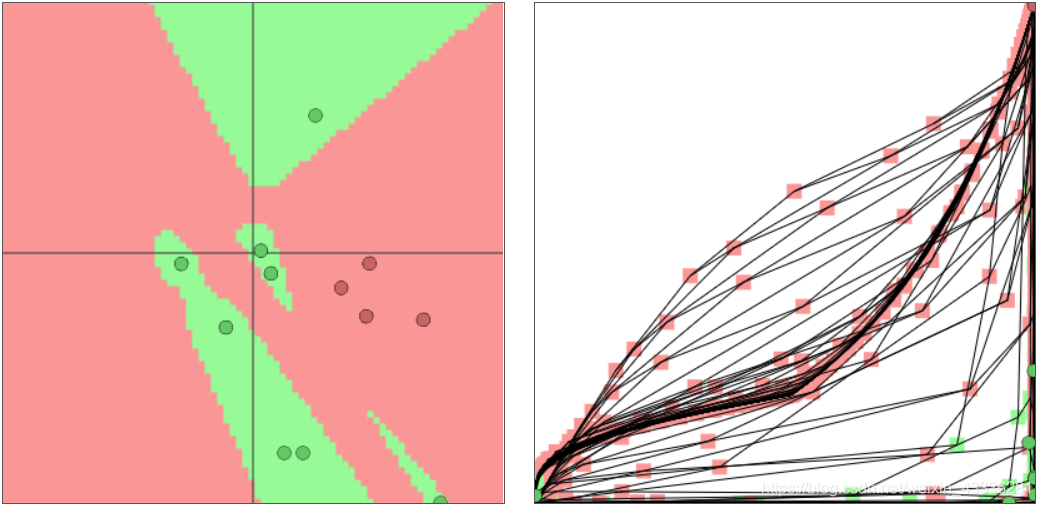

简单数据

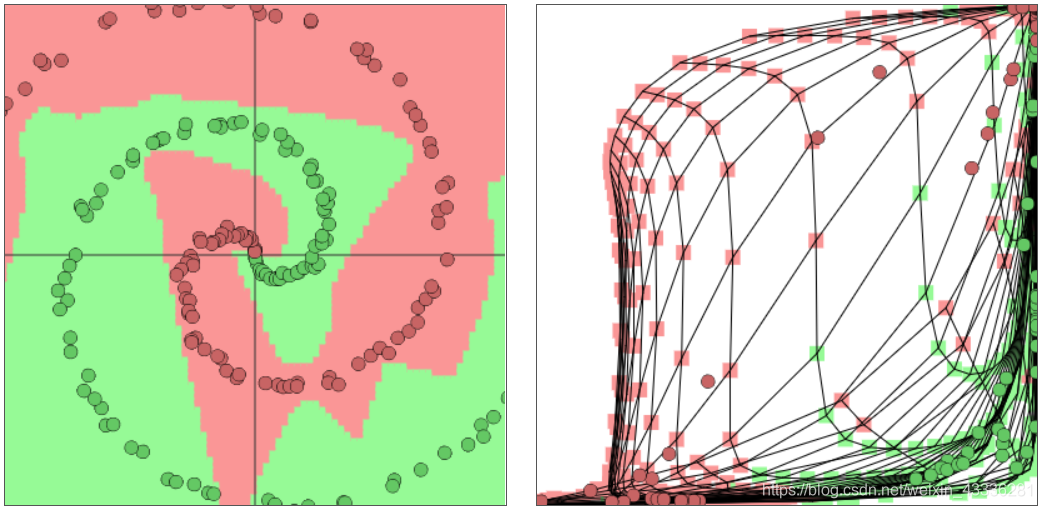

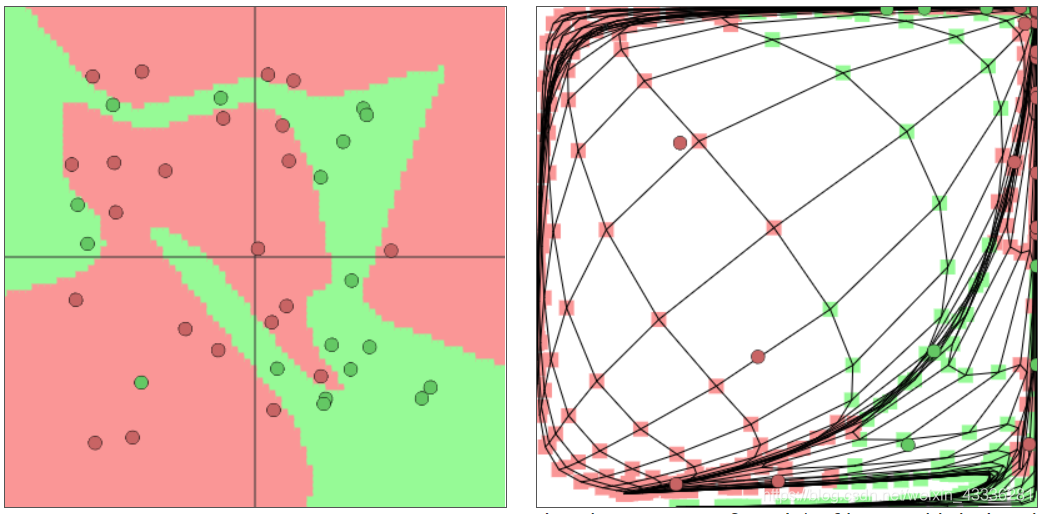

圆形数据

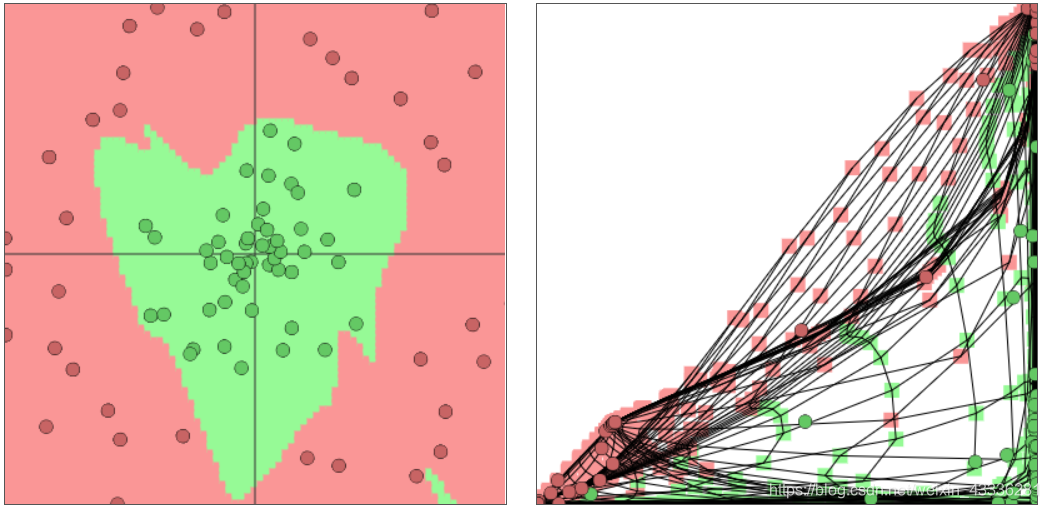

螺旋数据

随机数据

ConvnetJS demo: toy 2d classification with 2-layer neural network

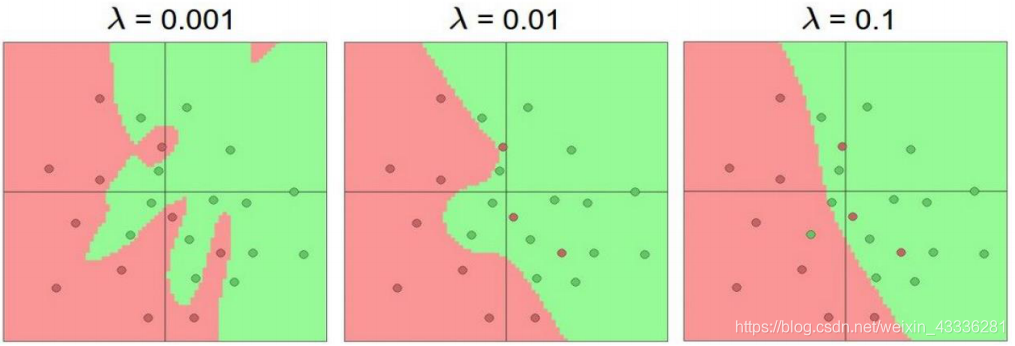

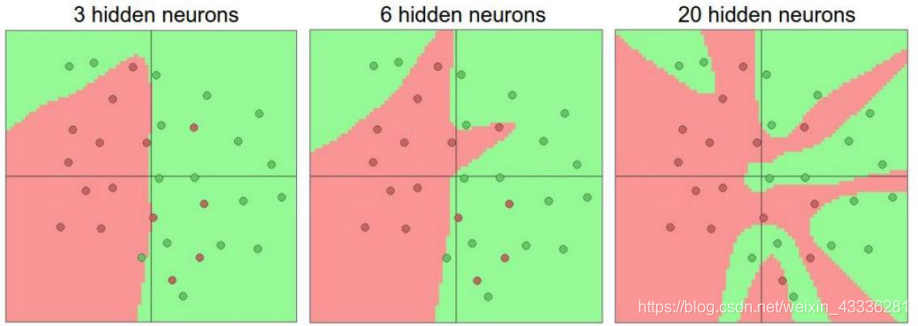

14过拟合问题解决方案

正则化项在神经网络中的重要作用

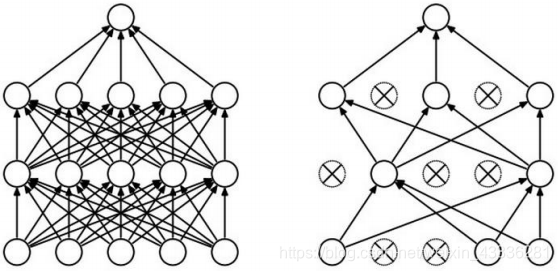

越多的神经元,就越能够表达能复杂的,但是神经元太多会导致过拟合现象,并不能很好的体现泛性的概念,因此要优化正则化项。

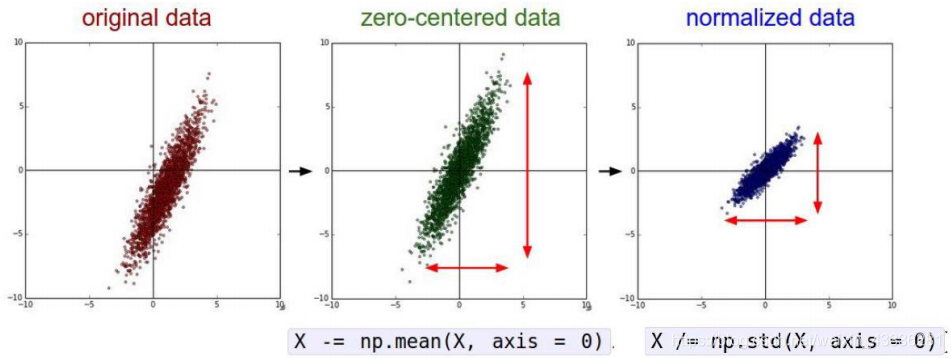

数据预处理

参见:python人工智能——机器学习——数据的降维

参见:python人工智能——机器学习——特征工程 5.数据的特征预处理

权重初始化

权重要随机初始化!b要全零初始化!

DROP-OUT

解决过拟合的问题