1.读取

2.数据预处理

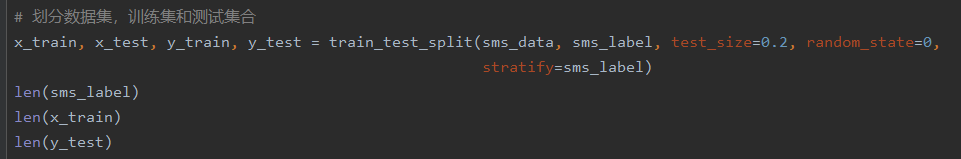

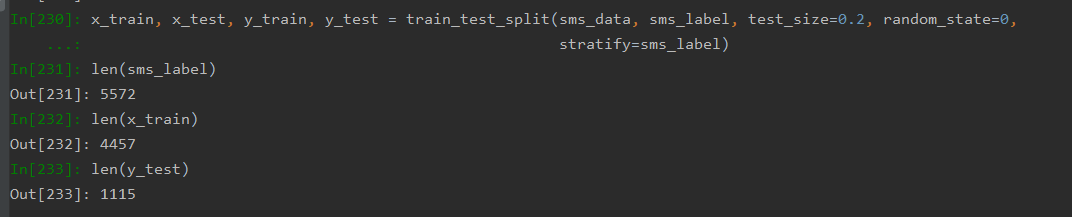

3.数据划分—训练集和测试集数据划分

from sklearn.model_selection import train_test_split

x_train,x_test, y_train, y_test = train_test_split(data, target, test_size=0.2, random_state=0, stratify=y_train)

划分数据集:

划分数据集结果:

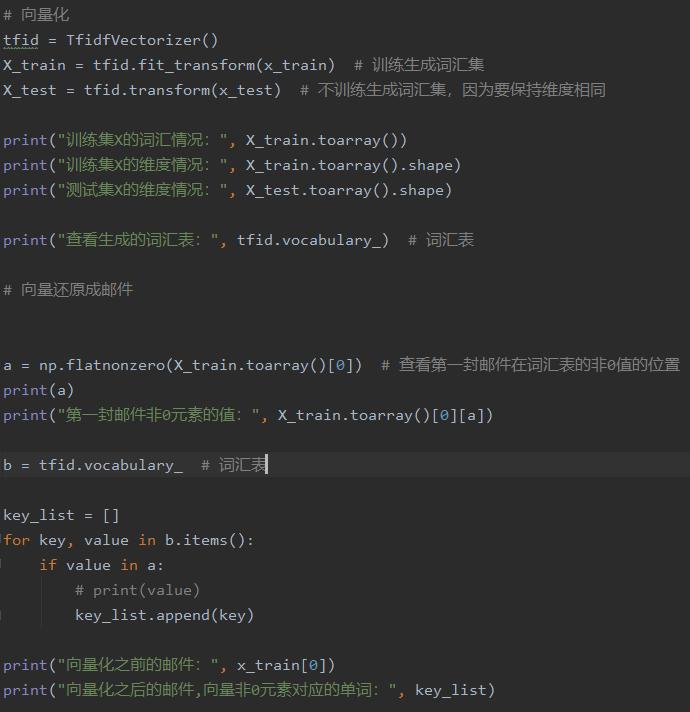

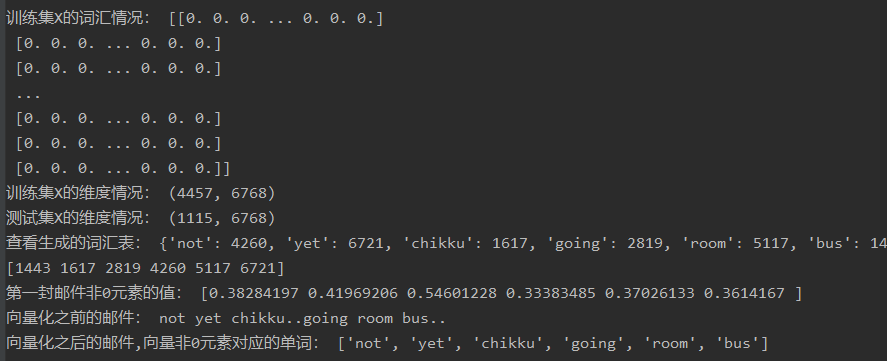

4.文本特征提取

sklearn.feature_extraction.text.CountVectorizer

sklearn.feature_extraction.text.TfidfVectorizer

from sklearn.feature_extraction.text import TfidfVectorizer

tfidf2 = TfidfVectorizer()

观察邮件与向量的关系

向量还原为邮件

对于每一个训练文本,CountVectorizer只考虑每种词汇在该训练文本中出现的频率,而TfidfVectorizer除了考量某一词汇在当前训练文本中出现的频率之外,同时关注包含这个词汇的其它训练文本数目的倒数。

相比之下,邮件训练数量较多,且邮件分类需要考虑到别的邮件的词汇出现次数,TfidfVectorizer这种特征量化方式就更有优势,向量化更加有效。

使用TfidfVectorizer进行向量化:

向量化结果:

4.模型选择

from sklearn.naive_bayes import GaussianNB

from sklearn.naive_bayes import MultinomialNB

说明为什么选择这个模型?

一般来说,如果样本特征的分布大部分是连续值,使用GaussianNB会比较好,高斯分布呈正态分布。如果如果样本特征的分大部分是多元离散值,使用MultinomialNB比较合适。

根据邮件分类的情况上看,数据呈现的是多元离散值,不是连续值,且邮件数据不符合正太分布特征,因为每个单词在邮件中出现的次数并不是固定的,高斯型分布模型不适合该应用场景,此处应该选择多项式分布模型。

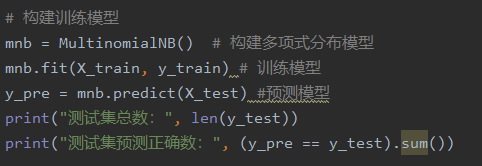

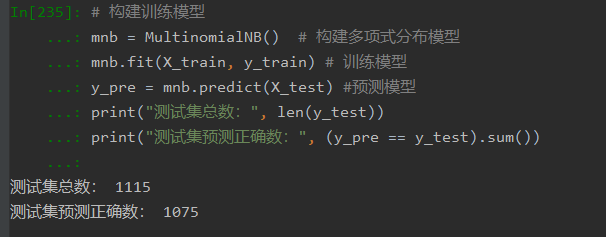

选择多项式分布模型:

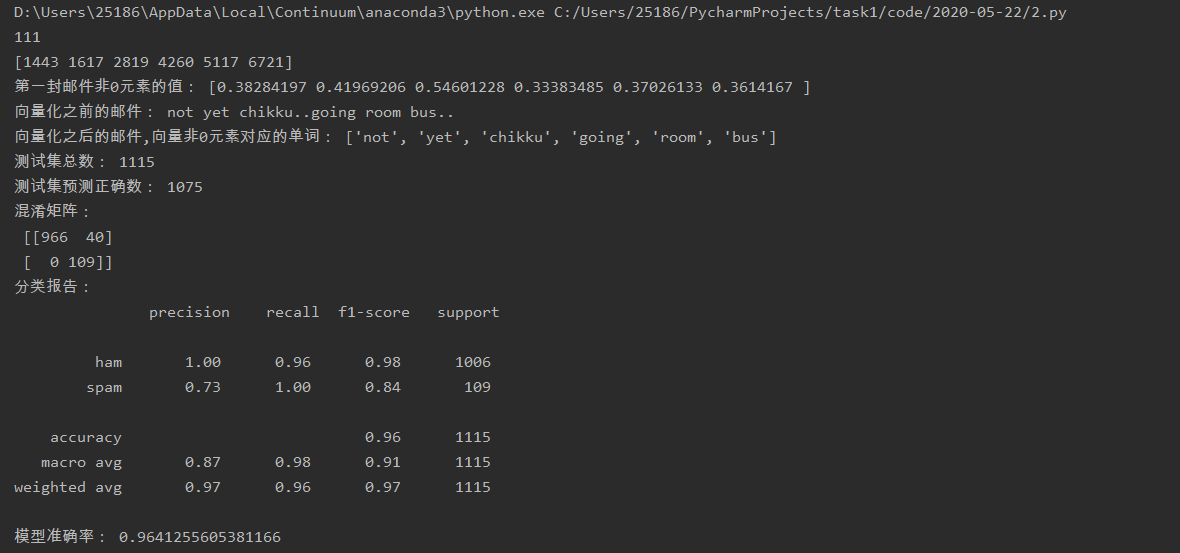

模型预测情况:

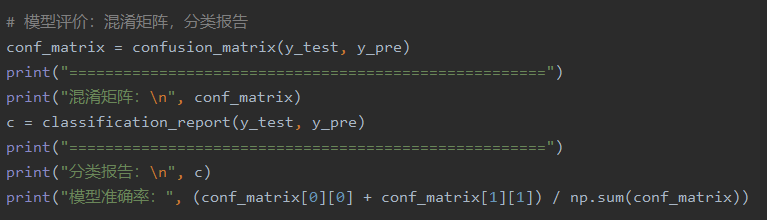

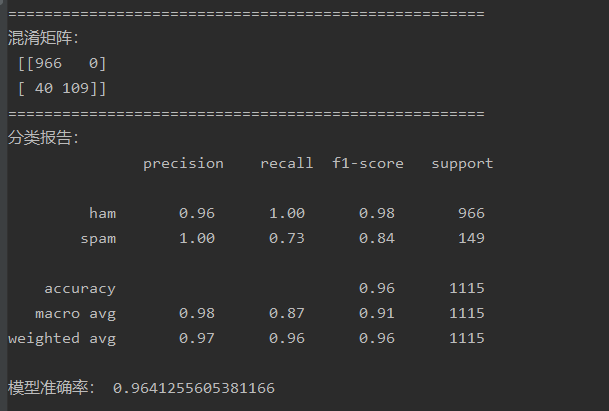

5.模型评价:混淆矩阵,分类报告

from sklearn.metrics import confusion_matrix

confusion_matrix = confusion_matrix(y_test, y_predict)

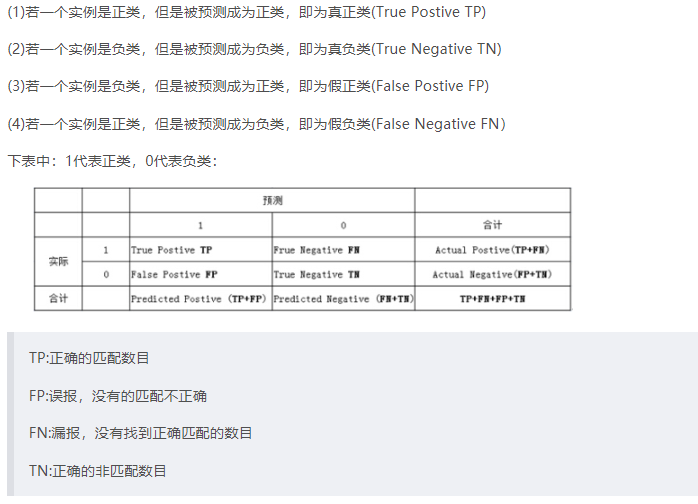

说明混淆矩阵的含义

from sklearn.metrics import classification_report

说明准确率、精确率、召回率、F值分别代表的意义

混淆矩阵的含义:

准确率、精确率、召回率、F值分别代表的意义 :

准确率(正确率)= 所有预测正确的样本/总的样本 (TP+TN)/总 ,其意义是针对整个预测情况。

精确率= 将正类预测为正类 / 所有预测为正类 TP/(TP+FP),其意义是针对分类器判断正例中的正样本的比重。

召回率 = 将正类预测为正类 / 所有正真的正类 TP/(TP+FN),其意义是针对正类的正确覆盖率。

F值 = 精确率 * 召回率 * 2 / ( 精确率 + 召回率) ,其意义是精确率和召回率的调和平均值。

构建评估模型:

模型评估结果:

6.比较与总结

如果用CountVectorizer进行文本特征生成,与TfidfVectorizer相比,效果如何?

对于每一个训练文本,CountVectorizer只考虑每种词汇在该训练文本中出现的频率,而TfidfVectorizer除了考量某一词汇在当前训练文本中出现的频率之外,同时关注包含这个词汇的其它训练文本数目的倒数。

相比之下,邮件训练数量较多,且邮件分类需要考虑到别的邮件的词汇出现次数,TfidfVectorizer这种特征量化方式就更有优势,向量化更加有效。

用CountVectorizer虽在总样本中表现看似比较优秀,但其应用在邮件分类时,进行个体预测的误差要高于使用TfidfVectorizer。

最终代码如下:

# -*- coding:utf-8 -*- import nltk from nltk.corpus import stopwords from nltk.stem import WordNetLemmatizer from sklearn.metrics import confusion_matrix, classification_report from sklearn.model_selection import train_test_split from sklearn.feature_extraction.text import TfidfVectorizer from sklearn.naive_bayes import MultinomialNB import csv import numpy as np # 根据词性,生成还原参数pos def get_wordnet_pos(treebank_tag): if treebank_tag.startswith('J'): # 形容词 return nltk.corpus.wordnet.ADJ elif treebank_tag.startswith('V'): # 动词 return nltk.corpus.wordnet.VERB elif treebank_tag.startswith('N'): # 名词 return nltk.corpus.wordnet.NOUN elif treebank_tag.startswith('R'): # 副词 return nltk.corpus.wordnet.ADV else: return nltk.corpus.wordnet.NOUN # 邮件预处理 def preprocessing(text): # 分词 tokens = [word for sent in nltk.sent_tokenize(text) # 对文本按照句子进行分割 for word in nltk.word_tokenize(sent) # 对句子进行分词 ] # print("去掉停用词前:",len(tokens)) # 处理停用词 stops = stopwords.words("english") # 构建停用器 tokens = [token for token in tokens if token not in stops] # print("去掉停用词后:",len(tokens)) tokens = [token.lower() for token in tokens if len(token) >= 3] # 大小写,短词 tag = nltk.pos_tag(tokens) # 词性标注 # Lemmatisation(词性还原) lmtzr = WordNetLemmatizer() # 定义还原对象 tokens = [lmtzr.lemmatize(token, pos=get_wordnet_pos(tag[i][1])) for i, token in enumerate(tokens)] # 词性还原 preprocessed_text = ' '.join(tokens) return preprocessed_text # 返回处理结果 # 数据预处理 def dataset(): ##数据预处理 filepath = r"C:Users25186PycharmProjects ask1dataSMSSpamCollection" sms = open(filepath, 'r', encoding='utf-8') # 以流形式读取邮件数据集 sms_data = [] # 邮件内容 sms_label = [] # 邮件标题 csv_reader = csv.reader(sms, delimiter=' ') # 对每封邮件进行预处理 for line in csv_reader: # print(line) sms_label.append(line[0]) # 标题 sms_data.append(preprocessing(line[1])) # 每封邮件进行预处理的结果 sms.close() # 关闭读取流 return sms_data, sms_label # 划分数据集 def split_dataset(sms_data, sms_label): x_train, x_test, y_train, y_test = train_test_split(sms_data, sms_label, test_size=0.2, random_state=0, stratify=sms_label) return x_train, x_test, y_train, y_test # 向量化 def tfidf(x_train, x_test): # 向量化 tfidf = TfidfVectorizer() X_train = tfidf.fit_transform(x_train) # 训练生成词汇集 X_test = tfidf.transform(x_test) # 不训练生成词汇集,因为要保持维度相同 return tfidf, X_train, X_test # 向量还原成邮件 def tfidfMail(x_train,X_train,tfidf): a = np.flatnonzero(X_train.toarray()[0]) # 查看第一封邮件在词汇表的非0值的位置 print(a) print("第一封邮件非0元素的值:", X_train.toarray()[0][a]) b = tfidf.vocabulary_ # 词汇表 key_list = [] for key, value in b.items(): if value in a: # print(value) key_list.append(key) print("向量化之前的邮件:", x_train[0]) print("向量化之后的邮件,向量非0元素对应的单词:", key_list) #构建模型 def MnbModel(X_train,X_test,y_train,y_test): Mnb = MultinomialNB() # 构建多项式分布模型 Mnb.fit(X_train, y_train) # 训练模型 y_pre = Mnb.predict(X_test) # 预测模型 print("测试集总数:", len(y_test)) print("测试集预测正确数:", (y_pre == y_test).sum()) return y_pre def checkModel(y_test,y_pre): # 模型评价:混淆矩阵,分类报告 conf_matrix = confusion_matrix(y_test, y_pre)print("混淆矩阵: ", conf_matrix) c = classification_report(y_test, y_pre)print("分类报告: ", c) print("模型准确率:", (conf_matrix[0][0] + conf_matrix[1][1]) / np.sum(conf_matrix)) if __name__ == "__main__": print("111") sms_data,sms_label = dataset() x_train, x_test, y_train, y_test = split_dataset(sms_data, sms_label) # 划分数据集 tfidf, X_train, X_test = tfidf(x_train, x_test) # 把原始文本转化为tf-idf的特征矩阵 tfidfMail(x_train, X_train, tfidf) # 向量还原成邮件 y_pre = MnbModel(X_train, X_test, y_train, y_test) # 模型选择 checkModel(y_pre, y_test) # 模型评价

代码运行结果: