KafKa的集群搭建

准备3台虚拟机

192.168.140.128 kafka01

192.168.140.129 kafka02

192.168.140.130 kafka03

初始化环境

这里使用的是root账户

1)需要安装jdk、zookeeper

2)kafka的案例安装目录

安装包存放的目录:/export/software

安装程序存放的目录:/export/servers

数据目录:/export/data

日志目录:/export/logs

mkdir -p /export/servers/ mkdir -p /export/software / mkdir -p /export/data / mkdir -p /export/logs /

准备安装包

这里使用的是2.11版本

下载安装包及解压

tar -zxvf kafka_2.11-1.0.0.tgz -C /export/servers/ cd /export/servers/ rm -rf /export/servers/kafka rm -rf /export/logs/kafka/ rm -rf /export/data/kafka mv kafka_2.11-1.0.0 kafka

1) 解压文件

2) 删除之前的安装记录

3) 重命名

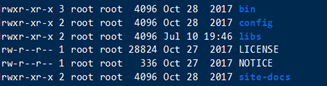

查看目录及修改配置文件

cd /export/servers/kafka_2.11-1.0.0/

linux命令: ll

修改配置文件

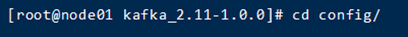

进入配置目录,查看server.properties文件

cd config/

建议使用nodepad++连接后进行修改(没有的同学使用vim)

vim cat server.properties

修改三个地方

1) Broker.id

2) 数据存放的目录,注意目录如果不存在,需要新建下。

3) zookeeper的地址信息

# broker.id 标识了kafka集群中一个唯一broker。 broker.id=0 num.network.threads=3 num.io.threads=8 socket.send.buffer.bytes=102400 socket.receive.buffer.bytes=102400 socket.request.max.bytes=104857600 # 存放生产者生产的数据 数据一般以topic的方式存放 # 创建一个数据存放目录 /export/data/kafka --- mkdir -p /export/data/kafkad得有这个目录,第一步要你创建的 log.dirs=/export/data/kafka num.partitions=1 num.recovery.threads.per.data.dir=1 offsets.topic.replication.factor=1 transaction.state.log.replication.factor=1 transaction.state.log.min.isr=1 log.retention.hours=168 log.segment.bytes=1073741824 log.retention.check.interval.ms=300000 # zk的信息 zookeeper.connect=zk01:2181,zk02:2181,zk03:2181 zookeeper.connection.timeout.ms=6000 group.initial.rebalance.delay.ms=0

分发配置文件及修改brokerid

将修改好的配置文件,分发到node02,node03上。

先在node02、node03上删除以往的安装记录

rm -rf /export/servers/kafka rm -rf /export/logs/kafka/ rm -rf /export/data/kafka

分发安装包

scp -r /export/servers/kafka/ node02:/export/servers/ scp -r /export/servers/kafka/ node03:/export/servers/

注意修改分发后的broker id需要被修改

Kafka的使用测试

注意:kafka的元数据是存储在zookeeper中,所以必须先启动zookeeper

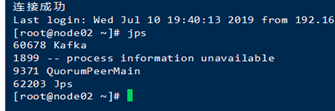

启动集群

cd /export/servers/kafka/bin ./kafka-server-start.sh /export/servers/kafka/config/server.properties

启动成功后,在另一个窗口输入jps查看进程

出现Kafka进程表示成功了