1. Evolution of Language:

1) 不规则过去式随着使用频率的降低在消亡

2)四字成语,新的语言(吃鸡)等对NLP有巨大挑战

2. Calude Shannon:

1)企业发明 通信原理

3. 熵: 信息量增大的函数

1). H(x) >= 0 一件事件x的信息量是大于等于0的

2). H(x) 与 P (x) 成反比 发生概率越小 信息量越大

3) H(x1,x2) 两者联合函数

H(x) = log 1/P(x) = - log P(x)

4) E(H(x)) = - p(x)*log(P(x)) # 积分或者累加

分布越均匀,H(x)越大

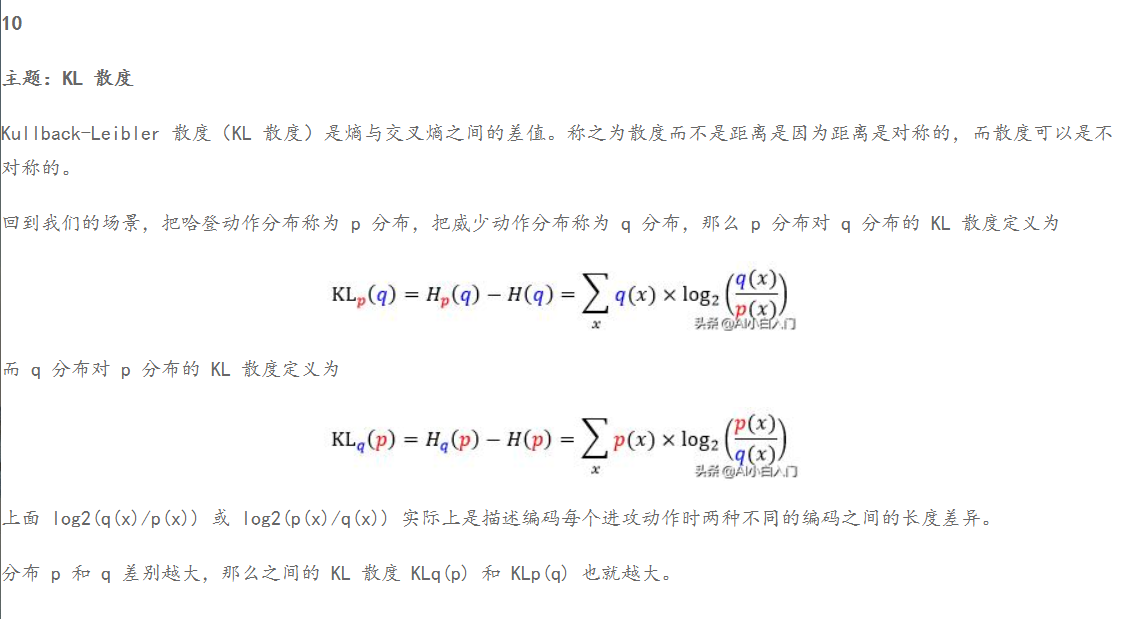

4. KL散度 ;Jensen不等式

http://blog.itpub.net/69946223/viewspace-2685461/

KL(P||Q) != KL(Q||P)

一般使用avgKL(P||Q) = KL(P||Q)+KL(Q||P) / 2

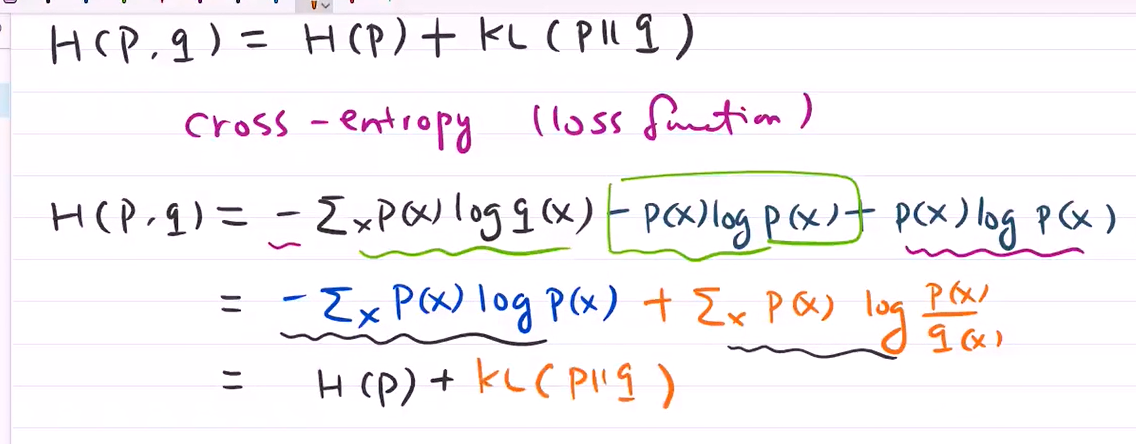

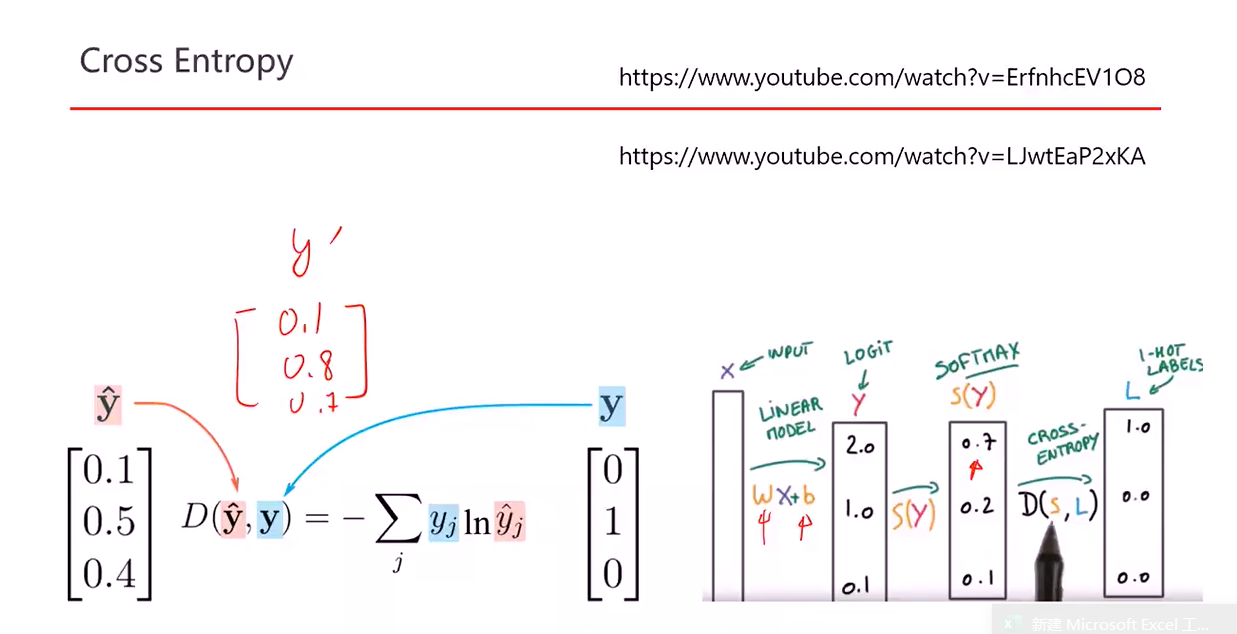

5. 交叉熵

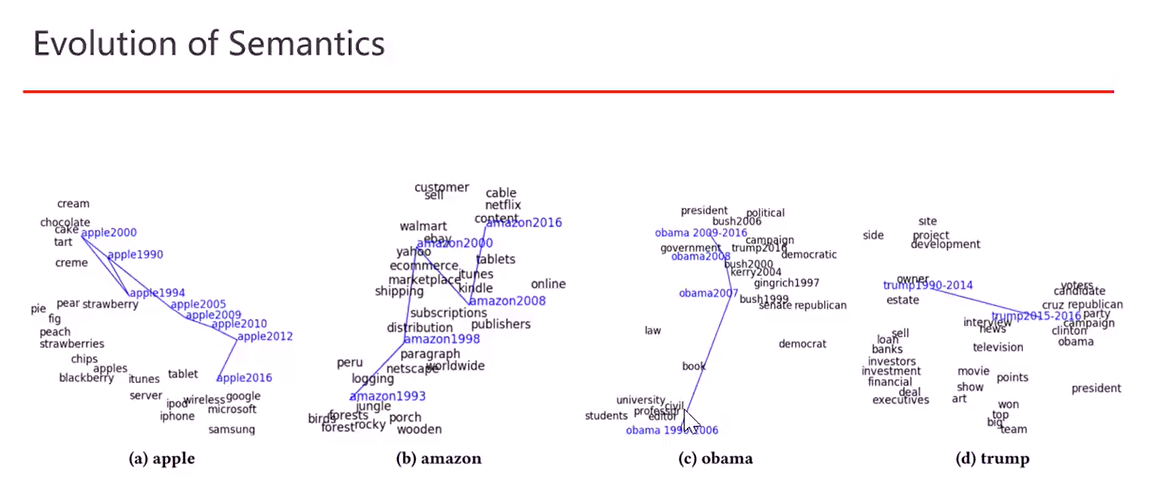

6. semantics语义

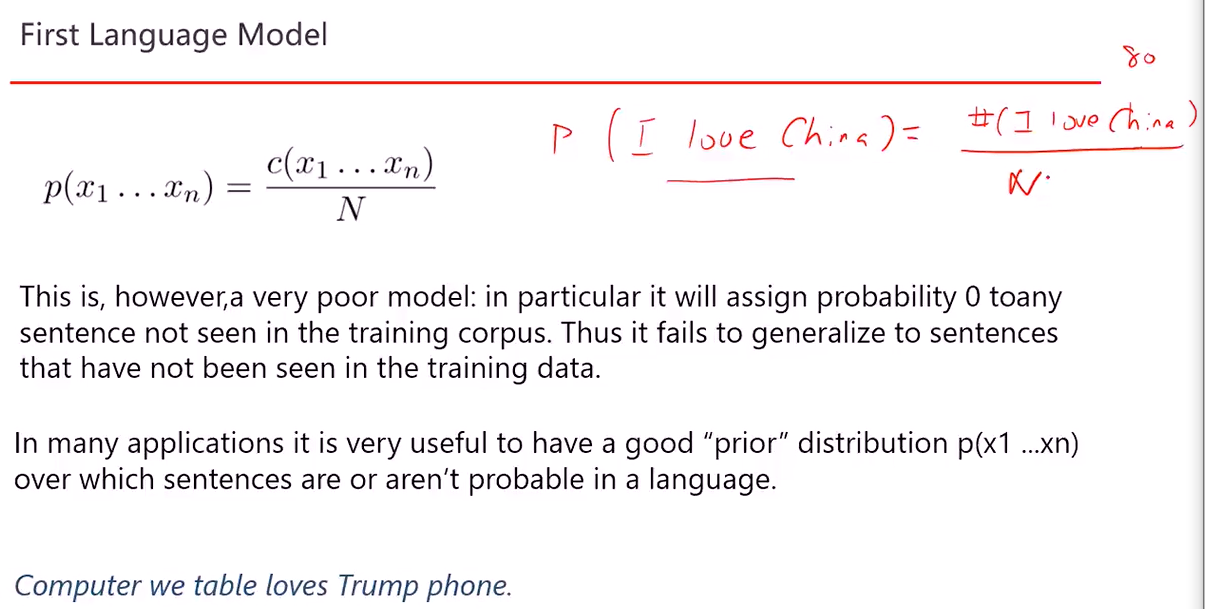

7. P = 3词句子出现概率 / 所有3词句子的总量

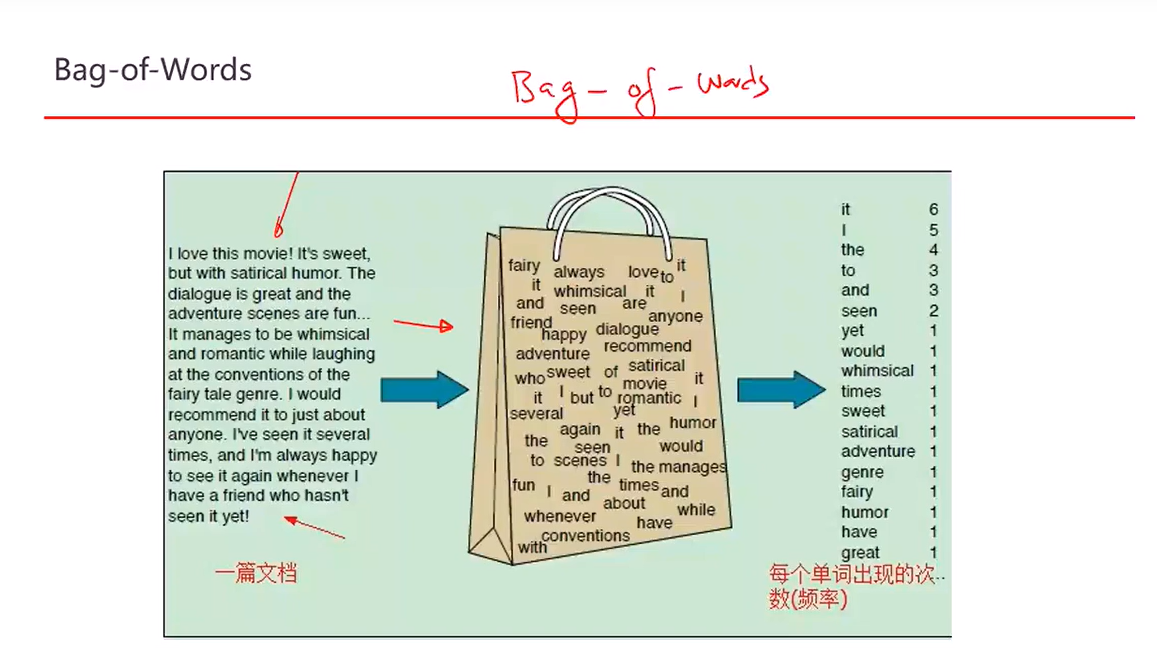

8. Bag - of -Word

P (I Love China )= P(I)P(Love)P(China)

每个单词概率都是独立的,没有条件概率所以不准确

其中 X = 某单词词频(term frequency) / 某单词总词频(idf)

W为训练的权重,图中四个bar chart即为例子

9.