中文分词

- 下载一中文长篇小说,并转换成UTF-8编码。

- 使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

- 排除一些无意义词、合并同一词。

- 对词频统计结果做简单的解读。

import jieba stories = open('蜻蜓眼.txt','r',encoding='utf-8').read() story=list(jieba.cut(stories)) #不统计单词的集合 exp = {'一个','一把','一声','一次','一直'} #键的集合 keys=set(story)-exp #写入字典 dic={} #单词计数字典 for s in keys: if len(s)>1: dic[s]=story.count(s) #(词组,计数)元组的列表 sk = list(dic.items()) #列表排序 sk.sort(key=lambda x:x[1],reverse = True) #输出TOP20元组 for i in range(20): print(sk[i])

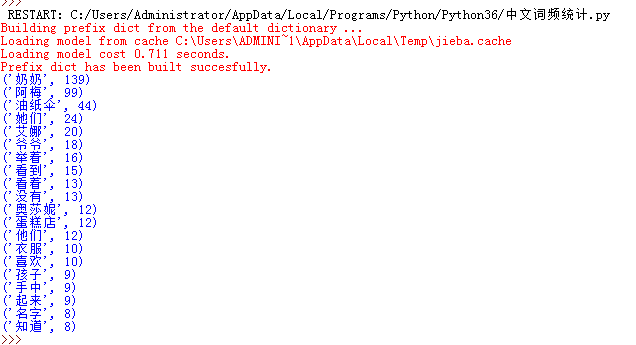

运行结果如图:

统计结果解读:这一章节奶奶与阿梅的出现次数最多,奶奶对油纸伞的喜爱和阿梅对爷爷奶奶的感情贯穿全文。