TensorFlow最初是由Google Brain 团队(隶属于Google的Al部门)中的研究人员和工程师开发的,可为机器学习和深度学习提供强力支持。

一、TensorFlow的基础概念

1.1 TensorFlow计算模型—计算图

TensorFlow是一个通过计算图的形式表述计算的编程系统,每一个计算都是计算图上的一个节点,节点之间的边描述了计算之间的关系。

TensorFlow = Tensor + Flow

Tensor张量

数据结构:多维数组

Flow流

计算模型:张量之间通过计算而转换的过程

TensorFlow有两种边:

- 常规边(实线):代表数据依赖关系。一个节点的运算输出成为另一个节点的输入,两个节点之间有tensor流动(值传递)

- 特殊边(虚线):不携带值,表示两个节点之间的控制相关性。比如,happens-before关系,源节点必须在目的节点执行前完成执行

1.2Tensor 张量

在TensorFlow中,所有的数据都通过张量的形式来表示

从功能的角度,张量可以简单理解为多维数组

零阶张量表示标量(scalar),也就是一个数;

一阶张量为向量(vector),也就是一维数组;

n阶张量可以理解为一个n维数组;

张量并没有真正保存数字,它保存的是计算过程

- 张量的属性

Tensor("Add:0",shape=(),dtype=float32)

名字(name)

“node:src_output”:node节点名称,src_output来自节点的第几个输出

形状(shape)

张量的维度信息,如:shape=() 表示是标量

类型(type)

每一个张量会有一个唯一的类型

TensorFlow会对参与运算的所有张量进行类型的检查,发现类型不匹配时会报错

- 张量的类型

TensorFlow支持14种不同的类型

实数 tf.float32,tf.float64

整数tf.int8,tf.int16,tf.int32,tf.int64,tf.uint8

布尔tf.bool

复数 tf.complex64,tf.complex128

默认类型:

不带小数点的数会被默认为int32

带小数点的会被默认为float32

二、TensorFlow的基本运算

2.1Session会话

会话拥有并管理TensorFlow程序运行时的所有资源,当所有计算完成之后需要关闭会话帮助系统回收资源。

(1)会话的模式1

#定义计算图 tens1=tf.constant([1,2,3]) #创建一个会话 sess = tf.Session() #使用这个创建好的会话来得到关心的运算的结果。比如可以调用sess.run(result) #来得到张量result的收值 print(sess.run(tens1)) #关闭会话使得本次运行中使用到的资源可以被释放 sess.close()

(2)会话的模式2

node1=tf.constant(3.0,tf.float32,name="node1") node3=tf.constant(4.0,tf.float32,name="node2") result = tf.add(node1,node2) #创建一个会话,并通过Python中的上下文管理器来管理这个会话 with tf.Session()as sess: #使用这创建好的会话来计算关心的结果 print(sess.run(result)) #不需要调用 Session.close()函数来关闭会话 #当上下文退出时会话关闭和资源释放也自动完成了

(3)指定默认的会话

TensorFlow不会自动生成默认的会话,需要手动指定

当默认的会话被指定之后可以通过tf.Tensor.eval函数来计算一个张量的取值

node1= tf.constant(3.0,tf.float32,name="node1") node2= tf.constant(4.0,tf.float32,name="node2") result = tf.add(node1,node2) sess= tf.Session() with sess.as_default(): print(result.eval())

2.2常量与变量

常量:在运行过程中值不会改变的单元,在TensorFlow中无须进行初始化操作

创建语句:

constant_name = tf.constant(value)

变量:在运行过程中值会改变的单元,在TensorFlow中须进行初始化操作

创建语句:

name_variable = tf.Variable(value,name) #注意“V”是大写

个别变量初始化:

init_op = name_variable.initializer()

所有变量初始化:

init_op= tf.global_variables_initializer()

例程2.2

node1= tf.Variable(3.e,tf.float32,name="node1") node2 = tf.Variable(4.e,tf.float32,name="node2") result = tf.add(node1,node2,name='add') sess = tf.Session() #变量初始化 init = tf.global_variables_initializer() sess.run(init) print(sess.run((result))

2.3变量赋值

与传统编程语言不同,TensorFlow中的变量定义后,一般无需人工赋值,系统会根据算法模型,训练优化过程中自动调整变量对应的数值。如果对于某变量不想参与更新,需在定义时加上“trainable=False”,如:

epoch =tf.Variable(0,name='epoch",trainable=False)

特殊情况需要人工更新的,可用变量赋值语句

变量更新语句:

update_op=tf.assign(variable_to_be_updated,new_value)

例程2.3

#通过变量赋值输出1、2、3...10 import tensorflow as tf value = tf.Variable(e,name="value") one=tf.constant(1) new_value = tf.add(value,one) update_value = tf.assign(value,new_value) init= tf.global_variables_initializer() with tf.Session() as sess: sess.run(init) for _ in range(10): sess.run(update_value) print(sess.run(value))

2.4占位符

TensorFlow中的Variable变量类型,在定义时需要初始化,但有些变量定义时并不知道其数值,只有当真正开始运行程序时,才由外部输入,比如训练数据,这时候需要用到占位符。

tf.placeholder占位符,是TensorFlow中特有的一种数据结构,类似动态变量,函数的参数、或者C语言或者Python语言中格式化输出时的“%”占位符。

TensorFlow占位符Placeholder,先定义一种数据,其参数为数据的Type和Shape

占位符Placeholder的函数接口如下:

tf.placeholder(dtype,shape=None,name=None)

如:x=tf.placeholder(tf.float32,[2,3],name='tx') #此代码生成一个2x3的二维数纽,矩阵中每个元素的类型都是tf.fLoat32,内部对应的符号名称是tx

2.4.1Feed提交数据

如果构建了一个包含placeholder操作的计算图,当在session中调用run方法时,placeholder占用的变量必须通过feed_dict参数传递进去,否则报错。

例程2.4.1

import tensorflow as tf a= tf.placeholder(tf.float32,name='a') b=tf.placeholder(tf.float32,name='b') c = tf.multiply(a,b,name='c') init = tf.global_variables_initializer() with tf.Session() as sess: sess.run(init) #通过feed_dict的参数传值,按字典格式 result = sess.run(c, feed_dict={a:8.0, b:3.5}) print(result) #结果输出28.0

例程2.4.2 可以一次返回多个值分别赋给多个变量

import tensorflow as tf a=tf.placeholder(tf.float32,name='a') b= tf.placeholder(tf.float32,name='b') c= tf.multiply(a,b,name='c') d =tf.subtract(a,b,name='d') init= tf.global_variables_initializer() with tf.Session() as sess: sess.run(init) #返回的两个做分别赋给两个变量 rc,rd=sess.run([c,d],feed_dict={a:[8.0,2.0,3.5],b:[1.5,2.0,4.]}) print("value of c=",rc,"value of d=",rd) #输出结果 value of c=[ 12. 4. 14.]value of d=[6.5 0. -0.5]

三、TensorFlow可视化初步

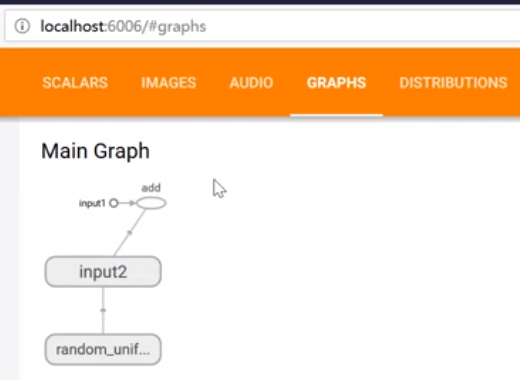

TensorBoard是TensorFlow的可视化工具,原理是通过TensorFlow程序运行过程中输出的日志文件可视化TensorFlow程序的运行状态。另外,TensorBoard和TensorFlow程序跑在不同的进程中。

案例1:在TensorBoard中查看图结构

import tensorflow as tf #清除default_graph和不断增加的节点 tf.reset_default_graph() #Logdir改为自己电脑上的合适路径 logdir='D:/1og' #定义一个简单的计算图,实现向量加法的操作 input1 = tf.constant([1.0,2.0,3.0],name="input1") input2= tf.Variable(tf.random_uniform([3]),name="input2") output = tf.add_n([input1,input2],name="add") #生成一个写日志的writer,并将当前的TensorFLow计算图写入日志。 writer = tf.summary.FileWriter(logdir,tf.get_default_graph()) writer.close()

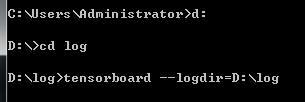

程序运行后,会在指定目录下创建一个日志文件,接着需要启动TensorBoard查看。

在Anaconda Prompt中先进入日志存放的目录,再运行TensorBoard,并将日志的地址指向程序日志输出的地址

命令:tensorboard --logdir=/path/log

启动服务的端口默认为6006;使用一port参数可以改编启动服务的端口

回车后会出现一个网址,用浏览器打开,即可显示上述案例所生成的计算图。