注意 :

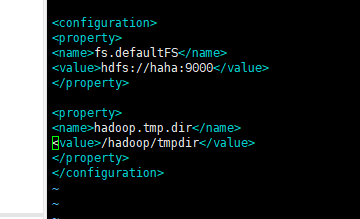

先把原来伪分布式的解压包都删掉 然后重新解压tar包

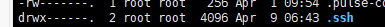

重新删掉.ssh 秘钥文件 重新生成文件 配置免密

cd ~ 》》ls -la 》》 rm -rf .ssh

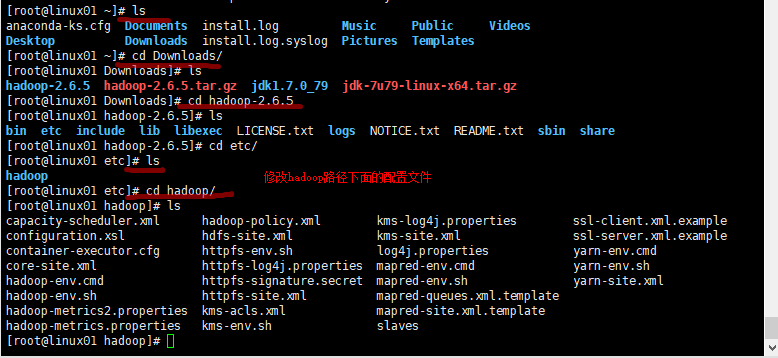

然后hadoop下面的配置文件

1.hadoop-env.sh

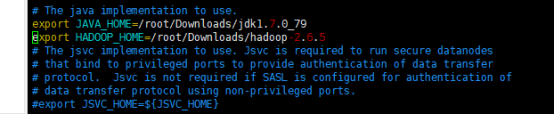

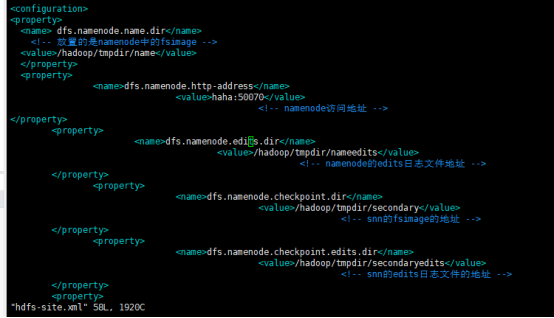

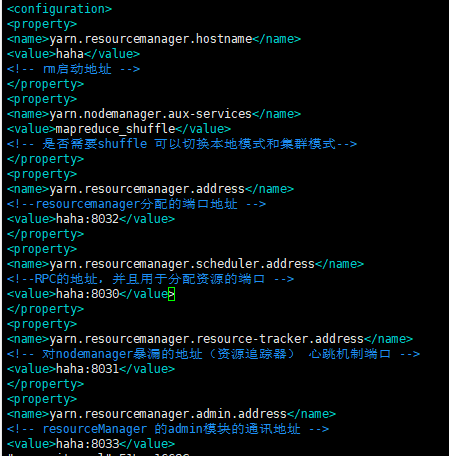

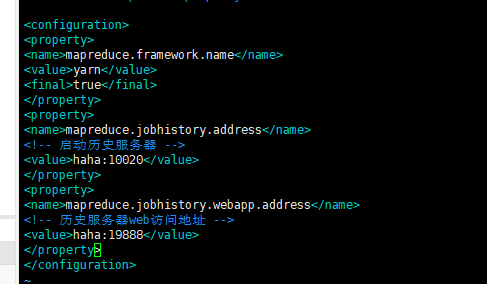

export JAVA_HOME=/root/Downloads/jdk1.7.0_79 export HADOOP_HOME=/root/Downloads/hadoop-2.6.5 2.core-site.xml <property> <name>fs.defaultFS</name> <value>hdfs://linux01:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/hadoop/tmpdir</value> </property> 3 hdfs-site.xml <!--#放置的是namenode中的fsimage--> <property> <name>dfs.namenode.name.dir</name> <value>/hadoop/tmpdir/name</value> </property> <!--#namenode访问地址--> <property> <name>dfs.namenode.http-address</name> <value>linux01:50070</value> </property> <!--#namenode的edits日志文件地址--> <property> <name>dfs.namenode.edits.dir</name> <value>/hadoop/tmpdir/nameedits</value> </property> <!--#snm的fsimage的地址--> <property> <name>dfs.namenode.checkpoint.dir</name> <value>/hadoop/tmpdir/secondary</value> </property> <!--#snm的edits日志文件地址--> <property> <name>dfs.namenode.edits.checkpoint.edits.dir</name> <value>/hadoop/tmpdir/secondaryedits</value> </property> 4 yarn-site.xml <!--#rm启动地址--> <property> <name>yarn.resourcemanager.hostname</name> <value>linux01</value> </property> <!--#是否需要shuffle 可以切换本地模式和集群模式--> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <!--#resourcemanager分配的端口地址--> <property> <name>yarn.resourcemanager.address</name> <value>linux01:8032</value> </property> <!--#RPC的地址,并且用于分配资源的端口--> <property> <name>yarn.resourcemanager.scheduler.address</name> <value>linux01:8030</value> </property> <!--#对nodemanager暴漏的地址(资源追踪器)心跳机制端口--> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>linux01:8031</value> </property> <!--#resourcemanager的admin模块的通讯地址--> <property> <name>yarn.resourcemanager.admin.address</name> <value>linux01:8033</value> </property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<!--web服务器的端口 -->

<value>linux01:8088</value>

</property>

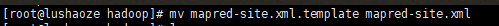

5 mapred-site.xml 注意:这里必须改名,否则不识别

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value> <final>true</final> </property> <!--#启动历史服务器--> <property> <name>mapreduce.jobhistory.address</name> <value>linux01:10020</value> </property> <!--#历史服务器web访问地址--> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>linux01:19888</value> </property> 6修改slaves(从节点指定出来) 7.分发/etc/hadoop 到其他两台机器,其他他两台机器 rm -rf hadoop2.6.5 scp -r hadoop/ root@linux02:/root/Downloads/hadoop-2.6.5/etc scp -r hadoop/ root@linux03:/root/Downloads/hadoop-2.6.5/etc 8.把集群进行格式化 hdfs namenode -format 9.启动机器 start-all.sh

1 修改 hadoop-env.sh

2 修改core-site.xml

3 修改 hdfs-site.xml

4 yarn-site.xml

5 mapred-site.xml

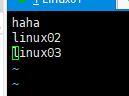

6 修改 slaves (从节点指定出来)

从节点配置三台

7 分发 /etc/hadoop 到其他两台机器 其他两台机器 rm -rf hadoop2.6-

8 把集群进行格式化:hdfs namenode -format

9 免密: ssh-keygen -t rsa ---->.ssh (删除)

9.1 配置haha -->Linux02 ssh-copy-id Linux02 haha->Linux03 Linux02->haha Linux02-》Linux03 Linux03 ->haha Linux03 --->02

自己:ssh-copy-id 自己

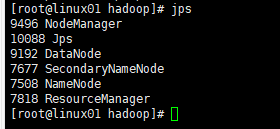

10启动 机器 : start-all.sh (hdfs,yarn) start-dfs.sh start-yarn.sh

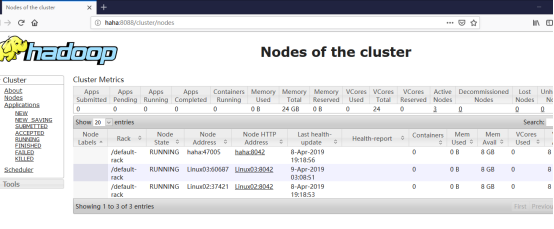

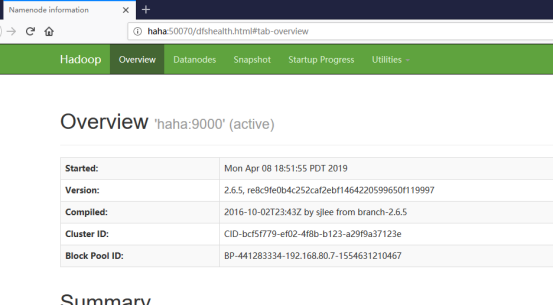

11 web上查看启动的进程

Hdfs:--->主机名:50070

Yarn ---->主机名:8088