目录:

1、简述

2、数学表达

3、总结

1、简述

线性回归是一种 parametric learning algorithm,而局部加权线性回归是一种 non-parametric learning algorithm。Parametric learning algorithm 有固定的(指的是:值的大小是固定)、有限的参数,通过训练样本,找到合适的参数后,对于之后未知的输入,我们可以直接利用这组参数得出其相应的预测输出。而 non-parametric learning algorithm 需要的计算量与输入的训练集大小成正比,对于每次新的输入,需重新计算相应参数后,才能求取相应的预测输出。

“局部加权回归”名称中,之所以叫“局部”是因为目标函数的逼近仅仅根据查询点附近的数据,之所以叫“加权”是因为每一个训练样例的贡献是由它与查询点间的距离加权的,之所以叫“回归”是因为统计学习界广泛使用这个术语来表示逼近实数值函数的问题。

2、数学表达

对于线性回归算法:

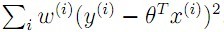

- 对于训练集,求取θ,使得其

最小。

最小。 - 对于新输入x,其预测输出为θTx

对于局部线性加权算法:

- 对于输入x,找到训练集中与x邻域的训练样本

- 对于其邻域的训练样本,求取θ,使得其

( x(i)∈x的邻域 )最小。其中w(i)为权重值

( x(i)∈x的邻域 )最小。其中w(i)为权重值 - 预测输出为θTx

- 对于新输入,重复1-3过程。

其中

![]()

τ 为带宽(bandwidth)常量,距离输入越远,权重越小,反之越大。

3、总结

若对于![]() ,若x(i)为整个训练集,则这种方法所需的计算量随着训练样例数量线性增长,若x(i)∈x的邻域,计算开销独立于训练样例总数,而仅依赖于所考虑的最近邻数。

,若x(i)为整个训练集,则这种方法所需的计算量随着训练样例数量线性增长,若x(i)∈x的邻域,计算开销独立于训练样例总数,而仅依赖于所考虑的最近邻数。

在大多数情况下,h(x)是通过一个常量、线性函数或二次函数来局部逼近目标函数。更复杂的函数形式不太常见,原因是

(1)对每个查询实例用更复杂的函数来拟合,其代价十分高昂

(2)在足够小的实例空间子域上,使用这些简单的近似已能相当好地模拟目标函数。

对于θ的求解过程,可以采用梯度下降的方法,方法与上一节线性回归中介绍的梯度下降方法一样。

参考资料:

1.斯坦福大学公开课课件:http://www.stanford.edu/class/cs229/notes/cs229-notes1.pdf

2.Tom M. Mitchell 《Machine Learning》Chapter8.3