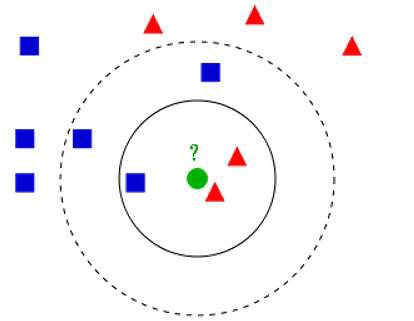

K-近邻算法:

如果K = 3,绿色圆点最近的3个邻居:2个红色三角,和1个蓝色矩形,少数从属多数,基于统计的算法,判定绿色圆点为红色三角一类。

如果K = 5,绿色圆点最近的5个邻居:2个红色三角,和3个蓝色矩形,少数从属多数,基于统计的算法,判定绿色圆点为蓝色矩形一类。

对于未知类别属性数据集中的点:

1.计算已知类别数据集中的点与当前点的距离

2.按照距离依次排序

3.选取与当前点距离最小的K个点

4.确定前K个点所在类别的出现概率

5.返回前K个点出现频率最高的类别作为当前点预测分类。

概述:

KNN 算法本身简单有效,它是一种lazy-learning 算法。

分类器不需要使用训练集进行训练,训练时间复杂度为0。

KNN 分类的计算复杂度和训练集中的文档数目成正比,也就是说,如果训练集中文档总数为n,那么KNN 的分类时间复杂度为O(n)。

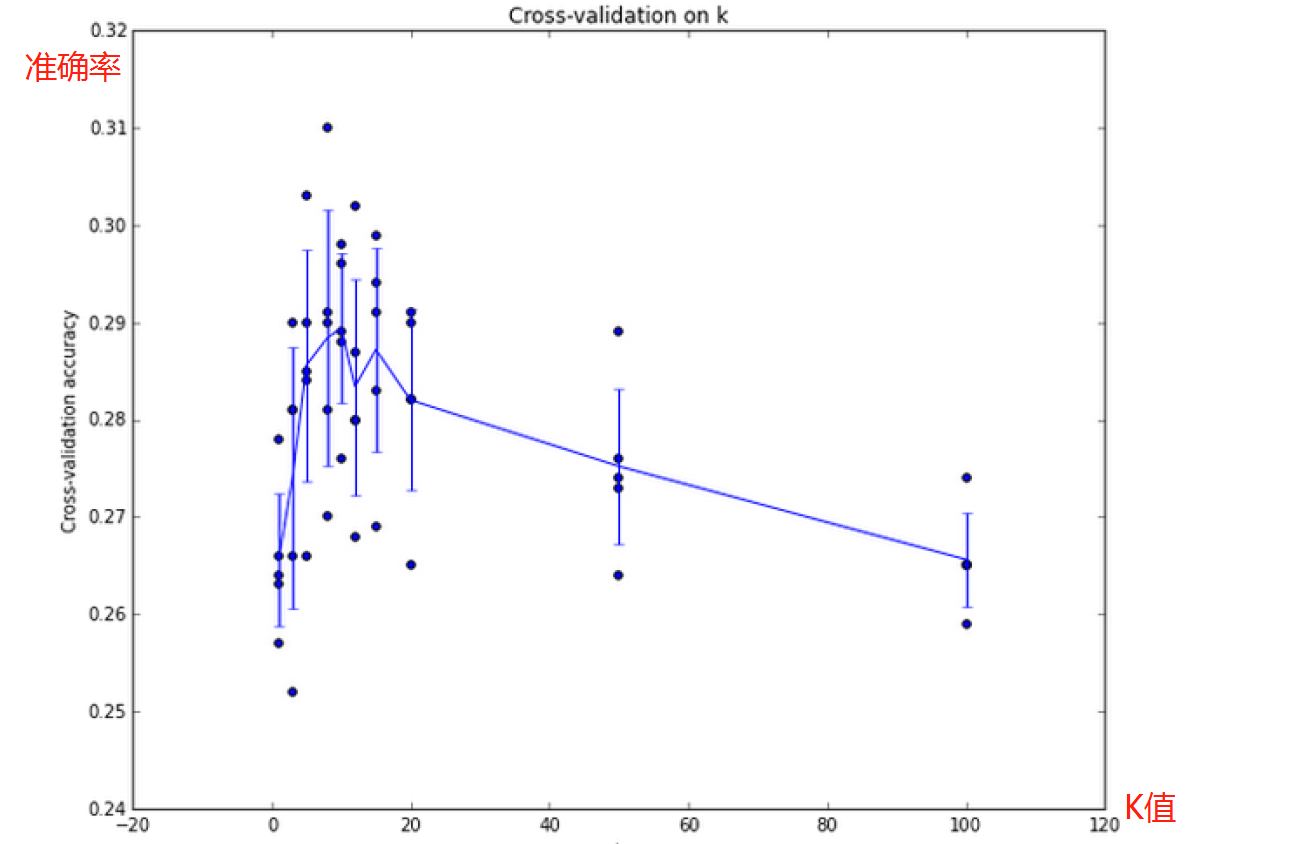

K 值的选择,距离度量和分类决策规则是该算法的三个基本要素

问题:该算法在分类时有个主要的不足是,当样本不平衡时,如一个类的样本容量很大,而其他类样本容量很小时,有可能导致当输入一个新样本时,该样本的K 个邻居中大容量类的样本占多数

解决:不同的样本给予不同权重项.

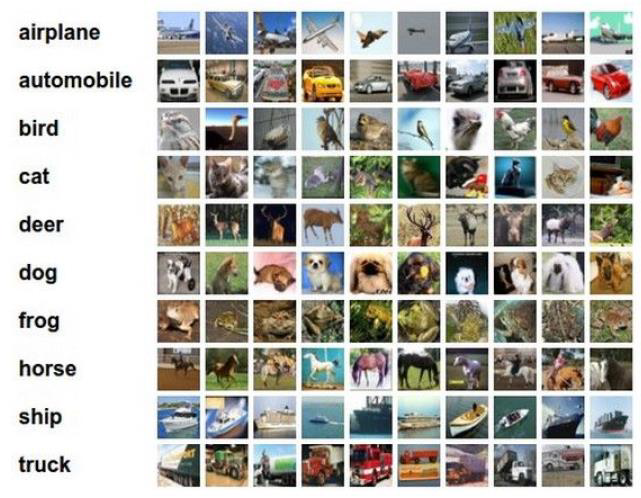

数据集样例:CIFAR-10

10类标签

50000个训练数据

10000个测试数据

大小均为32*32

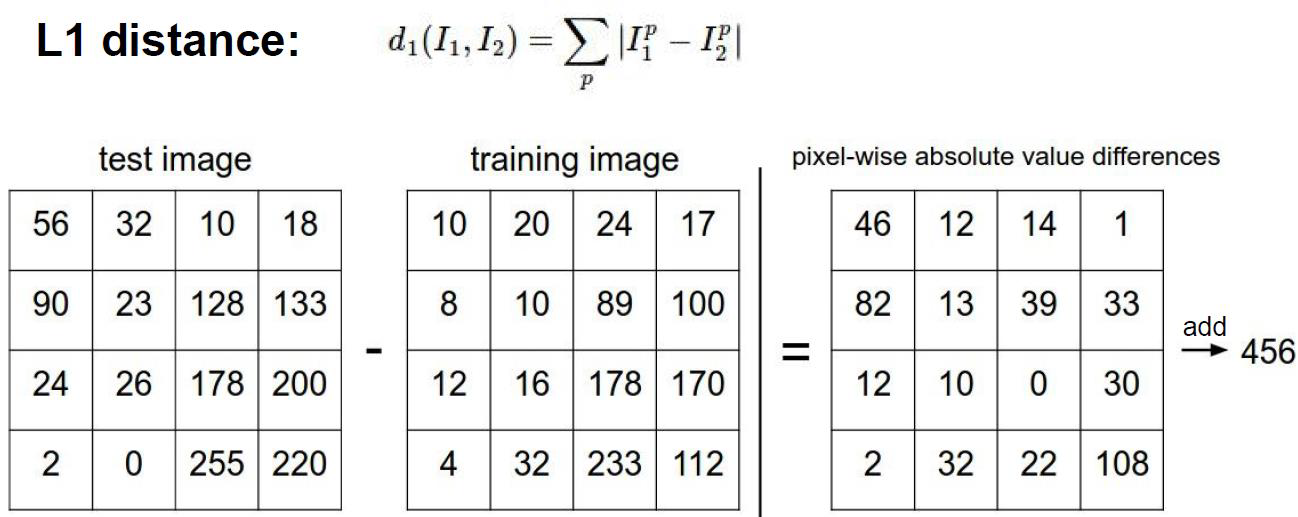

如何计算:

测试数据(像素点)-训练数据(像素点) = 像素点的差异值→和为456

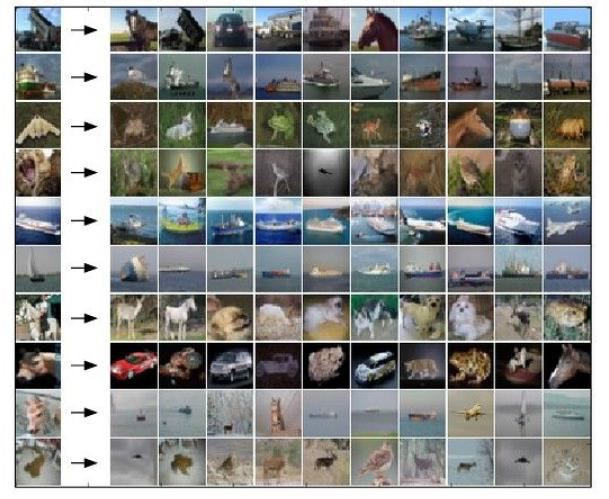

测试结果:

可见,结果并不准确。

超参数:

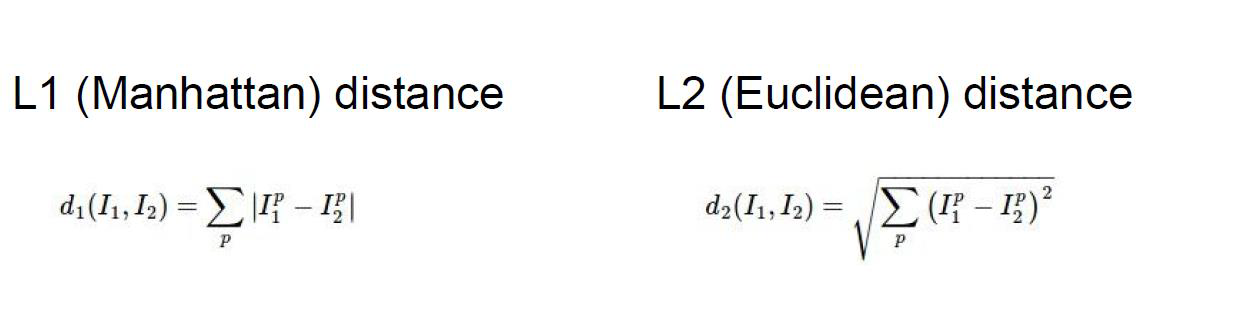

L1是曼哈顿距离,就是单纯的绝对值

L2是欧几里得距离,

问题:

1.对于距离如何设定?

2.对于K近邻的K该如何选择?

3.如果有的话,其它的超参数该怎么设定呢?

找到最好的参数:

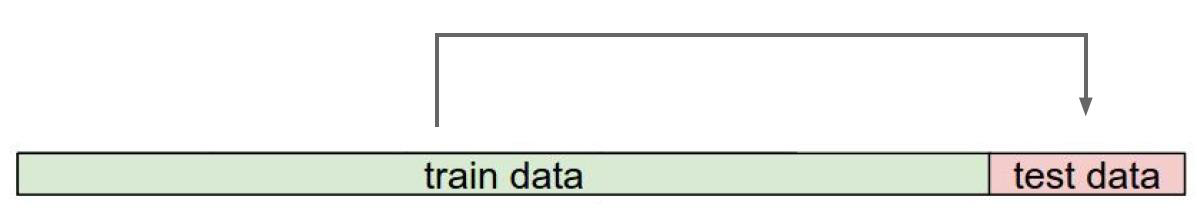

多次用测试数据试验,找到做好的一组参数组合?

这是错误的的想法,因为测试数据只能最终用

解决方法:

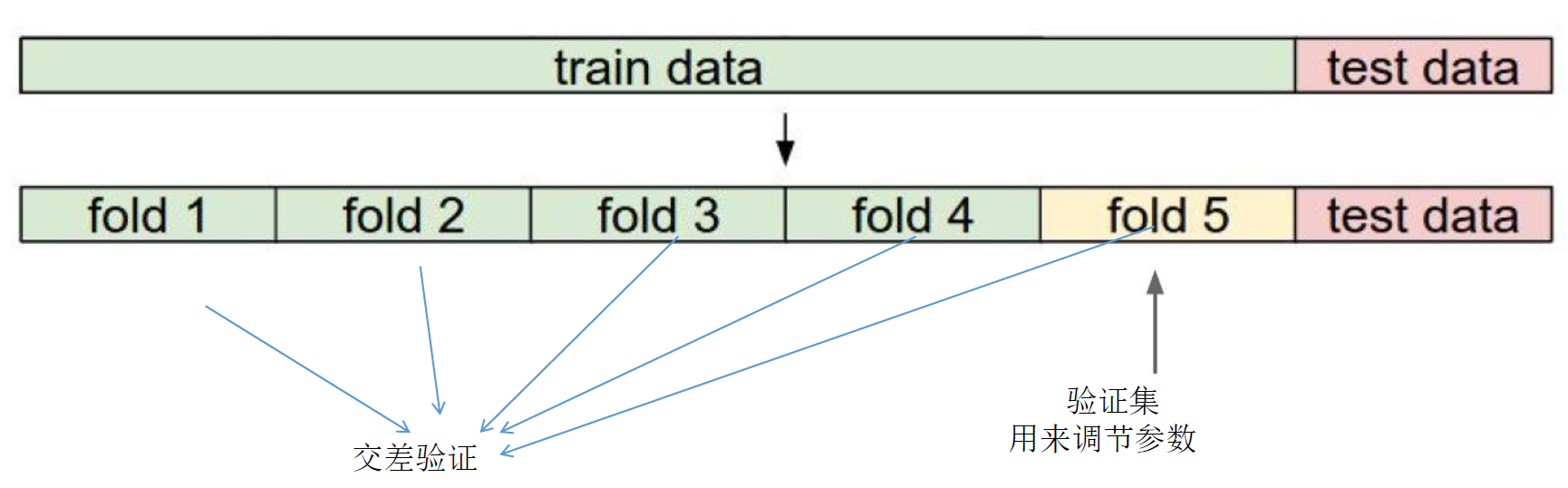

交叉验证

第一次用1,2,3,4训练,用5验证

第二次用1,2,3,5训练,用4验证

。。。。。。

K的选取:

背景主导:

K近邻算法回将背景考虑进去,所以结果会不准确。

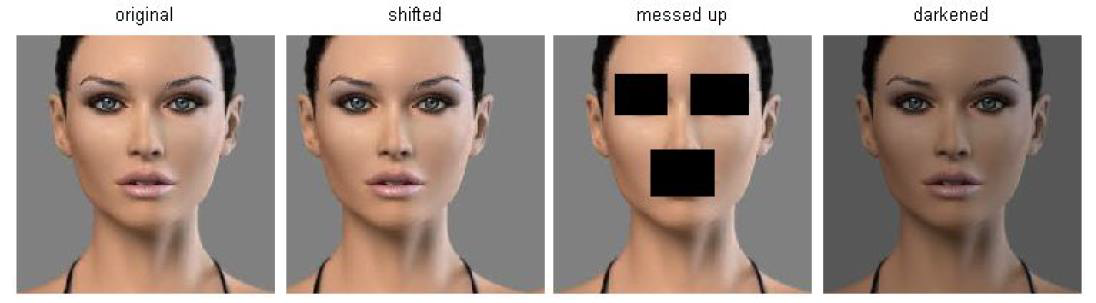

不同的变换和原图具有相同的L2距离:

图2,图3,图4,与原始图片的像素差异相同,但是图234,根本不一样。

所以说,K近邻算法无法完成图像分类任务。