本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

作者: GitPython

PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取

http://note.youdao.com/noteshare?id=3054cce4add8a909e784ad934f956cef

1.获取图片的url链接

首先,打开百度图片首页,注意下图url中的index

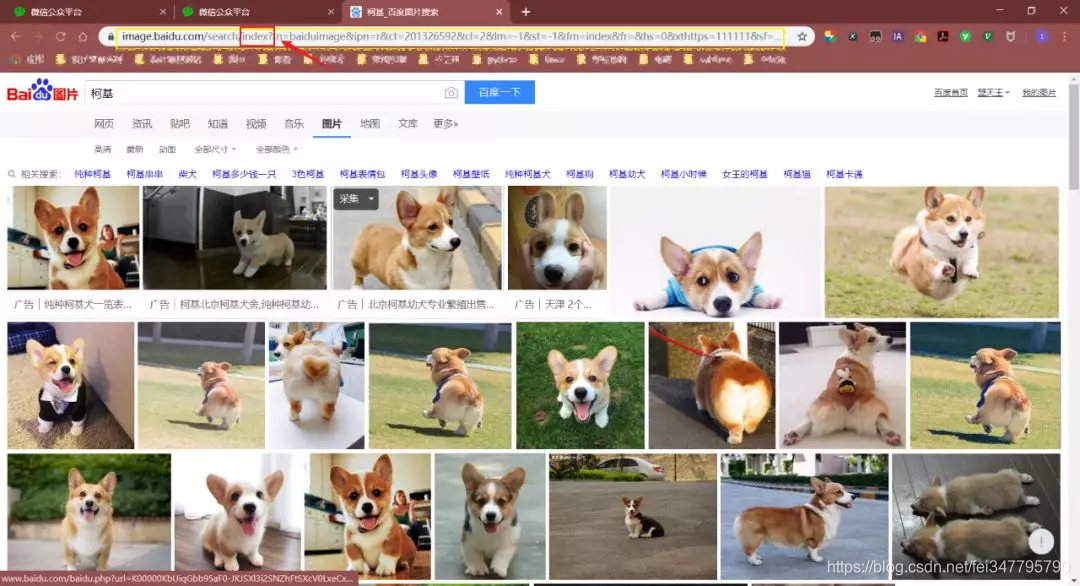

接着,把页面切换成传统翻页版(flip),因为这样有利于我们爬取图片!

对比了几个url发现,pn参数是请求到的数量。通过修改pn参数,观察返回的数据,发现每页最多只能是60个图片。

注:gsm参数是pn参数的16进制表达,去掉无妨

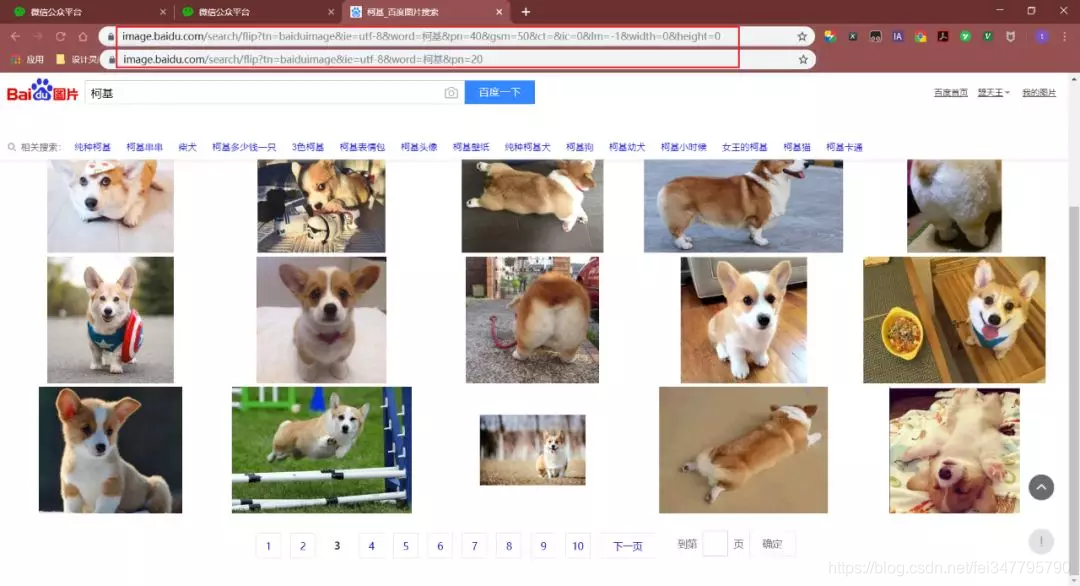

然后,右键检查网页源代码,直接(ctrl+F)搜索 objURL

这样,我们发现了需要图片的url了。

2.把图片链接保存到本地

现在,我们要做的就是将这些信息爬取出来。

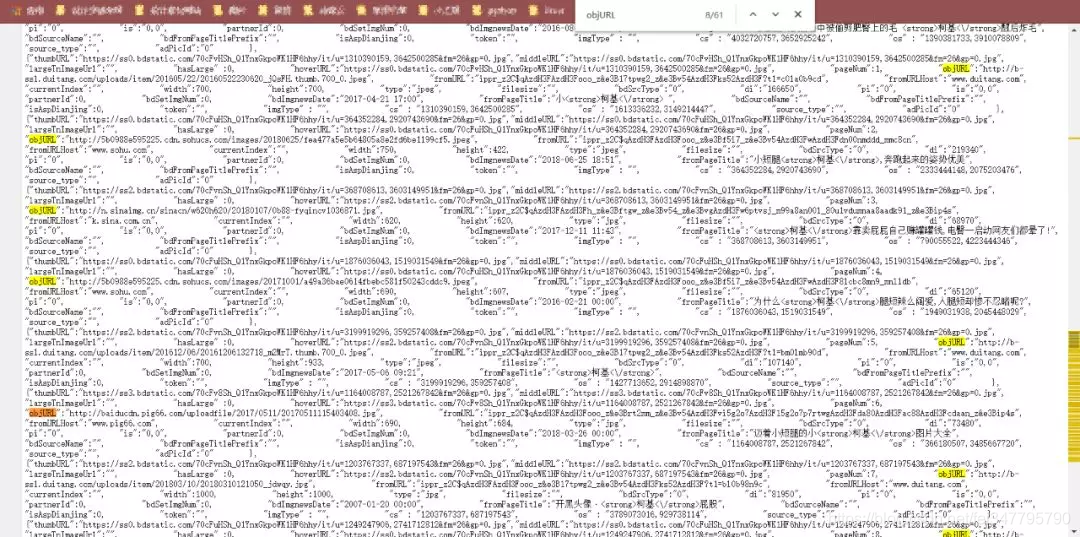

注:网页中有objURL,hoverURL…但是我们用的是objURL,因为这个是原图

那么,如何获取objURL?用正则表达式!

那我们该如何用正则表达式实现呢?其实只需要一行代码…

results = re.findall('"objURL":"(.*?)",', html)

核心代码:

1.获取图片url代码:

1 # 获取图片url连接 2 def get_parse_page(pn,name): 3 4 for i in range(int(pn)): 5 # 1.获取网页 6 print('正在获取第{}页'.format(i+1)) 7 8 # 百度图片首页的url 9 # name是你要搜索的关键词 10 # pn是你想下载的页数 11 12 url = 'https://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=%s&pn=%d' %(name,i*20) 13 14 headers = { 15 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/53.0.2785.104 Safari/537.36 Core/1.53.4843.400 QQBrowser/9.7.13021.400'} 16 17 # 发送请求,获取相应 18 response = requests.get(url, headers=headers) 19 html = response.content.decode() 20 # print(html) 21 22 # 2.正则表达式解析网页 23 # "objURL":"http://n.sinaimg.cn/sports/transform/20170406/dHEk-fycxmks5842687.jpg" 24 results = re.findall('"objURL":"(.*?)",', html) # 返回一个列表 25 26 # 根据获取到的图片链接,把图片保存到本地 27 save_to_txt(results, name, i)

2.保存图片到本地代码:

1 # 保存图片到本地 2 def save_to_txt(results, name, i): 3 4 j = 0 5 # 在当目录下创建文件夹 6 if not os.path.exists('./' + name): 7 os.makedirs('./' + name) 8 9 # 下载图片 10 for result in results: 11 print('正在保存第{}个'.format(j)) 12 try: 13 pic = requests.get(result, timeout=10) 14 time.sleep(1) 15 except: 16 print('当前图片无法下载') 17 j += 1 18 continue 19 20 # 可忽略,这段代码有bug 21 # file_name = result.split('/') 22 # file_name = file_name[len(file_name) - 1] 23 # print(file_name) 24 # 25 # end = re.search('(.png|.jpg|.jpeg|.gif)$', file_name) 26 # if end == None: 27 # file_name = file_name + '.jpg' 28 29 # 把图片保存到文件夹 30 file_full_name = './' + name + '/' + str(i) + '-' + str(j) + '.jpg' 31 with open(file_full_name, 'wb') as f: 32 f.write(pic.content) 33 34 j += 1

3.主函数代码:

1 # 主函数 2 if __name__ == '__main__': 3 4 name = input('请输入你要下载的关键词:') 5 pn = input('你想下载前几页(1页有60张):') 6 get_parse_page(pn,

1 # 配置以下模块 2 import requests 3 import re 4 import os 5 import time 6 7 # 1.运行 py源文件 8 # 2.输入你想搜索的关键词,比如“柯基”、“泰迪”等 9 # 3.输入你想下载的页数,比如5,那就是下载 5 x 60=300 张图片