逻辑回归(Logistic Regression)是一种用于解决二分类(0 or 1)问题的机器学习方法,用于估计某种事物的可能性。比如某用户购买某商品的可能性,某病人患有某种疾病的可能性,以及某广告被用户点击的可能性等。

注意,这里用的是“可能性”,而非数学上的“概率”,logisitc回归的结果并非数学定义中的概率值,不可以直接当做概率值来用。该结果往往用于和其他特征值加权求和,而非直接相乘。

逻辑回归假设因变量 y 服从伯努利分布 (0-1分布);

而线性回归假设因变量 y 服从 正太分布(高斯分布)。

一个机器学习的模型,实际上是把决策函数限定在某一组条件下,这组限定条件就决定了模型的假设空间。当然,我们还希望这组限定条件简单而合理。

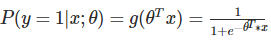

逻辑回归模型所做的假设是:

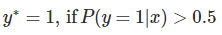

这里的 g(h) 是上边提到的 sigmoid 函数,相应的决策函数为:

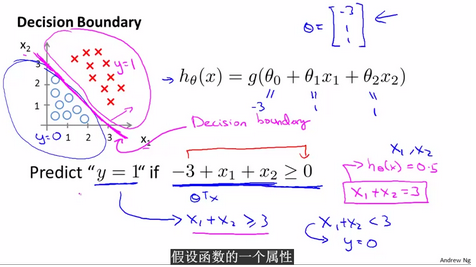

决策边界(Decision Boundary)

决策边界,也称为决策面,是用于在N维空间,将不同类别样本分开的平面或曲面。

首先看Andrew Ng老师课程上的两张图:

线性决策边界:

在逻辑回归中,

假设函数(h=g(z))用于计算样本属于某类别的可能性;

决策函数(h=1(g(z)>0.5))用于计算(给出)样本的类别;

决策边界(θ^Tx=0)是一个方程,用于标识出分类函数(模型)的分类边界。

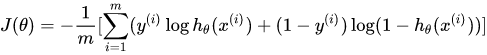

代价函数(Cost Function)

【机器学习】代价函数(cost function)

在逻辑回归中,最常用的是代价函数是交叉熵(Cross Entropy)

代价函数衡量的是模型预测值h(θ) 与标准答案y之间的差异,所以总的代价函数J是h(θ)和y的函数,即,J=f(h(θ), y)。

在线性回归中,最常用的是均方误差(Mean squared error),即