Softmax with cross Entropy

1.softmax应用场景--CNN分类

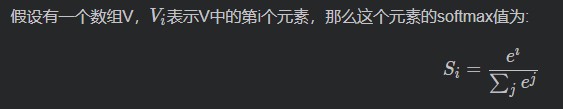

感官上:把不是0-1的数,转为0-1的概率值

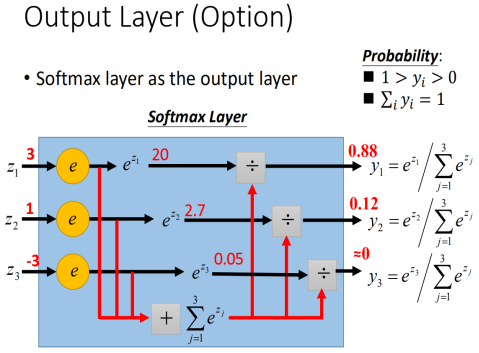

输出层:当抓取到足以用来识别图片的特征后,接下来的就是如何进行分类。输出层主要准备做最后目标结果的输出。

图像目标识别通常使用Softmax输出层,输出各个类别的预测概率。

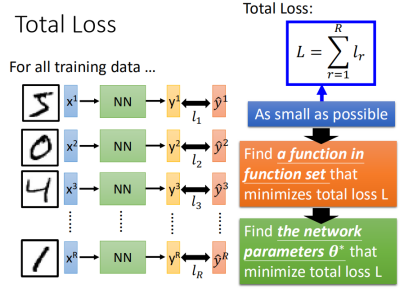

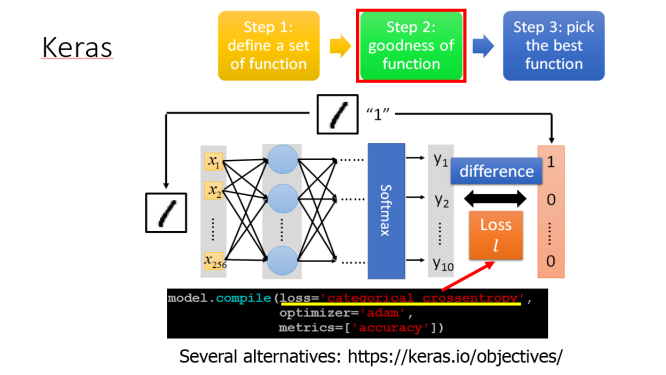

1.1 损失函数:

损失函数(Loss Function):损失函数用于衡量网络的预测输出和真实标签之间的差距。

图像目标识别通常使用互熵损失(Cross Entropy,又称为交叉熵)。交叉熵用于衡量预测概率分布和样本真实标签分布的差异。差异越小,预测分布越接近真实标签分布,其中预测概率最大的类别越可能是正确的类别。

1.2 在CNN的应用

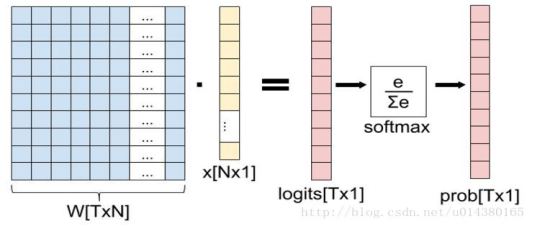

X: 输入特征X是N1的向量,作为网络全连接层的输入,这个特征可以是输入样本的原始信号,或者是全连接层前面多个卷积层和池化层等网络层处理后得到的特征向量。

W:权重矩阵W是TN的矩阵,是全连接层的学习参数,T表示分类的类别数。

Logits:全连接层执行WX,得到一个T1的向量logits,向量的每个数都没有大小限制,取值范围从负无穷到正无穷,可以把它叫做未归一化的概率(如上图的3,-1,-3)。

Prob:归一化的类别预测概率,全连接层后面接一个softmax层,这个softmax的输入是T1的向量Logits ,输出是T*1的向量prob,向量的每个值表示输入样本属于对应类别的概率,取值范围为0到1,即归一化的概率。

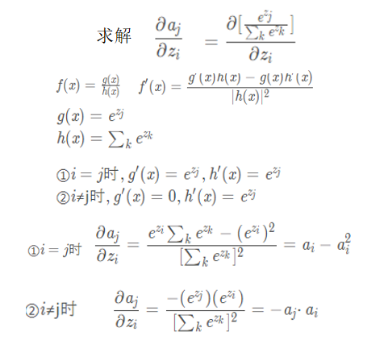

2.Softmax+CE的求导过程

归一化以后的为a_i,未归一化的称为$ e^{z_i} $

Z_i是未归一化的Logit

2.1 求梯度

i=j和i!=j

期望和预测只差,有利于BP反向

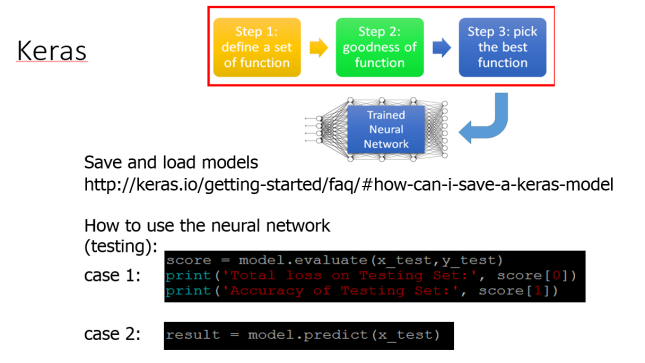

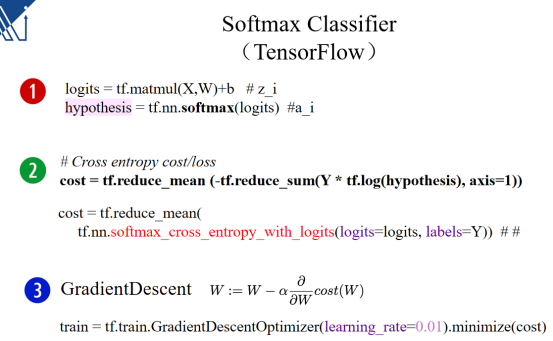

3.Softmax的实际使用

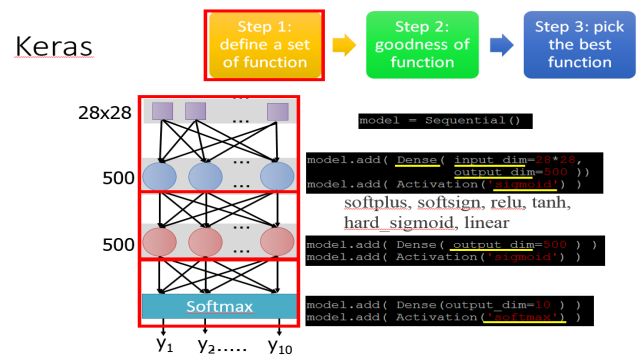

3.1 模型定义:

Model= sequencial() 前馈

非线性激活sigmoid

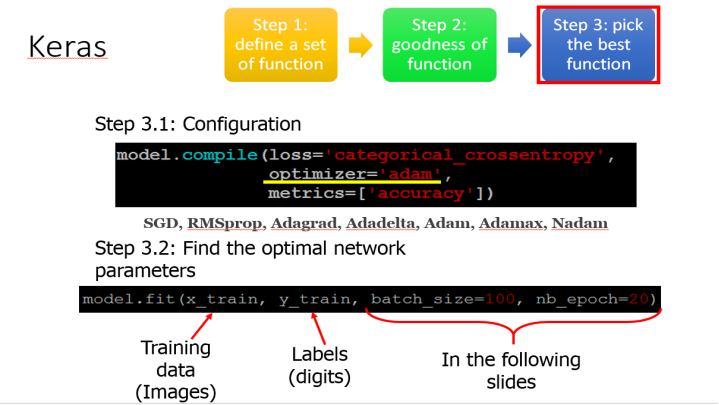

3.2 损失函数

compile编译

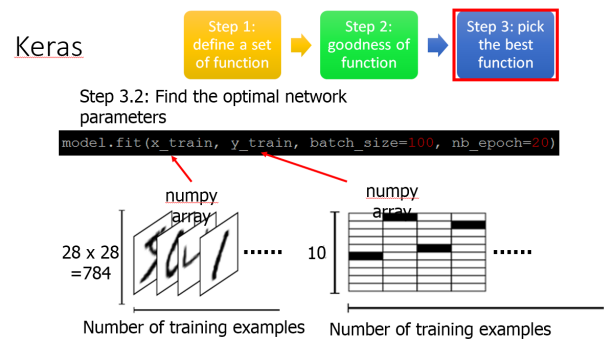

3.3 拟合--训练

3.4 测试

model.evaluate 测试

model.predict 使用