- 聚类

- K-means(K均值聚类)

- 降维

- PCA

K-means原理

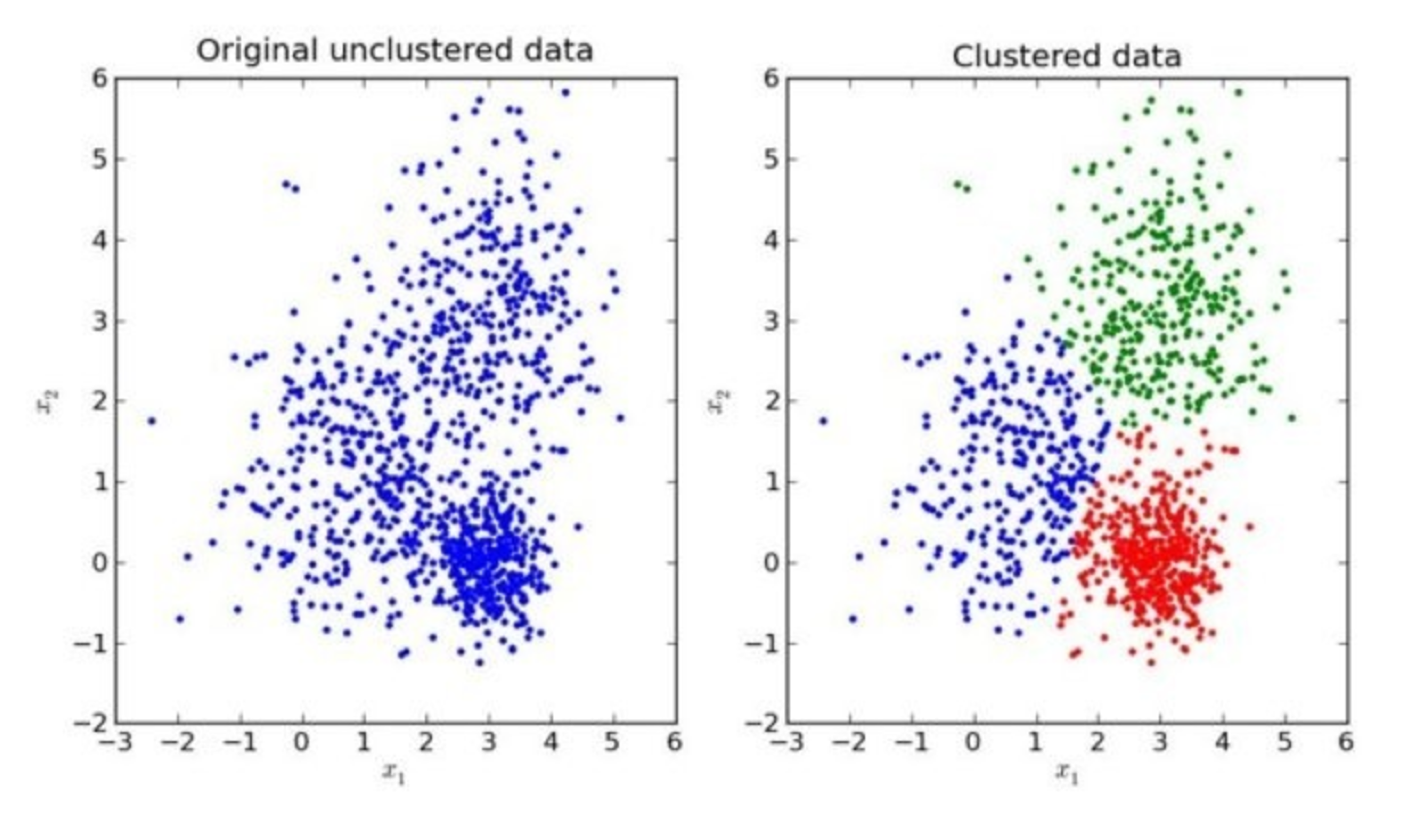

我们先来看一下一个K-means的聚类效果图

K-means聚类步骤

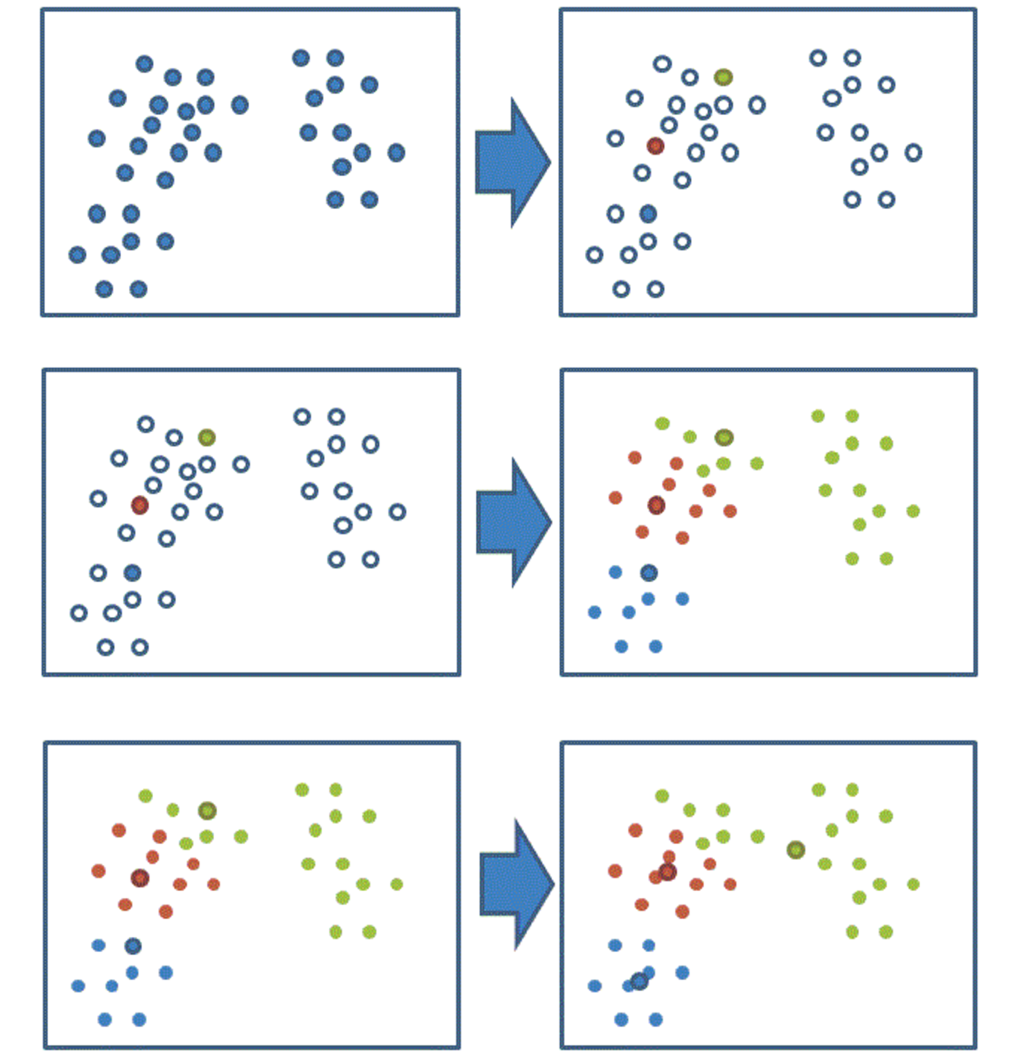

- 1、随机设置K个特征空间内的点作为初始的聚类中心

- 2、对于其他每个点计算到K个中心的距离,未知的点选择最近的一个聚类中心点作为标记类别

- 3、接着对着标记的聚类中心之后,重新计算出每个聚类的新中心点(平均值)

- 4、如果计算得出的新中心点与原中心点一样,那么结束,否则重新进行第二步过程

我们以一张图来解释效果

K-meansAPI

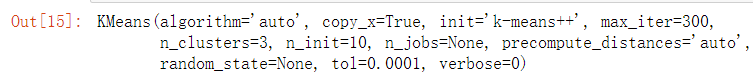

- sklearn.cluster.KMeans(n_clusters=8,init=‘k-means++’)

- k-means聚类

- n_clusters:开始的聚类中心数量

- init:初始化方法,默认为'k-means ++’

- labels_:默认标记的类型,可以和真实值比较(不是值比较)

案例:k-means对Instacart Market用户聚类

分析

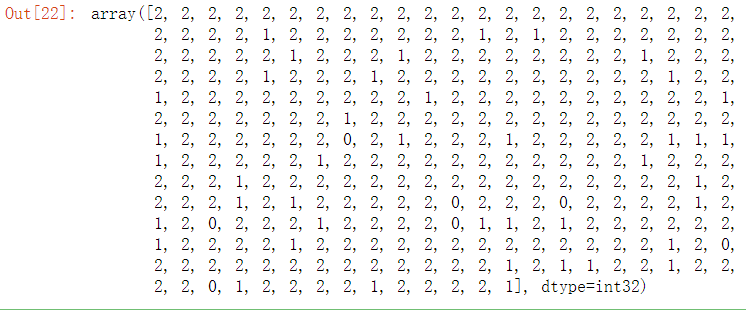

- 1、降维之后的数据

- 2、k-means聚类

- 3、聚类结果显示

data_new

#预估器流程 from sklearn.cluster import KMeans estimator = KMeans(n_clusters=3) estimator.fit(data_new)

y_predict = estimator.predict(data_new) y_predict[:300]

#模型评估 - 轮廓系数 from sklearn.metrics import silhouette_score silhouette_score(data_new, y_predict)

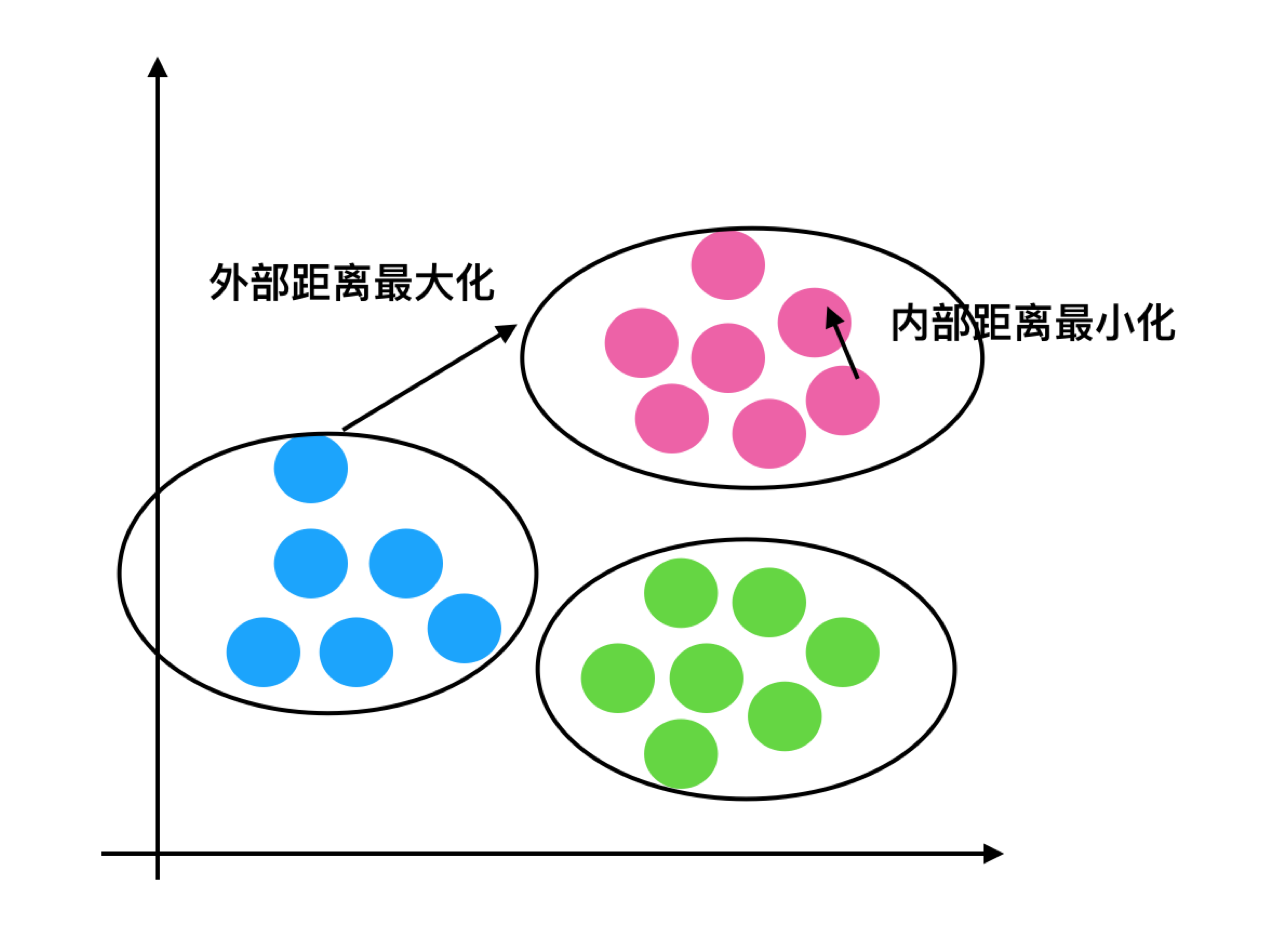

如何去评估聚类的效果呢?

Kmeans性能评估指标

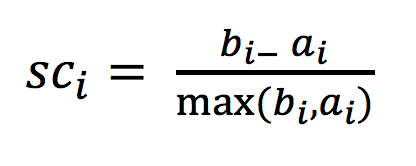

轮廓系数

注:对于每个点i 为已聚类数据中的样本 ,b_i 为i 到其它族群的所有样本的距离最小值,a_i 为i 到本身簇的距离平均值。最终计算出所有的样本点的轮廓系数平均值

轮廓系数值分析

分析过程(我们以一个蓝1点为例)

-

1、计算出蓝1离本身族群所有点的距离的平均值a_i

-

2、蓝1到其它两个族群的距离计算出平均值红平均,绿平均,取最小的那个距离作为b_i

- 根据公式:极端值考虑:如果b_i >>a_i: 那么公式结果趋近于1;如果a_i>>>b_i: 那么公式结果趋近于-1

结论

如果b_i>>a_i:趋近于1效果越好, b_i<<a_i:趋近于-1,效果不好。轮廓系数的值是介于 [-1,1] ,越趋近于1代表内聚度和分离度都相对较优。

轮廓系数API

sklearn.metrics.silhouette_score(X, labels)

- 计算所有样本的平均轮廓系数

- X:特征值

- labels:被聚类标记的目标值

K-means总结

- 特点分析:采用迭代式算法,直观易懂并且非常实用

- 缺点:容易收敛到局部最优解(多次聚类)