目录结构

- 模型原始论文

- 模型架构

- 模型原理

- 模型特点

- 模型案例

模型集合

Wide and Deep Learning

-

模型架构

-

模型原理

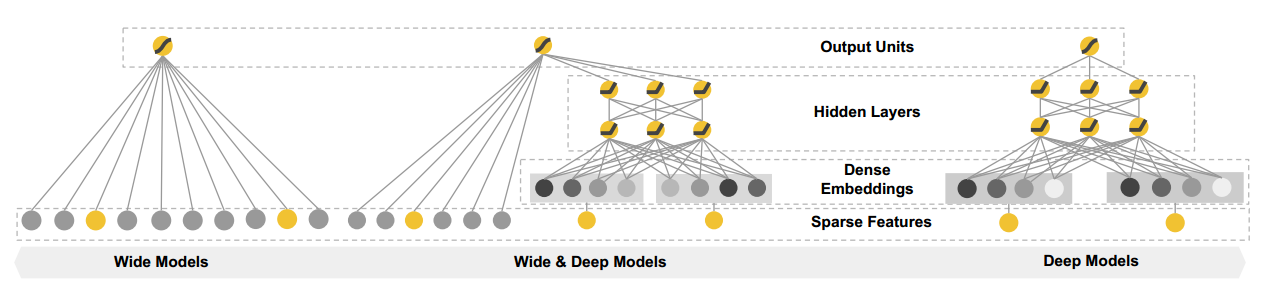

This approach combines the strengths of memorization and generalization. It's useful for generic large-scale regression and classification problems with sparse input features (e.g., categorical features with a large number of possible feature values).其中wide model部分是logistic regression with sparse features and transformations,deep model部分是feed-forward neural network with an embedding layer and several hidden layers -

模型特点

1.wide和deep部分单独训练,相比AFM是并行化的;

2.结合了wide model的记忆性(memorization)和deep model的泛化性(generalization);memorization是指和目标target直接(线性)相关的特征,而generalization是指和目标target间接(稀疏特征组合)相关的特征;这里wide model部分是LR实现的,deep model部分是DNN实现的; -

模型案例

wide_n_deep_tutorial.py

论文笔记 - Wide and Deep Learning for Recommender Systems

youtube recommendation

- 模型原始论文

Deep Neural Networks for YouTube Recommendations - 模型架构

1.候选集生成

2.排序

- 模型原理

1.候选集生成

隐式用户行为作为特征,用户完整观看视频是一个正例

损失函数是分层softmax,将稀疏的视频ID和搜索词embedding后求平均

负样本抽样与样本权重,样本选取是从用户的历史视频观看记录中随机拿出来一个作为正样本,然后只用这个视频之前的历史观看记录作为输入

2.排序

特征工程包括:

描述用户以前与item本身和其他相似item的互动,视频推荐展现次数,embedding离散特征,连续特征分位数归一化以及归一化之后的幂等变化

样本权重是根据观看时长进行加权

- 模型特点

- 模型案例

待自己实现

DeepFM

- 模型原始论文

DeepFM: A Factorization-Machine based Neural Network for CTR Prediction - 模型架构

- 模型原理

离散数据一般进行one-hot编码,连续数据使用本身的数值或者离散之后的one-hot编码。 - 模型特点

DeepFM的结构中包含了因子分解机部分以及深度神经网络部分,分别负责低阶特征的提取和高阶特征的提取。

与Wide&Deep Model不同,DeepFM在训练过程中不需要特征工程。

DeepFM的训练更高效。与Wide&Deep Model不同,DeepFM共享相同的输入与embedding向量。在Wide&Deep Model中,因为在Wide部分包含了人工设计的成对特征组,所以输入向量的长度也会显著增加。这也增加了其复杂性。 - 模型案例

tensorflow-DeepFM

Lattice

-

模型原始论文

This is an implementation of Monotonic Calibrated Interpolated Look-Up Tables in TensorFlow. -

模型架构

TensorFlow Lattice 中提供了全新的正则项:- 对输入选择进行单调性限制

- 在点阵上进行拉普拉斯正则化,以便让学习函数更扁平

- 扭曲正则化以抑制不必要的非线性特征交互

-

模型原理

lattice是多维内插式查找表,为了模型更好地泛化,我们充分利用查找表的结构来满足您指定的 单调关系,这种结构能够通过使用多重输入估计任意柔性关系的方式进行键控。也就是说,查找表值在训练后可以最大程度减少训练示例上的损失,同时,查找表中的邻近值将限制为沿着输入空间的给定方向增大,从而让模型输出在这些方向上增大。重要的是,由于可以内插在查找表值之间,点阵模型非常平滑,预测也有边界限制,这有助于避免测试时出现虚假的大或小预测。 -

模型特点

-

模型案例

uci_census

Neural FM

- 模型原始论文

Neural Factorization Machines for Sparse Predictive Analytics∗ - 模型架构

- 模型原理

- 首次提出Bi-Interaction池化,在low level层面做二阶交叉,在Hidden Layer做高阶特征交叉,从而提高性能

- 更深的FM模型,并且能够更好的学习高阶和非线性交叉特征

- 模型特点

- FM就是NFM去掉Hidden Layer的结果

- 如果将Bi-Interaction替换为MLP,那么NFM就能退化为Wide&Deep(或者DeepCross)模型

- 模型案例

Neural-Factorization-Machine

Attentional-Neural-Factorization-Machine

NFM 作者分享的源码

Deep Cross(DCN)

-

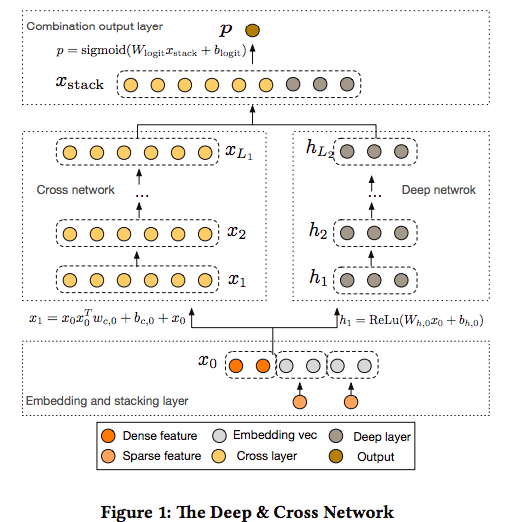

模型架构

-

模型原理

Cross Network

(x^{l+1}=x_0x^T_lw_l+b_l+x_l) -

模型特点

-

模型案例

Deep-and-Cross-Keras

贝叶斯深度学习

-

模型原始论文

-

模型架构

-

模型原理

-

模型特点

-

模型案例

-

TreeBased DNN