P3-P4:

目前遇见的问题很简单:硬盘容量不断提升,1TB的已成为主流,然而数据传输速度从1990年的4.4MB/s仅上升到当前约100MB/s

读取一个1TB的硬盘数据需要耗时至少2.5个小时。写入数据则会消耗更多时间。解决方法是从多个硬盘上读取,试想,若当前有100个盘,每个盘存储1%数据,则并行读取仅需2minutes则可读取完所有的数据。

与此同时,并行读写数据带来了几个问题:

1、某个硬件故障 - 采用数据备份机制

2、分析任务需要所有节点共同完成,结果正确性 - MapReduce:将硬盘读写问题转化为对一个数据集的计算。

所以,Hadoop提供给我们一个可靠的共享存储和分析系统。

由HDFS实现可靠数据存储,MR实现可靠数据分析处理。

P6

P7

数据本地化是MR的一个核心特性,意识到到处复制数据容易消耗尽网络带宽后,MR尽量在计算机节点上存储数据,以实现数据的本地快速访问,同时,也提高了计算的性能。

P8

当需要完成计算,却中途有部分节点计算失效时,MR能检测到并重新执行那些失败的M或R任务。

这是因为MR采用的是无共享的架构,各个计算任务相互独立,容易实现失败检测。

P9

MR三大设计目标:

(1)为只需要几分钟或几小时可以完成的作业提供服务

(2)运行于同一个内部有高速网络连接的数据中心内部

(3)数据中心内的机器都是可靠、定制的硬件

P12

2006年4月 在188个节点(每个10GB)运行排序测试需要49.7小时

5月 在500个节点(每个10GB)运行排序测试需要42小时

12月 在20节点上1.8小时,100节点上3.3小时,500节点上5.2小时,900节点上7.8小时

在2008年4月,在一个有910台节点的集群上,以不到3.5分钟的成绩,完成了对1TB数据的排序,成为最快的TB级数据排序系统。

同年11月,google用了68s

2009年5月,雅虎用了62s

雅虎搜索引擎四个组成部分:

1 网页服务器爬取网页 - Crawler

2 构建已知网页链接图 - WebMap (链接图非常大,分析需要数日)

3 最佳页面构建反向索引 - Indexer

4 处理用户的查询 - Runtime

P14-15

P15

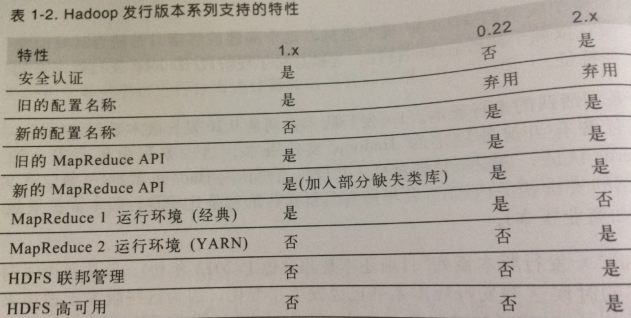

2.x 版本新特性

1、基于YARN系统上构建了全新的MR2.YARN是一个通用的用于运行分布式应用的资源管理器(Yet Another Resource Negotiator)

2、HDFS联合管理,将HDFS命名空间分散到多个namenode中以支持包含大规模数据文件的集群。

3、HDFS高可用性,启用secondNamenode避免namenode单点故障。