1.中软国际华南区技术总监曾老师还会来上两次课,同学们希望曾老师讲些什么内容?(认真想一想回答)

希望能讲一些大数据相关内容,深入了解一下。

2.中文分词

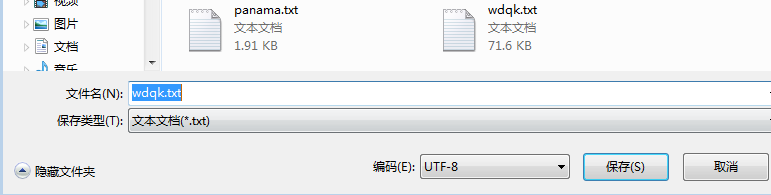

- 下载一中文长篇小说,并转换成UTF-8编码。

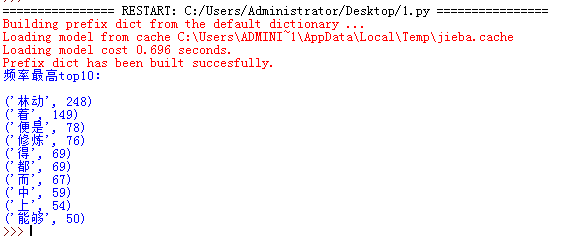

- 使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

import jieba ff=open('wdqk.txt','r',encoding='utf-8') wdqk=ff.read() for i in ',.""?!,。?!“” ': wdqk=wdqk.replace(i,' ') wdqk=list(jieba.cut(wdqk)) zd={} paichu={'我','是','你','他','她','在','有','的','了','也','这','那',' '} key=set(wdqk)-paichu for i in key: zd[i]=wdqk.count(i) lb=list(zd.items()) lb.sort(key=lambda x:x[1],reverse=True) print('频率最高top10: ') for i in range(10): print(lb[i]) ff.close()

- **排除一些无意义词、合并同一词。

- **使用wordcloud库绘制一个词云。

(**两项选做,此次作业要求不能雷同。)