wordcount是spark入门级的demo,不难但是很有趣。接下来我用命令行、scala、Java和python这三种语言来实现单词统计。

一、使用命令行实现单词的统计

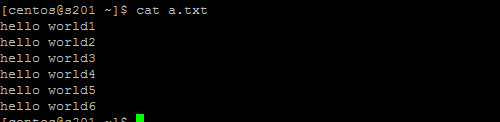

1.首先touch一个a.txt文本文件

2.加载文本:产生弹性分布式数据集,用sc.textFile()加载文本文件到内存中去,加载到内存之后,整个RDD就是一个数组,就以换行符来做分隔

val rdd1 = sc.textFile("/home/centos/a.txt")

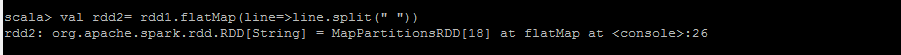

3.对2中产生的数组按空格进行切割,切开之后每个元素就变成了一个数组,[hello,world1]

val rdd2=rdd1.flatMap(line=>line.split(" "))

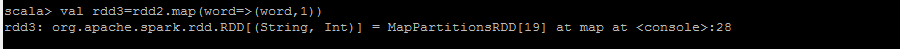

4.对3中产生的结果进行key,value键值对额转换

val rdd3=rdd2.map(wor=>(word,1))

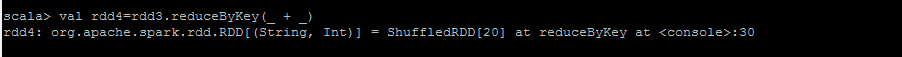

5.对4中的结果进行聚合

val rdd4=rdd3.reduceByKey(_ + _)

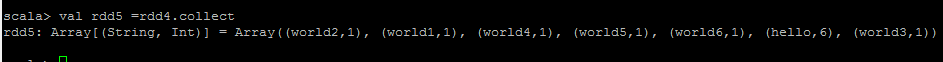

5.查看结果

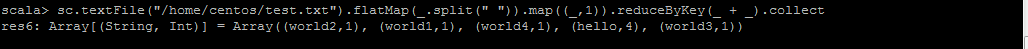

6.一步操作

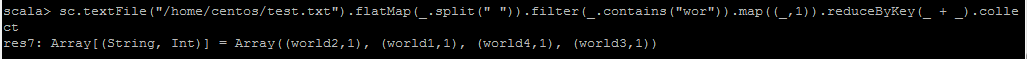

7.实现单词过滤

对于spark-shell这种环境一般只用于测试和调试