主要步骤:

1.准备数据

- 数据集读入

- 数据集乱序

- 将数据集分为训练集和测试集

- 将输入特征和标签配对,每次喂入神经网络一小撮(batch)

2.搭建网络

- 定义神经网络中所有可训练参数

3.参数优化

- 反向传播,不断减少loss

4.测试效果

- 计算当前参数前向传播后的准确率

代码:

import tensorflow as tf

from sklearn import datasets

from matplotlib import pyplot as plt

import numpy as np

# 导入输入特征和标签

x_data = datasets.load_iris().data

y_data = datasets.load_iris().target

# 随机打乱数据

# 使用相同的随机种子,保证输入特征和标签一一对应

np.random.seed(116)

np.random.shuffle(x_data)

np.random.seed(116)

np.random.shuffle(y_data)

tf.random.set_seed(116)

# 将打乱后的数据分割为训练集(前120行)和测试集(后30行)

x_train = x_data[:-30]

y_train = y_data[:-30]

x_test = x_data[-30:]

y_test = y_data[-30:]

# 转换x的数据类型,保证后面矩阵相乘时数据类型一致

x_train = tf.cast(x_train, tf.float32)

x_test = tf.cast(x_test, tf.float32)

# 将输入特征和标签一一配对

# 每32组数据,打包一次,分批次喂入神经网络

train_db = tf.data.Dataset.from_tensor_slices((x_train, y_train)).batch(32)

test_db = tf.data.Dataset.from_tensor_slices((x_test, y_test)).batch(32)

# 声明神经网络的参数

# 4个输入特征,3个分类,故输入层为4个输入节点,输出层为3个神经元

w1 = tf.Variable(tf.random.truncated_normal([4, 3], stddev=0.1, seed=1))

b1 = tf.Variable(tf.random.truncated_normal([3], stddev=0.1, seed=1))

# 学习率

lr = 0.2

# 记录每轮训练后的loss,为后续画loss曲线提供参数

train_loss_results = []

# 记录每轮训练后的正确率

test_acc = []

# 将数据喂入神经网络500次

epoch = 500

# 因为数据分批次喂入神经网络,所以需要求和

loss_all = 0

# 数据集级别的循环,每个epoch喂入一次数据集

for epoch in range(epoch):

# batch级别的循环,每个step喂入一个batch

for step, (x_train, y_train) in enumerate(train_db):

with tf.GradientTape() as tape:

# 神经网络乘加操作

y = tf.matmul(x_train, w1) + b1

# 使y符合概率分布,与独热码同级,相减可求loss

y = tf.nn.softmax(y)

# 将标签转换为独热码格式,方便计算loss和accuracy

y_ = tf.one_hot(y_train, depth=3)

# 使用均方误差损失函数

loss = tf.reduce_mean(tf.square(y_ - y))

# 将每个step计算出来的loss累加

loss_all += loss.numpy()

# 计算loss对各参数的导数

grads = tape.gradient(loss, [w1, b1])

# 参数w1和b1自更新

w1.assign_sub(lr * grads[0])

b1.assign_sub(lr * grads[1])

# 输出每次训练的loss

# 因为有4组batch,所以除以4

print("epoch:%d loss:%f" % (epoch, loss_all/4))

# 记录每次训练的loss,方便后面绘制loss变化曲线图

train_loss_results.append(loss_all/4)

# 归零,方便下次统计

loss_all = 0

# 调用测试数据,统计正确率

# total_correct为正确个数, total_number为测试总数

# 注意,此时仍为batch级别的循环,每次循环,喂入一个batch

total_correct, total_number = 0, 0

for x_test, y_test in test_db:

# 使用更新后的参数进行预测

y = tf.matmul(x_test, w1) + b1

y = tf.nn.softmax(y)

# 返回y中最大值的索引,即预测的分类

pred = tf.argmax(y, axis=1)

# 将pred转换成y_test的类型

pred = tf.cast(pred, dtype=y_test.dtype)

# 将bool类型转换成int类型,若分类正确correct=1,否则为0

correct = tf.cast(tf.equal(pred, y_test), dtype=tf.int32)

# 计算每个batch中的correct数

correct = tf.reduce_sum(correct)

# 将所有batch中的correct数加起来

total_correct += int(correct)

# x_test有多少行,每个batch就有多少样本

total_number += x_test.shape[0]

acc = total_correct/total_number

test_acc.append(acc)

print("test_acc:%f" % acc)

print("****************")

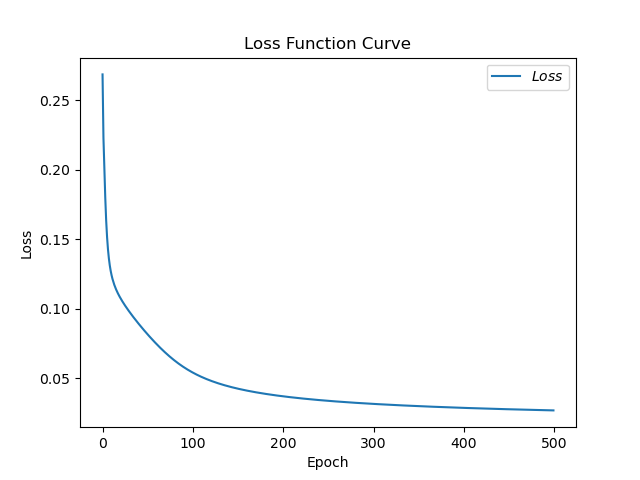

# 绘制 loss 曲线

plt.title('Loss Function Curve') # 图片标题

plt.xlabel('Epoch') # x轴变量名称

plt.ylabel('Loss') # y轴变量名称

plt.plot(train_loss_results, label="$Loss$") # 逐点画出trian_loss_results值并连线,连线图标是Loss

plt.legend() # 画出曲线图标

plt.show() # 画出图像

# 绘制 Accuracy 曲线

plt.title('Acc Curve') # 图片标题

plt.xlabel('Epoch') # x轴变量名称

plt.ylabel('Acc') # y轴变量名称

plt.plot(test_acc, label="$Accuracy$") # 逐点画出test_acc值并连线,连线图标是Accuracy

plt.legend()

plt.show()

运行结果: