Ceph是一个分布式存储,可以提供对象存储、块存储和文件存储,其中对象存储和块存储可以很好地和各大云平台集成。一个Ceph集群中有Monitor节点、MDS节点(可选,用于文件存储)、至少两个OSD守护进程。

Ceph OSD:OSD守护进程,用于存储数据、处理数据拷贝、恢复、回滚、均衡,并通过心跳程序向Monitor提供部分监控信息。一个Ceph集群中至少需要两个OSD守护进程。

Monitor:维护集群的状态映射信息,包括monitor、OSD、Placement Group(PG)。还维护了Monitor、OSD和PG的状态改变历史信息。

MDS:存储Ceph文件系统的元数据。

一、准备两台机器

10.111.131.125 ceph01

10.111.131.126 ceph02

ceph01将作为admin、osd1

ceph02将作为osd2、mon2

二、设置两台主机ssh免密码访问

1、在ceph01电脑上执行

ssh-keygen //一直按回车即可,产生公钥私钥对

2、将ceph01产生的公钥复制到ceph01和ceph02上,这样可以使用ceph01无密码登录ceph01和ceph02

ssh-copy-id -i /root/.ssh/id_rsa.pub ceph01

ssh-copy-id -i /root/.ssh/id_rsa.pub ceph02

测试:

ssh ceph01

ssh ceph02

发现登录时不用输入密码就算设置成功。

三、在ceph01上安装ceph-deploy

apt-get install ceph-deploy

四、在ceph01上创建集群目录

mkdir my-cluster

cd my-cluster

五、创建集群,会在当前目录下看到ceph.conf ceph.log ceph.mon.keyring三个文件

在ceph01上执行:

ceph-deploy new ceph01

执行以上命令后,ceph01相当于监控节点。如果要把两台都作为监控节点则:

ceph-deploy new ceph01 ceph02

vim ceph.conf并将以下配置追加到后面

osd pool default size = 2

六、分别在ceph01和ceph02上安装ceph

在ceph01上执行以下命令:

ceph-deploy install ceph01 ceph02

执行以上命令,相当于在两台电脑上都运行了:apt-get install -y ceph,如果上面的命令失败,也可以用apt-get去每台机子上安装ceph

七、初始化集群监控

在ceph01上执行:

ceph-deploy mon create-initial

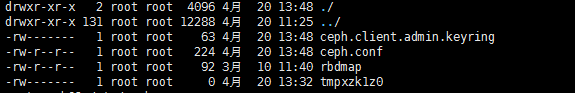

八、收集秘钥,目录下会多出ceph.bootstrap-mds.keyring ceph.client.admin.keyring ceph.client.admin.keyring这几个文件

ceph-deploy gatherkeys ceph01

九、准备2块硬盘并准备osd

分别在ceph01和ceph02上执行:

mkfs.xfs /dev/sdb1

在ceph01上执行:

ceph-deploy osd prepare ceph01:/dev/sdb1 ceph02:/dev/sdb1

在ceph01上执行:

ceph-deploy osd activate ceph01:/dev/sdb1 ceph02:/dev/sdb1

上面两条命令执行后,/dev/sdb1会mount到/var/lib/ceph/osd/ceph-0和/var/lib/ceph/osd/ceph-1上,当重启电脑后该挂载会消失,最好开机挂载,解决办法多样,

本人的方法是在:/etc/rc.loac里面加入:

节点1:

mount /dev/sdb1 /var/lib/ceph/osd/ceph-0

节点2:

mount /dev/sdb1 /var/lib/ceph/osd/ceph-0

十、将配置文件和管理密钥复制到管理节点和Ceph节点,下次再使用ceph命令界面时就无需指定集群监视器地址,执行命令时也无需每次都指定ceph.client.admin.keyring

在ceph01节点上执行:

ceph-deploy --overwrite-conf admin ceph01 ceph02

执行以上命令之后,ceph02这台机器的/etc/ceph目录下也会多出ceph.client.admin.keyring这个文件。

十一、在ceph01上建一个元数据服务器(可选)

大多数情况下都是使用ceph的块设备,一般来说都不用建立mds,只有用到ceph的文件存储的时候才用到

首先执行:

mkdir -p /var/lib/ceph/mds/ceph-ceph01

ceph-deploy mds create ceph01

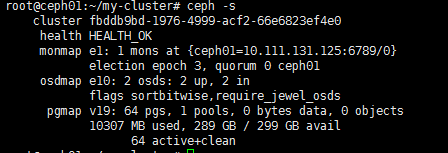

十二、ceph -s 看到ok表示集群状态正常。

十三、重启集群

service ceph restart -a

如果上面的命令不起作用则对各个节点服务进行重启

1、重启mon节点,mon节点在ceph01上

/etc/init.d/ceph restart mon.ceph01或

systemctl start ceph-mon@ceph01

2、重启osd0节点,osd0在ceph01上

systemctl start ceph-osd@0

3、重启osd1节点,osd1在ceph02上

ssh ceph02

systemctl start ceph-osd@1