分词器原理与作用

todo

一、Solr 自带分词器

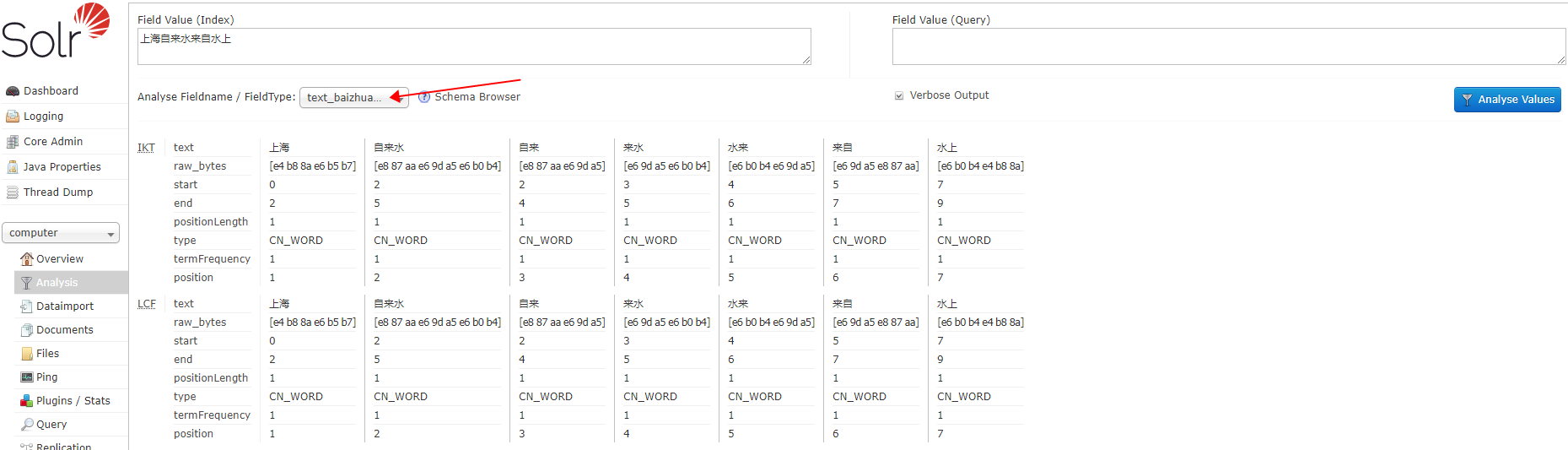

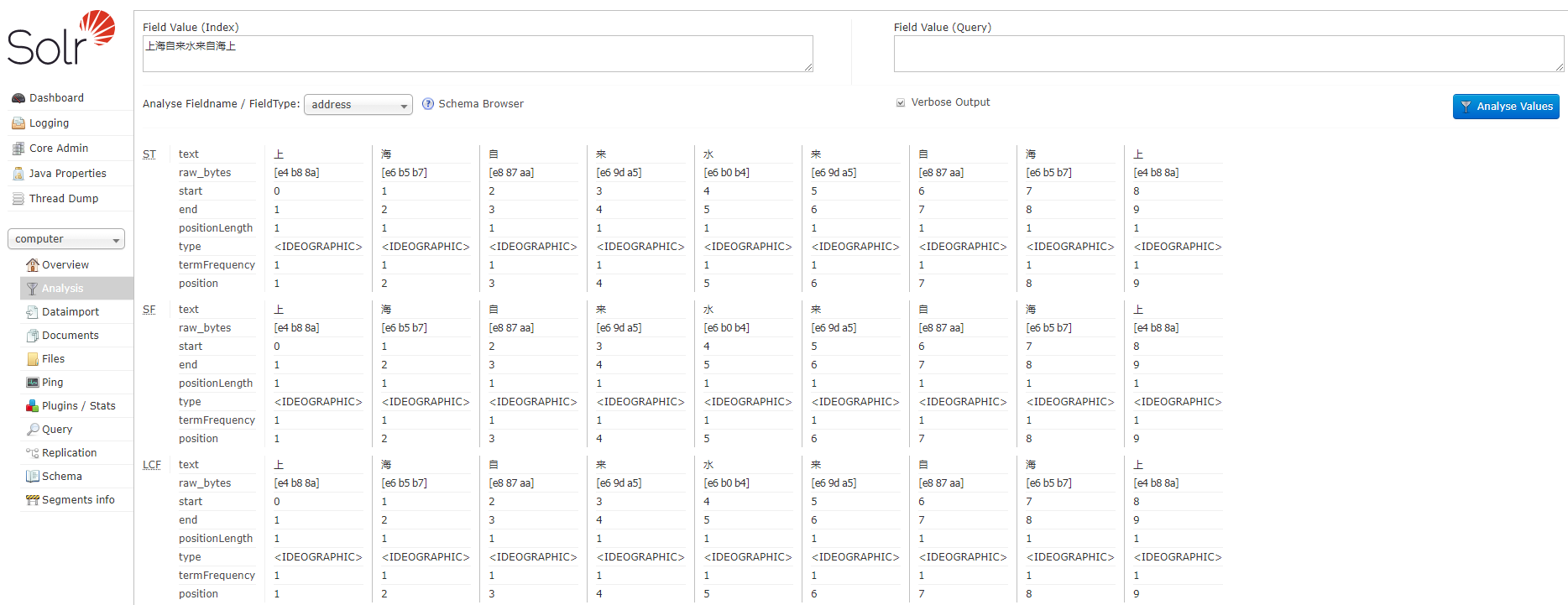

Solr 自带的分词器,是将所有的中文次分成单独的最小个,如下

二、配置第三方 ik 分词器

分词器下载地址:https://github.com/magese/ik-analyzer-solr ,服务器器 sorl 版本 7.7.0

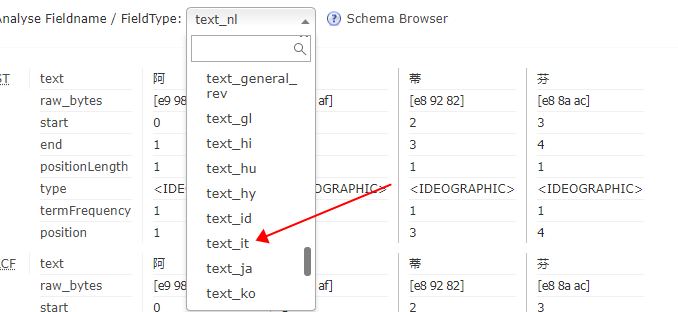

查看类型:并没有ik 分词器 ,现在添加一个ik 分词器

将下载好的 jar 包导入 /usr/local/tomcat8/webapps/solr/WEB-INF/lib

cd /usr/local/tomcat8/webapps/solr/WEB-INF/lib

rz xx.jar

此处WEB-INF 下没有 classes 文件,创建 classes文件夹,并将 resource 下的配置导入

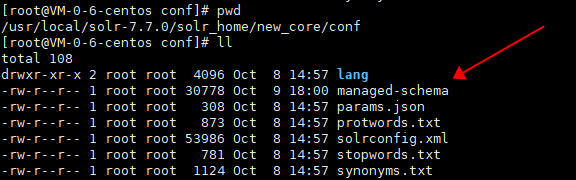

修改Core 核心下的 managed-schema

添加如下配置:

<!-- ik分词器 --> <fieldType name="text_ik" class="solr.TextField"> <analyzer type="index"> <tokenizer class="org.wltea.analyzer.lucene.IKTokenizerFactory" useSmart="false" conf="ik.conf"/> <filter class="solr.LowerCaseFilterFactory"/> </analyzer> <analyzer type="query"> <tokenizer class="org.wltea.analyzer.lucene.IKTokenizerFactory" useSmart="true" conf="ik.conf"/> <filter class="solr.LowerCaseFilterFactory"/> </analyzer> </fieldType>

重启 solr ,并测试,发现分词成功