什么是模式识别?

它指的是,对表征事物或现象的各种形式的信息进行处理和分析,从而达到对事物或现象进行描述、辨认、分类和解释的目的。

我们之所以可以很快辨别猫是猫、O不是0,就是因为在我们大脑中已经给猫的做了一个抽象,给O和0做了区分,这样我们才不用每次都重新靠思考和计算理解这到底是不是猫。这个在大脑中的抽象就是模式识别。

模式识别和机器学习的区别在于:前者喂给机器的是各种特征描述,从而让机器对未知的事物进行判断;后者喂给机器的是某一事物的海量样本,让机器通过样本来自己发现特征,最后去判断某些未知的事物。

什么是模板匹配?

机器学习炙手可热的今天,貌似好多人都信手拈来“K-NN”、“Bayes Classifier”、“PCA”这种主流的模式识别算法。但是我们今天要聊的是传统的、最简单的模板匹配。

模板匹配是一种最原始、最基本的模式识别方法,研究某一特定对象物的图案位于图像的什么地方,进而识别对象物,这就是一个匹配问题。它是图像处理中最基本、最常用的匹配方法。模板匹配具有自身的局限性,主要表现在它只能进行平行移动,若原图像中的匹配目标发生旋转或大小变化,该算法无效。

简单来说,模板匹配就是在整个图像区域发现与给定子图像匹配的小块区域。

怎么实现模板匹配?

在待检测图像上,从左到右,从上向下一个像素一个像素地移动模板,计算模板图像与重叠子图像的匹配度,匹配程度越大,两者相同的可能性越大。

怎么计算匹配度?

OpenCV中提供的模板识别的方法如下:

1.利用平方差来进行匹配,最好匹配为0.匹配越差,匹配值越大。

- TM_SQDIFF:平方差匹配

- TM_SQDIFF_NORMED:标准平方差匹配

2.采用模板和图像间的乘法操作,数越大表示匹配程度较高, 0表示最坏的匹配效果。

- TM_CCORR:相关性匹配

- TM_CCORR_NORMED:标准相关性匹配

3. 将模版对其均值的相对值与图像对其均值的相关值进行匹配,1表示完美匹配,-1表示糟糕的匹配,0表示没有任何相关性(随机序列)。

- TM_CCOEFF:相关性系数匹配

- TM_CCOEFF_NORMED:标准相关性系数匹配

总结:随着从简单的测量(平方差)到更复杂的测量(相关系数),我们可获得越来越准确的匹配(同时也意味着越来越大的计算代价)。

纸上得来终觉浅,绝知此事要躬行

上代码:

#include "opencv2/imgcodecs.hpp"

#include "opencv2/highgui.hpp"

#include "opencv2/imgproc.hpp"

#include <iostream>

using namespace std;

using namespace cv;

/// Global Variables

bool use_mask;

Mat img; Mat templ; Mat mask; Mat result;

const char* image_window = "Source Image";

const char* result_window = "Result window";

int match_method;

int max_Trackbar = 5;

// Function Headers

void MatchingMethod( int, void* );

/**

* @function main

*/

int main( int argc, char** argv )

{

//MatchTemplate_Demo <image_name> <template_name>[<mask_name>]

// Load image and template

img = imread("F:/opencv/build/bin/sample-data/template-matching/Original_Image.jpg", IMREAD_COLOR );

templ = imread("F:/opencv/build/bin/sample-data/template-matching/Template_Image.jpg", IMREAD_COLOR );

use_mask = false;

//mask = imread("", IMREAD_COLOR);

if(img.empty() || templ.empty() || (use_mask && mask.empty()))

{

cout << "Can't read one of the images" << endl;

return -1;

}

// Create windows

namedWindow( image_window, WINDOW_AUTOSIZE );

namedWindow( result_window, WINDOW_AUTOSIZE );

// Create Trackbar

const char* trackbar_label = "Method:

0: SQDIFF

1: SQDIFF NORMED

2: TM CCORR

3: TM CCORR NORMED

4: TM COEFF

5: TM COEFF NORMED";

createTrackbar( trackbar_label, image_window, &match_method, max_Trackbar, MatchingMethod );

MatchingMethod( 0, 0 );

waitKey(0);

return 0;

}

/**

* @function MatchingMethod

* @brief Trackbar callback

*/

void MatchingMethod( int, void* )

{

// Source image to display

Mat img_display;

img.copyTo( img_display );

// Create the result matrix

int result_cols = img.cols - templ.cols + 1;

int result_rows = img.rows - templ.rows + 1;

result.create( result_rows, result_cols, CV_32FC1 );

// Do the Matching and Normalize

bool method_accepts_mask = (TM_SQDIFF == match_method || match_method == TM_CCORR_NORMED);

if (use_mask && method_accepts_mask)

{ matchTemplate( img, templ, result, match_method, mask); }

else

{ matchTemplate( img, templ, result, match_method); }

normalize( result, result, 0, 1, NORM_MINMAX, -1, Mat() );

// Localizing the best match with minMaxLoc

double minVal; double maxVal; Point minLoc; Point maxLoc;

Point matchLoc;

minMaxLoc( result, &minVal, &maxVal, &minLoc, &maxLoc, Mat() );

// For SQDIFF and SQDIFF_NORMED, the best matches are lower values. For all the other methods, the higher the better

if( match_method == TM_SQDIFF || match_method == TM_SQDIFF_NORMED )

{ matchLoc = minLoc; }

else

{ matchLoc = maxLoc; }

// Show me what you got

rectangle( img_display, matchLoc, Point( matchLoc.x + templ.cols , matchLoc.y + templ.rows ), Scalar::all(0), 2, 8, 0 );

rectangle( result, matchLoc, Point( matchLoc.x + templ.cols , matchLoc.y + templ.rows ), Scalar::all(0), 2, 8, 0 );

imshow( image_window, img_display );

imshow( result_window, result );

return;

}

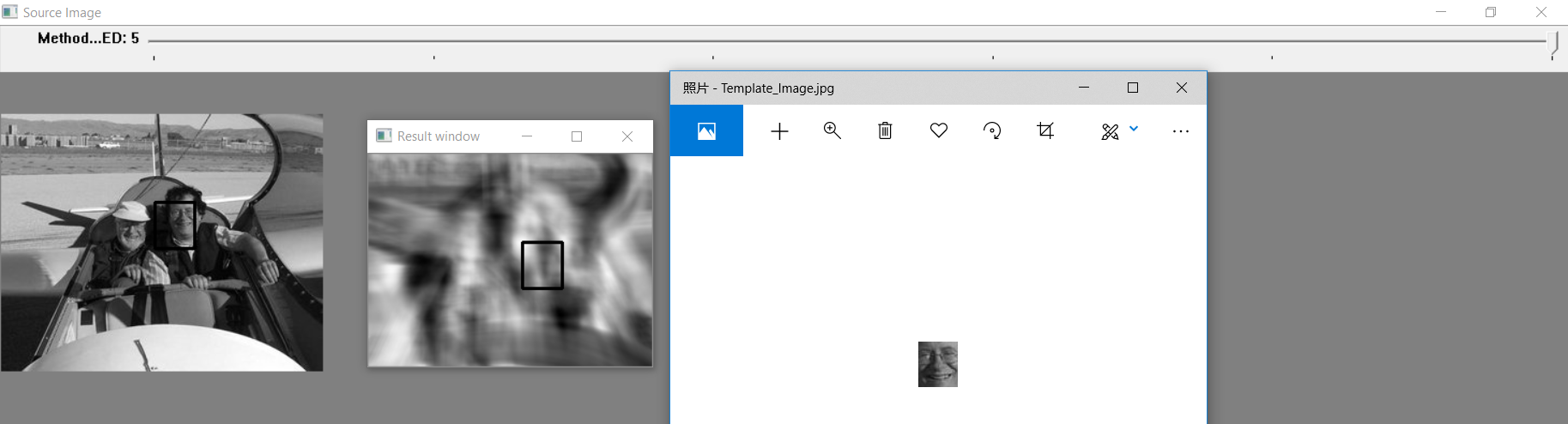

结果: