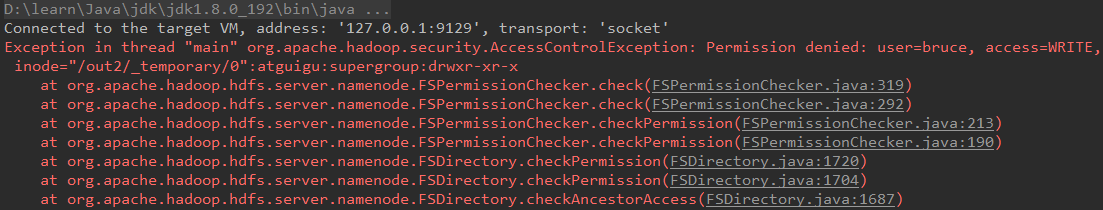

问题再现:

使用本机 Ecilpse (Windows环境) 去访问远程 hadoop 集群出现以下异常:

问题原因:

因为远程提交的情况下如果没有 hadoop 的系统环境变量,就会读取当前主机的用户名,所以 hadoop 集群的节点中没有该用户名的权限,所以出现的异常。

问题解决:

a、如果是测试环境,可以取消 hadoop hdfs 的用户权限检查。打开 conf/hdfs-site.xml,找到 dfs.permissions 属性修改为 false(默认为true),然后配置分发到其它节点,然后重启集群。此法没有效果。

b、修改 hadoop location 参数,在 advanced parameter 选项卡中,找到 hadoop.job.ugi 项,将此项改为启动 hadoop 的用户名即可。(注意第一次设置的时候可能没有 hadoop.job.ugi 参数,报错后再去看就有了),此法的参数没有找到!

c、因为 Eclipse 使用 hadoop 插件提交作业时,会默认以 当前主机的用户名 的身份去将作业写入 HDFS 文件系统中,由于 当前主机的用户名 对 hadoop 目录并没有写入权限,所以导致异常的发生。

解决方法为:放开 hadoop 目录的权限 ,命令如下 :$ hadoop fs -chmod 777 / # 表示为整个根目录开放权限,不推荐此法!

d、远程提交,如果没有 hadoop 的系统环境变量,就会读取当前主机的用户名,结果 hadoop 集群中没有该用户,所以就异常了。

解决方法为:在远程 Linux 上将 export HADOOP_USER_NAME = bruce 添加到 ~/.bash_profile 中,然后生效该文件 $ source ~/.bash_profile ,不推荐此法!

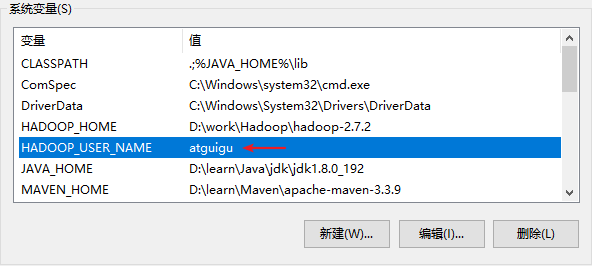

e、执行 login.login 的时候调用了 hadoop 里面的 HadoopLoginModule 方法,而关键是在 commit 方法里面,在这里优先读取 HADOOP_USER_NAME 系统环境变量,然后是 java 环境变量 中的 HADOOP_USER_NAME ,如果再没有就从 NTUserPrincipal 等里面取。即 只要 在系统的环境变量里面添加 HADOOP_USER_NAME=xxx(xxx 是 HDFS 上的有权限的用户,具体看自己的情况),或者在当前 JDK 的变量参数里面添加 HADOOP_USER_NAME 这个 Java变 量。推荐此法!如下图:

f、再代码中加入 System.setProperty("HADOOP_USER_NAME", "atguigu") ,此法没有测试过!

g、或者设置 conf/hdfs-site.xml,此法没有测试过!

<property> <name>hadoop.security.authentication</name> <value>simple</value> </property>

附录

hadoop 的整个登录过程

login.login(); 这个会调用 HadoopLoginModule 的 login() 和 commit()方法。 HadoopLoginModule 的 login() 方法是一个空函数,只打印了一行调试日志 LOG.debug("hadoop login"); commit() 方法负责把 Principal 添加到 Subject 中。

此时一个首要问题是 username 是什么? 在使用了 kerberos 的情况下,从 javax.security.auth.kerberos.KerberosPrincipal 的实例获取 username。

在未使用 kerberos 的情况下,优先读取 HADOOP_USER_NAME 这个系统环境变量,如果不为空,那么拿它作 username。否则,读取 HADOOP_USER_NAME 这个 java 环境变量。

否则,从 com.sun.security.auth.NTUserPrincipal 或者 com.sun.security.auth.UnixPrincipal 的实例获取 username。 如果以上尝试都失败,那么抛出异常 LoginException("Can’t find user name")。 最终拿 username 构造 org.apache.hadoop.security.User 的实例添加到 Subject 中。