当我们需要大量的爬取网站信息时,除了切换User-Agent之外,另外一个重要的方式就是设置IP代理,以防止我们的爬虫被拒绝,下面我们就来演示scrapy如何设置随机IPProxy。

设置随机IPProxy

同样的你想要设置IPProxy ,首先需要找到可用的IPProxy ,通常情况下,一些代理网站会提供一些免费的ip代理,但是其稳定性和可用性很难得到保证,但是初学阶段,只能硬着头皮去找了,当然后期我们可以有其他的方法来寻找可用的IP代理,拿到可用的IPProxy 以后,将其添加到settings.py文件中,像下面这样,当然了,当你看到这篇文章的时候,他们肯定是已经失效了,你需要自己去找了。

PROXIES = ['http://183.207.95.27:80', 'http://111.6.100.99:80', 'http://122.72.99.103:80',

'http://106.46.132.2:80', 'http://112.16.4.99:81', 'http://123.58.166.113:9000',

'http://118.178.124.33:3128', 'http://116.62.11.138:3128', 'http://121.42.176.133:3128',

'http://111.13.2.131:80', 'http://111.13.7.117:80', 'http://121.248.112.20:3128',

'http://112.5.56.108:3128', 'http://42.51.26.79:3128', 'http://183.232.65.201:3128',

'http://118.190.14.150:3128', 'http://123.57.221.41:3128', 'http://183.232.65.203:3128',

'http://166.111.77.32:3128', 'http://42.202.130.246:3128', 'http://122.228.25.97:8101',

'http://61.136.163.245:3128', 'http://121.40.23.227:3128', 'http://123.96.6.216:808',

'http://59.61.72.202:8080', 'http://114.141.166.242:80', 'http://61.136.163.246:3128',

'http://60.31.239.166:3128', 'http://114.55.31.115:3128', 'http://202.85.213.220:3128']

而后,在middlewares.py文件中,添加下面的代码。

import scrapy

from scrapy import signals

import random

class ProxyMiddleware(object):

'''

设置Proxy

'''

def __init__(self, ip):

self.ip = ip

@classmethod

def from_crawler(cls, crawler):

return cls(ip=crawler.settings.get('PROXIES'))

def process_request(self, request, spider):

ip = random.choice(self.ip)

request.meta['proxy'] = ip

其基本的逻辑和上一篇设置User-Agent非常类似,因此这个地方不多赘述。

最后将我们自定义的类添加到下载器中间件设置中,如下。

DOWNLOADER_MIDDLEWARES = {

'myproject.middlewares.ProxyMiddleware': 543,

}

测试我们的代理

为了检测我们的代理是否设置成功,下面就以一个例子来进行测试。

我们在spider.py文件中写入下面的代码

import scrapy

class Spider(scrapy.Spider):

name = 'ip'

allowed_domains = []

def start_requests(self):

url = 'http://ip.chinaz.com/getip.aspx'

for i in range(4):

yield scrapy.Request(url=url, callback=self.parse, dont_filter=True)

def parse(self,response):

print(response.text)

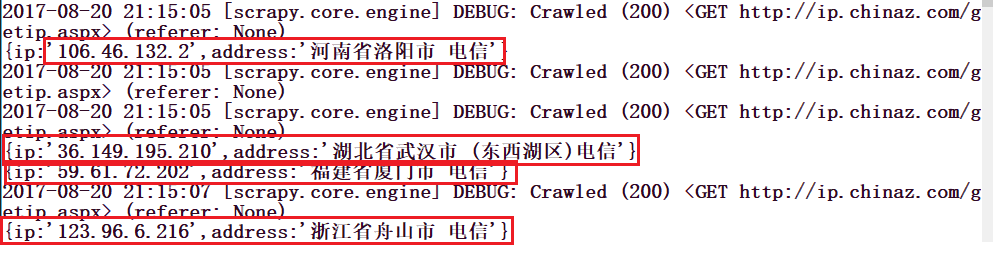

上面的代码中,url = 'http://ip.chinaz.com/getip.aspx'这个网站可以显示我们的ip地址,我们用它来测试,请注意,在Request()中,我们必须添加dont_filter=True因为我们多次请求的是同一个网址,scrapy默认会把重复的网址过滤掉。运行这个项目,我们可以看到如下的输出。