简介

感知机是二类分类的线性分类模型,属于判别模型,输入实例特征向量,输出实例的类别,取+1和-1。是神经网络与支持向量机的基础。

模型

$$f(x)=sign(w.x+b)$$

几何解释:

线性方程$w.x+b=0$对应特征空间的一个超平面S,位于超平面两侧的点被分为正类或负类,S称为分离超平面。

策略

假设数据集是线性可分的,即存在一个超平面S能够将数据集中的正负实例点完全正确的划分到超平面的两侧。

感知机目标就是找出这个超平面;为了找到这样的超平面,即确定感知机模型参数w,b,需要确定一个学习策略,即定义(经验)损失函数并将损失函数最小化。

损失函数选择误分类点到超平面S的总距离。

损失函数为:

$$L(w,b)=-displaystylesum_{x_iin M}y_i(wcdot x_i+b)$$

假设超平面S的误分类点集合为M。

推导过程如下:

某点到超平面S的距离为:$frac{1}{||w||}|wcdot x_0+b|$

对误分类数据有:$-y_i(wcdot x_i+b)>0$,因此误分类数据到超平面的距离为:$-frac{1}{||w||}y_i(wcdot x_0+b)$

假设超平面S的误分类点集合为M,那么所有误分类点到超平面S总距离为:$-frac{1}{||w||}displaystylesum_{x_iin M}y_i(wcdot x_i+b)$;不考虑$frac{1}{||w||}$,就得到感知机学习的损失函数。

算法

感知机学习问题转化为求解损失函数最优化问题,采用随机梯度下降,包括原始形式和对偶形式。

1.原始形式:

输出:w,b 感知机模型:f(x)=w.x+b,$eta(0<etaleq 1)$

(1)w,b选初值$w_0,b_0$.

(2)训练集选取数据$(x_i,y_i) $,

(3)若$y_i(wcdot x_i+b)leq 0$:

$w leftarrow w+eta y_ix_i$

$b leftarrow b+eta y_i$

(4)转至2,直至训练集中没有误分类点。

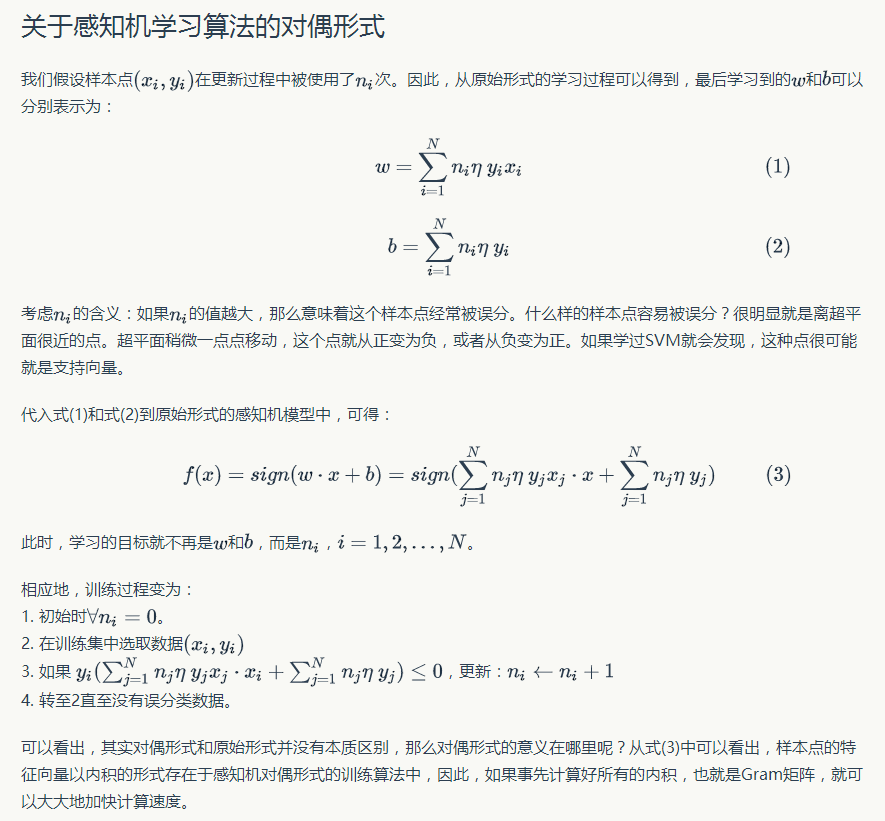

2.对偶形式