原本的目的是想模拟一个流的上传过程,就是一边生成数据,一边存储数据,因为能用上HADOOP通常情况下原本数据的大小就大到本地硬盘存不下。这一般是通过把数据先一部分一部分的缓冲到本地的某个文件夹下,hdfs把缓冲文件夹中的文件一点一点上传,并把上传了的缓冲文件删除。

我这里没有实现数据的分次生成,而是直接用了一个文件,上传的时候模拟缓存一点一点上传。

代码如下:保存为Read2.java

import java.io.File; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FSDataInputStream; import org.apache.hadoop.fs.FSDataOutputStream; import org.apache.hadoop.fs.FileStatus; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; public class Read2{ public static void main(String [] args)throws Exception{ Configuration conf = new Configuration(); FileSystem hdfs = FileSystem.get(conf); FileSystem local=FileSystem.getLocal(conf); Path inputDir = new Path("/home/data/"); //获取本地待被上传的文件 会把该文件夹下的内容都上传 Path hdfsFile = new Path("/acceptFile/"); //获取hdfs上需要获取文件的地址 hdfs.mkdirs(hdfsFile); //在hdfs上新建该文件夹 FileStatus[] inputFiles=local.listStatus(inputDir); //获取本地待上传文件夹的信息 FSDataOutputStream out; for(int i = 0; i < inputFiles.length; i++) //i循环本地文件夹内的文件个数 { System.out.println(inputFiles[i].getPath().getName()); FSDataInputStream in = local.open(inputFiles[i].getPath()); //获取输入流 out = hdfs.create(new Path("/acceptFile/"+inputFiles[i].getPath().getName())); //输出流位置获取 byte buffer[] = new byte[256]; int bytesRead = 0; while((bytesRead = in.read(buffer))>0){ //每次读取buffer大小的部分 out.write(buffer,0,bytesRead); //每次写入buffer中bytesRead大小的部分 } out.close(); in.close(); } } }

代码的运行经过前面的例子已经很熟悉了

bin/hadoop com.sun.tools.javac.Main Read2.java jar cf read2.jar Read2*.class bin/hadoop jar read2.jar Read2

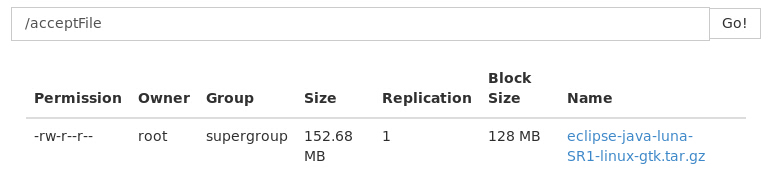

结果:

我本地文件夹下有一个文件,成功的被上传了