上次我们添加了一个add_layer函数,这次就要创建一个神经网络来预测/拟合相应的数据。

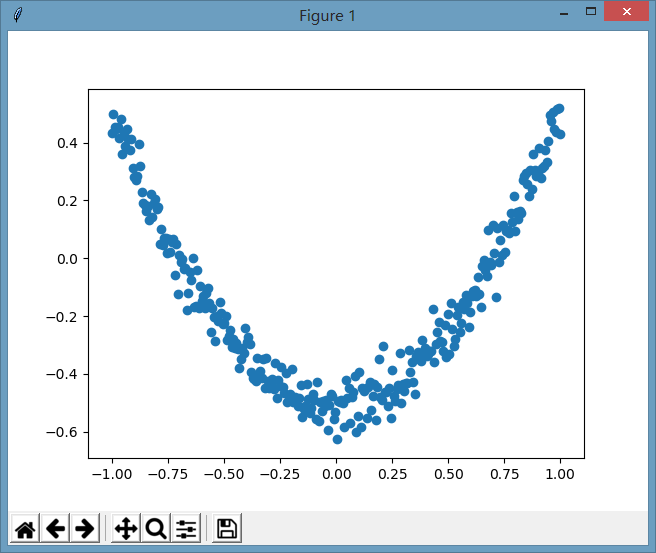

下面我们先来创建一下虚拟的数据,这个数据为二次曲线数据,但同时增加了一些噪点,其图像为:

相应的创建这些伪造数据的代码为:

import numpy as np

# 创建一列(相当于只有一个属性值),300行的x值,这里np.newaxis用于新建出列数据,使其shape为(300, 1)

x_data = np.linspace(-1, 1, 300)[:,np.newaxis]

# 增加噪点,噪点的均值为0,标准差为0.05,形状跟x_data一样

noise = np.random.normal(0, 0.05, x_data.shape)

# 定义y的函数为二次曲线的函数,但同时增加了一些噪点数据

y_data = np.square(x_data) - 0.5 + noise

有了虚拟的数据之后,我们假装不知道这个数据的规律,因此我们想要通过一个神经网络来根据这些数据来发现这些数据所蕴含的规律。

这个神经网络定义了一个隐藏层和一个输出层:

# 定义输入值,这里定义输入值的目的是为了能够使程序比较灵活,可以在神经网络启动时接收不同的实际输入值,这里输入的结构为输入的行数不国定,但列就是1列的值

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

# 定义一个隐藏层,输入为xs,输入size为1列,因为x_data就只有1个属性值,输出size我们假定输出的神经元有10个神经元的隐藏层,激励函数用relu

l1 = add_layer(xs, 1, 10, tf.nn.relu)

# 定义输出层,输入为l1,输入size为10列,也就是l1的列数,输出size为1,因为这里直接输出为类似y_data了,因此为1列,假定没有激励函数,也就是输出是啥就直接传递出去了。

predition = add_layer(l1, 10, 1, activation_function=None)

然后定义损失函数为差值平方和的平均值

# 定义损失函数为差值平方和的平均值

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys - predition), axis=1))

# 进行逐步优化的梯度下降优化器,学习效率为0.1,以最小化损失函数的方式进行优化

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

最后进行初始化和进行训练:

# 初始化所有定义的变量

init = tf.global_variables_initializer()

sess = tf.Session()

sess.run(init)

# 学习1000次

for i in range(1000):

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

# 打印期间的误差值,看这个误差值是否在减少

if i % 50 == 0:

print(sess.run(loss, feed_dict={xs:x_data, ys:y_data}))

完整的代码为:

import tensorflow as tf

def add_layer(inputs, in_size, out_size, activation_function=None):

"""

添加层

:param inputs: 输入数据

:param in_size: 输入数据的列数

:param out_size: 输出数据的列数

:param activation_function: 激励函数

:return:

"""

# 定义权重,初始时使用随机变量,可以简单理解为在进行梯度下降时的随机初始点,这个随机初始点要比0值好,因为如果是0值的话,反复计算就一直是固定在0中,导致可能下降不到其它位置去。

Weights = tf.Variable(tf.random_normal([in_size, out_size]))

# 偏置shape为1行out_size列

biases = tf.Variable(tf.zeros([1, out_size]) + 0.1)

# 建立神经网络线性公式:inputs * Weights + biases,我们大脑中的神经元的传递基本上也是类似这样的线性公式,这里的权重就是每个神经元传递某信号的强弱系数,偏置值是指这个神经元的原先所拥有的电位高低值

Wx_plus_b = tf.matmul(inputs, Weights) + biases

if activation_function is None:

# 如果没有设置激活函数,则直接就把当前信号原封不动地传递出去

outputs = Wx_plus_b

else:

# 如果设置了激活函数,则会由此激活函数来对信号进行传递或抑制

outputs = activation_function(Wx_plus_b)

return outputs

import numpy as np

# 创建一列(相当于只有一个属性值),300行的x值,这里np.newaxis用于新建出列数据,使其shape为(300, 1)

x_data = np.linspace(-1, 1, 300)[:,np.newaxis]

# 增加噪点,噪点的均值为0,标准差为0.05,形状跟x_data一样

noise = np.random.normal(0, 0.05, x_data.shape)

# 定义y的函数为二次曲线的函数,但同时增加了一些噪点数据

y_data = np.square(x_data) - 0.5 + noise

# 定义输入值,这里定义输入值的目的是为了能够使程序比较灵活,可以在神经网络启动时接收不同的实际输入值,这里输入的结构为输入的行数不国定,但列就是1列的值

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

# 定义一个隐藏层,输入为xs,输入size为1列,因为x_data就只有1个属性值,输出size我们假定输出的神经元有10个神经元的隐藏层,激励函数用relu

l1 = add_layer(xs, 1, 10, tf.nn.relu)

# 定义输出层,输入为l1,输入size为10列,也就是l1的列数,输出size为1,因为这里直接输出为类似y_data了,因此为1列,假定没有激励函数,也就是输出是啥就直接传递出去了。

predition = add_layer(l1, 10, 1, activation_function=None)

# 定义损失函数为差值平方和的平均值

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys - predition), axis=1))

# 进行逐步优化的梯度下降优化器,学习效率为0.1,以最小化损失函数的方式进行优化

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

# 初始化所有定义的变量

init = tf.global_variables_initializer()

sess = tf.Session()

sess.run(init)

# 学习1000次

for i in range(1000):

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

# 打印期间的误差值,看这个误差值是否在减少

if i % 50 == 0:

print(sess.run(loss, feed_dict={xs:x_data, ys:y_data}))

执行后输出为:

0.558202

0.0136704

0.0095978

0.00769082

0.00639173

0.00552368

0.00489246

0.00448871

0.00421288

0.00402797

0.00389303

0.00378238

0.00370672

0.0036429

0.0035787

0.00350686

0.00344219

0.00338799

0.00332198

0.00326401