ceph简介:

Ceph是一种为优秀的性能、可靠性和可扩展性而设计的统一的、分布式文件系统。ceph 的统一体现在可以提供文件系统、块存储和对象存储,分布式体现在可以动态扩展。在国内一些公司的云环境中,通常会采用 ceph 作为openstack 的唯一后端存储来提高数据转发效率。

Ceph项目最早起源于Sage就读博士期间的工作(最早的成果于2004年发表),并随后贡献给开源社区。在经过了数年的发展之后,目前已得到众多云计算厂商的支持并被广泛应用。RedHat及OpenStack都可与Ceph整合以支持虚拟机镜像的后端存储。

网站:

ceph特点

高性能:

- 摒弃了传统的集中式存储元数据寻址的方案,采用CRUSH算法,数据分布均衡,并行度高。

- 考虑了容灾的隔离, 能够实现各类负载的副本放置规则,跨机房,机架感知等。

- 能够支持上千个存储结点的规模,支持TB到PB级的数据

高可用:

- 副本数可以灵活控制

- 支持故障域分离,数据强一致性

- 多种故障场景进行自动修复自愈

- 没有单点故障,自动管理

高扩展性

- 去中心化

- 扩展灵活

- 随着节点增长而线性增长

特点丰富:

- 支持三种存储接口:块存储、文件存储、对象存储

- 支持自定义接口,支持多种语言驱动。

ceph应用

- ceph 可以提供对象存储、块设备存储和文件系统储存,

- 一般我们主要关心的还是块存储;其块设备存储可以对接(IaaS),当前主流的IaaS运平台软件,如:OpenStack、CloudStack、Zstack、Eucalyptus等以及kvm等

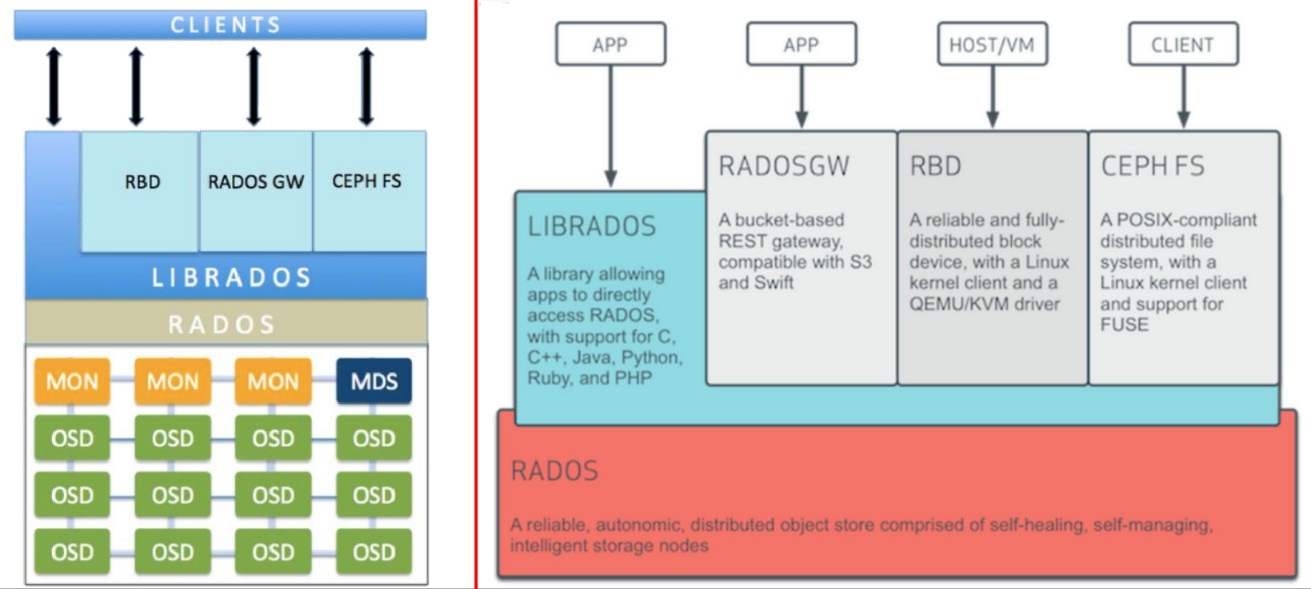

ceph 核心组件

- Monitors: 监视器,维护集群的状态的多种映射,同时提供认证和日志记录服务,包括monitor节点端到端的信息,其中包括ceph集群ID,监控主机名和IP以及端口。并且存储当前版本信息以及最新更改信息,(通过 "ceph mon" 查看monitor map)

- MDS(Metadata Server): ceph 元数据,主要保存ceph文件系统的元数据。注意:ceph的 块存储和对象存储都不需要MDS

- OSD(Object Storage Device): 它的主要功能是存储数据、复制数据、平衡数据、恢复数据等,与其它OSD间进行心跳检查等,并将一些变化情况上报给Ceph Monitor。一般情况下一块硬盘对应一个OSD,由OSD来对硬盘存储进行管理,当然一个分区也可以成为一个OSD.

伴随OSD的还有一个概念叫做Journal盘,一般写数据到Ceph集群时,都是先将数据写入到Journal盘中,然后每隔一段时间比如5秒再将Journal盘中的数据刷新到文件系统中。- RADOS(Reliable Autonomic Distributed Object Store): RADOS是ceph存储集群的基础,RADOS中的存储节点被称为OSD,在ceph中,所有数据都以对象的形式存储,并且无论什么数据类型,RADOS对象存储都将负责保存这些对象。RADOS层可以确保数据始终保持一致。

- librados: librados库,为应用程序提供访问接口,同时也为块存储、对象存储、文件系统提供原生接口。

- RADOSGW: 网关接口,提供对象存储服务。它使用librgw和librados来实现允许应用程序与Ceph对象存储建立连接。并且提供S3 和 Swift 兼容的RESTful API接口。

- RBD: 块设备,他能够自动精简配置并可以调整大小,而且将数据分散存储在多个OSD上。

- CephFS: CephFS:Ceph文件系统,与POSIX兼容的文件系统,基于librados封装原生接口。

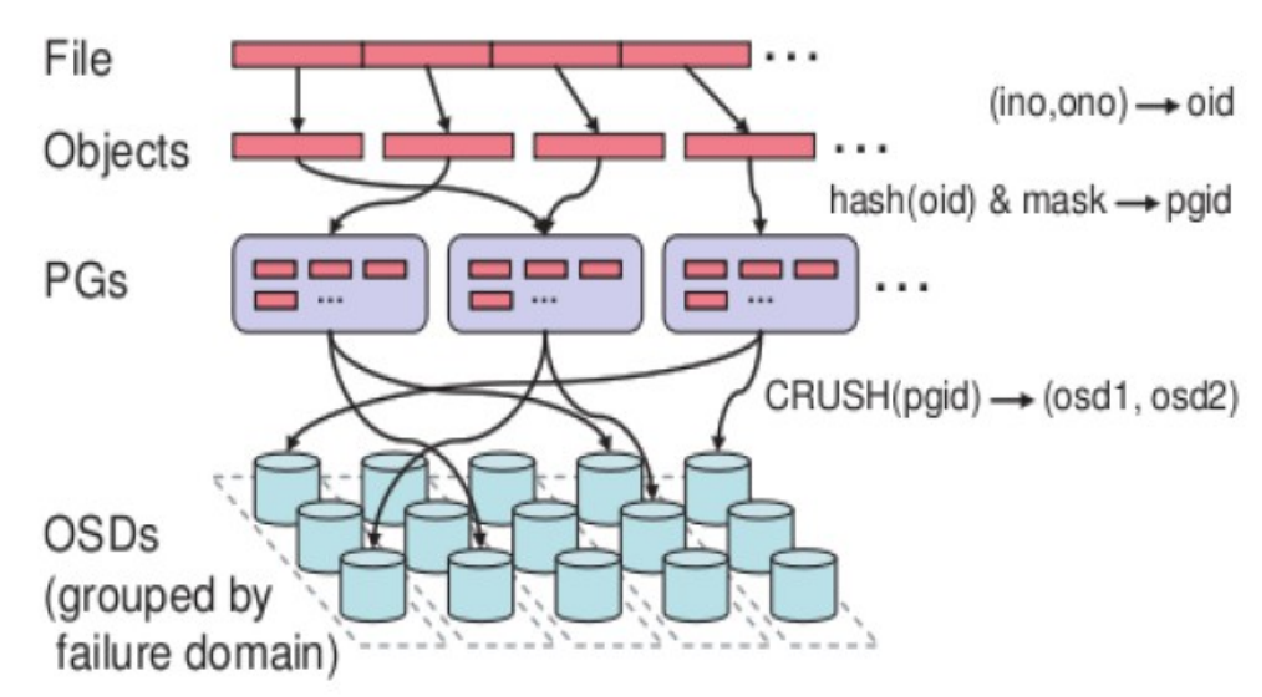

ceph数据存储过程

无论使用哪种存储方式(对象、块、文件系统),存储的数据都会切分成Object;Object size 大小可以由管理员调整,通常为2M或4M。每个对象都会有一个唯一的OID,由ino和ono生成,

- ino:即是文件的File ID,用于在全局唯一标识每一个文件

- ono:则是分片的编号

- file:用户需要访问和存储的数据

- object:RADOS的基本存储单元

- PG(Placement Group):对object的存储进行组织和位置映射;

- OSD:object storage dervice

三次映射:

- File -> object映射

- Object -> PG映射,hash(oid) & mask -> pgid

- PG -> OSD映射,CRUSH算法