神经网络的复杂度:可用神经网络的层数和神经网络中待优化参数个数表示

神经网路的层数:一般不计入输入层,层数 = n 个隐藏层 + 1 个输出层

神经网路待优化的参数:神经网络中所有参数 w 的个数 + 所有参数 b 的个数

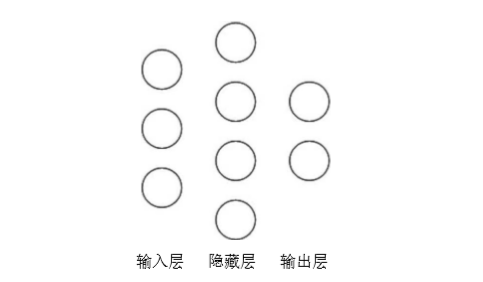

如:

在该神经网络中,包含 1 个输入层、1 个隐藏层和 1 个输出层,该神经网络的层数为 2 层。

在该神经网络中,参数的个数是所有参数 w 的个数加上所有参数 b 的总数,第一层参数用三行四列的二阶张量表示(即 12 个线上的权重 w)再加上 4 个偏置 b;

第二层参数是四行两列的二阶张量()即8 个线上的权重 w)再加上 2 个偏置 b。总参数 = 3*4+4 + 4*2+2 = 26。

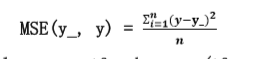

损失函数(loss): 用来表示预测值(y)与已知答案(y_)的差距。在训练神经网络时,通过不断改变神经网络中所有参数,使损失函数不断减小,从而训练出更高准确率的神经网络模型。

常用的损失函数有均方误差、自定义和交叉熵等。

均方误差 mse:n 个样本的预测值 y 与已知答案 y_之差的平方和,再求平均值。 在 Tensorflow 中用 loss_mse = tf.reduce_mean(tf.square(y_ - y))