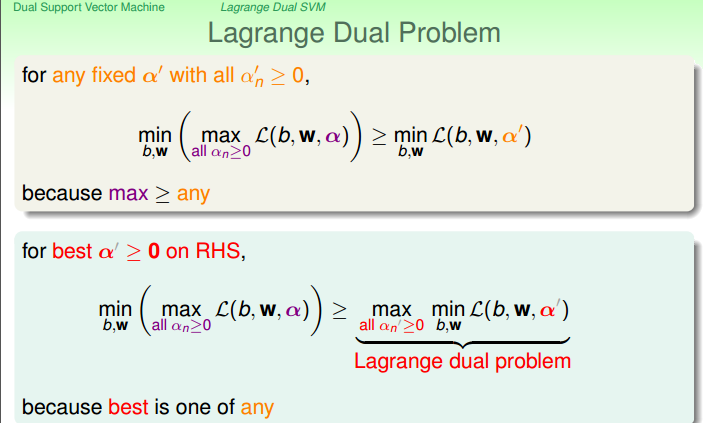

Lagrange的推导,为什么是先求最大值再求最小值

当b,w不满足条件时,也就是说 这一项是大于零的,因为an也是非负的,所以后面这一项是始终大于等于零的,如果求最大值会趋向于无穷大。

这一项是大于零的,因为an也是非负的,所以后面这一项是始终大于等于零的,如果求最大值会趋向于无穷大。

当b,w满足条件时, 这一项是小于等于零的,因为an也是非负的,所以后面这一项是始终小于等于零的,如果求最大值则是零,剩下的就是

这一项是小于等于零的,因为an也是非负的,所以后面这一项是始终小于等于零的,如果求最大值则是零,剩下的就是

这种先求最大值再求最小值的做法满足我们的优化目标。

为了对w,b的最优化问题变成没有条件的,所以将原始问题转化为对偶问题。对偶的推导,怎么转换成对偶问题的:

soft-margin:

防止过拟合,适用于非线性

C越大,允许犯的错越少。C越小,允许的错误越多,边界越宽。

ξi表示违反了多少,ξi =0表示没有违反此时(xi,yi)在边界上,0< ξi < 1表示(xi,yi)在边界与超平面之间,

ξi = 1表示(xi,yi)在超平面上, ξi > 1 表示(xi,yi越过了超平面,分类错误)

核技巧

用线性分类方法解决非线性分类问题,使用一个变换将原数据空间的数据映射到新空间,然后在新空间里用线性分类学习方法从训练数据中学习分类模型

核技巧应用到svm就是将一个非线性变换输入空间(欧式空间或离散集合)对应于一个特征空间(希尔伯特空间),使得在输入空间的超曲面模型对应于特征空间中的超平面模型,然后通过在特征空间中使用线性支持向量机就可以完成分类。

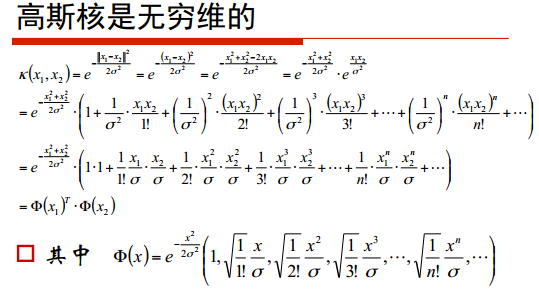

高斯核是无穷维的可以由泰勒展开来证明。