视频学习心得

学习心得

常虹

卷积神经网络是在层级网络的基础上进行了层的功能和形式的变化,每层包含多个二维平面,每个平面包含多个独立的神经元,是传统神经网络的一个改进,其中需要卷积运算的一个过程,包括卷积核和池化运算。其中的这些层次和结构可以进行相应调整,多次进行。是神经网络的一个重要提升。在代码练习中,最后一个代码练习看到群里老师和同学的修改运行了一遍但是还是不知道为什么要真没改,还真就没体会到。。。。。。。。/(ㄒoㄒ)/~~

多家赫

第一个视频讲了玻尔兹曼机的理论和编码还有机器学习的学习的基础。另外提到了概率论、线性代数的重要作用,揭示了数学对于这门课程的重要性。机器学习的三要素是模型、策略、算法。还有提到了机器学习应用概率的两学派,频率学派和贝叶斯学派。第二个视频讲了卷积神经网络的应用,他们是分类,检索,检测,分割,人脸识别,表情识别,图像生成,自动驾驶。后面介绍了卷积神经网络相对于传统的网络的优点,局部关联,参数共享。

余闽喆

观看视频后,我明白卷积神经网络在分类、检索、检测、分割等多方面有着重要应用,具体的应用有人脸识别、表情识别、图像生成、图像风格转化、自动驾驶等,了解了卷积神经网络的基本组成结构:卷积、池化、全连接。一个典型的卷积网络就是由卷积层、池化层、全连接层交叉堆叠而成的。跟随老师一起了解了卷积神经网络的一些典型结构,如AlexNet、 ZFNet、VGG、 GoogleNet和 ResNet。在计算机视觉领域,卷积神经网络相对于传统神经网络来说,具有局部感知、权重共享、池化三大优点。传统的神经网络学习不到图像的一些结构信息,而卷积网络可以。举个例子,我们人类在看一张照片的时候,会观察画面的整体布局,传统的全连接层则不能较为直观的感受到布局信息。另外从计算上来说,卷积层减少了参数数量,从而降低了模型的复杂度,使得在版本空间里搜索更可行。

傅芷琴

参数量

未加padding输出的特征图大小:(N-F)/stride+1

有padding输出的特征图:(N+padding *2-F)/stride+1

池化:

pooling

保留主要特征的同时减少参数和计算量,防止过拟合,提高模型泛化能力

一般位于卷积层和卷积层之间,全连接层和全连接层之间

类型:

最大值池化

平均值池化

全连接层:

参数量大,通常全连接层在卷积神经网络尾部。

AlexNet

大数据训练

非线性激活函数

防止过拟合

双CPU实现

优点:

解决梯度消失问题(正区间)

计算速度特别快,只需要判断是否大于0

收敛速度远快于sigmoid

数据增强

AlexNet

第一-五层卷积:

卷积-ReLU-池化

第六-七层

全连接-ReLU-RropOut

第八层

全连接-SoftMax

ZFNex

VGG

GoogleNex

总体结构:

带参数22个层,含polling的话27,独立成块约100个

参数量大概是Alexnet的1/12

没有FC层

多卷积核增加特征多样性

降低参数量

增加非线性激活函数

输出:类别输出层

ResNex

残差学习网络

错误率降低

深度152层

残差:去掉相同主体,突出微小变化,可以用来训练非常深网络

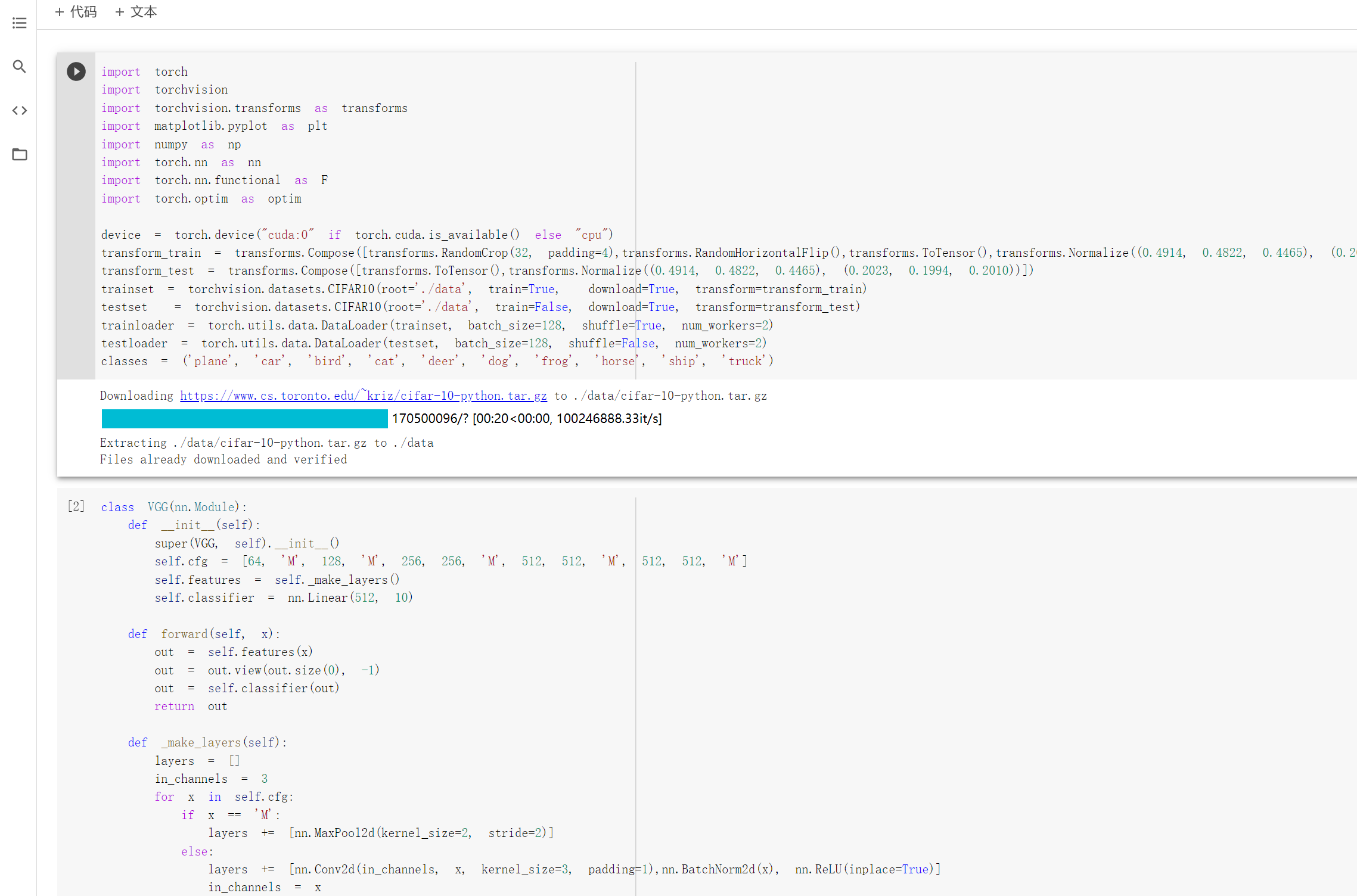

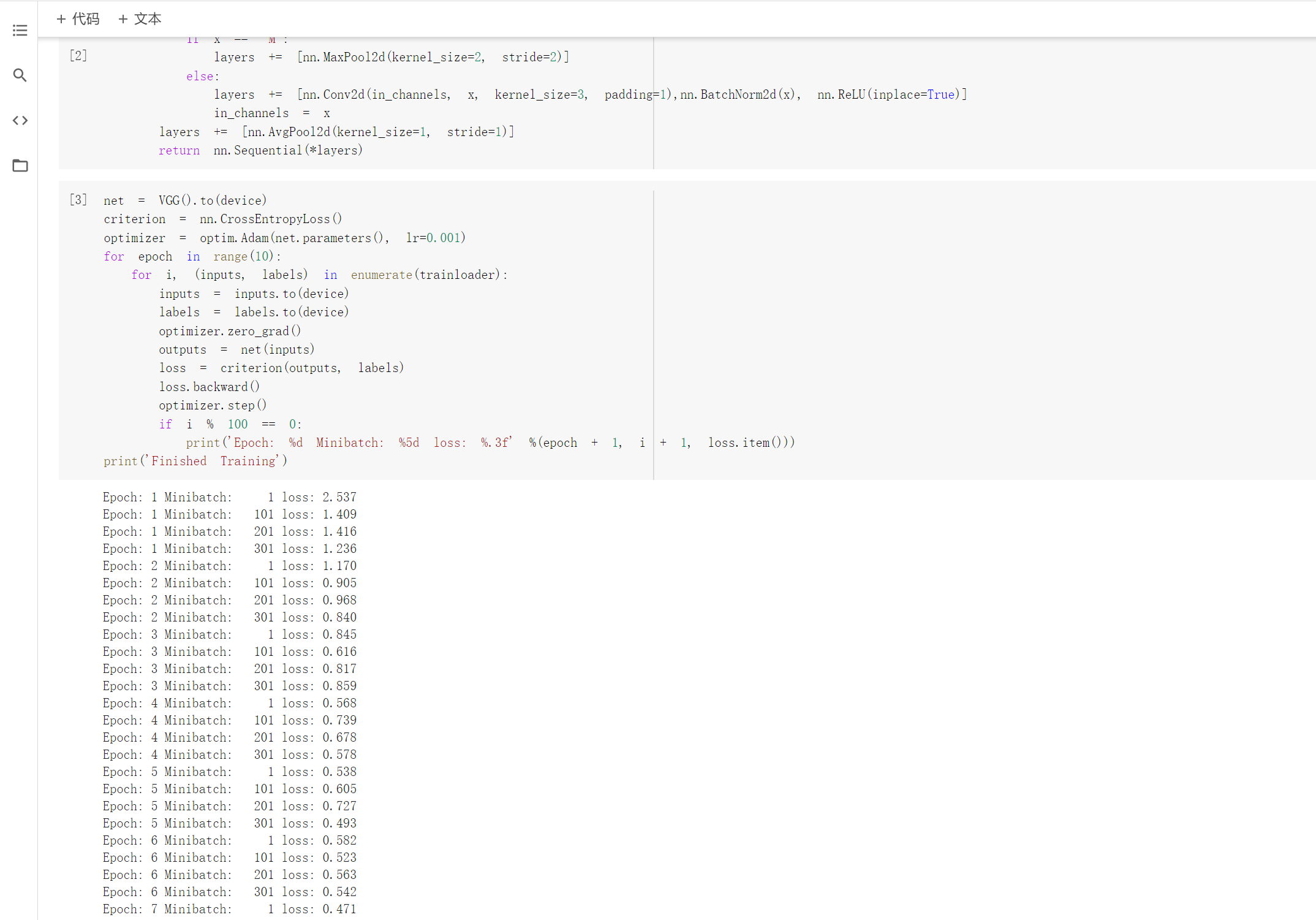

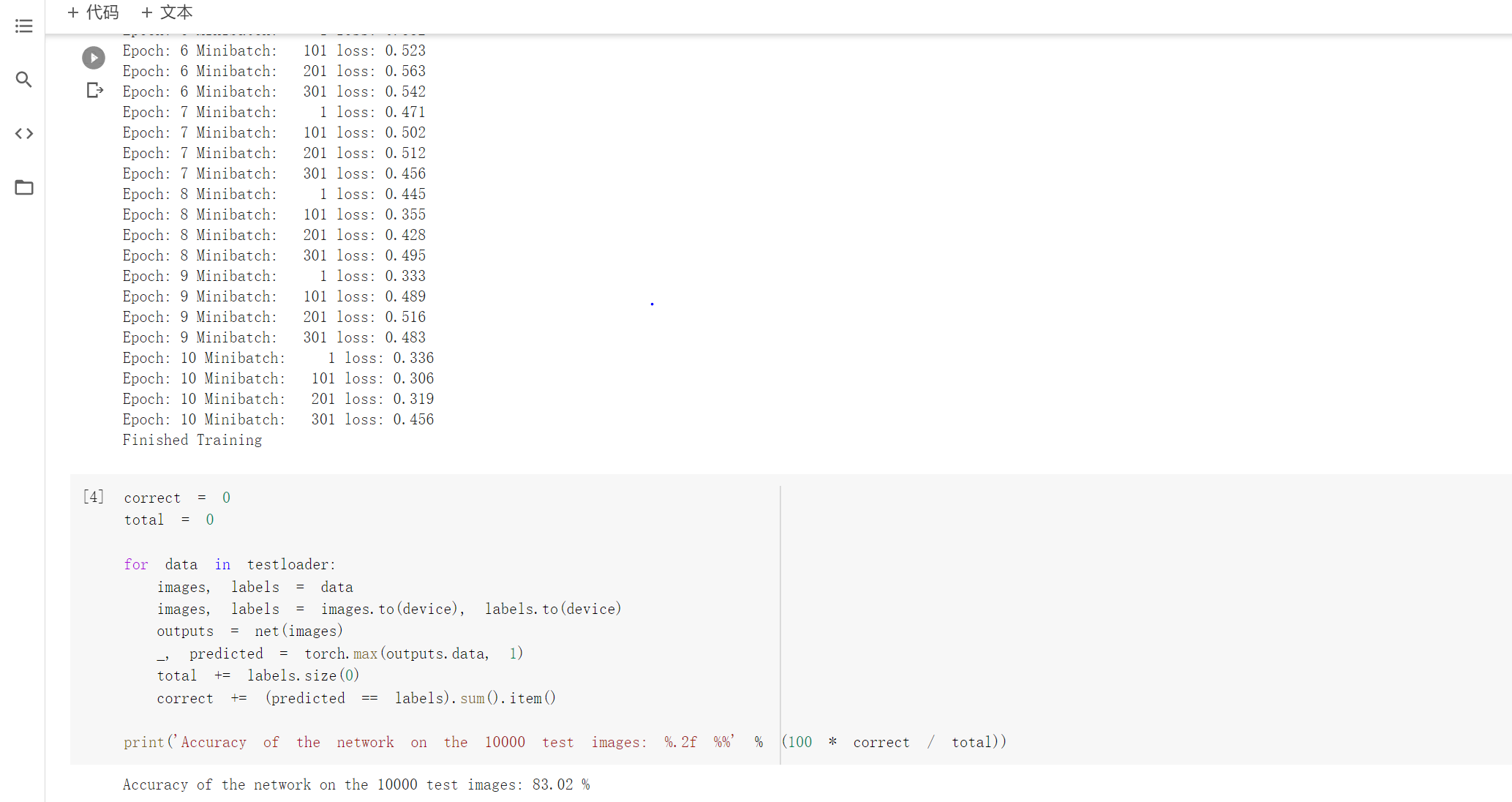

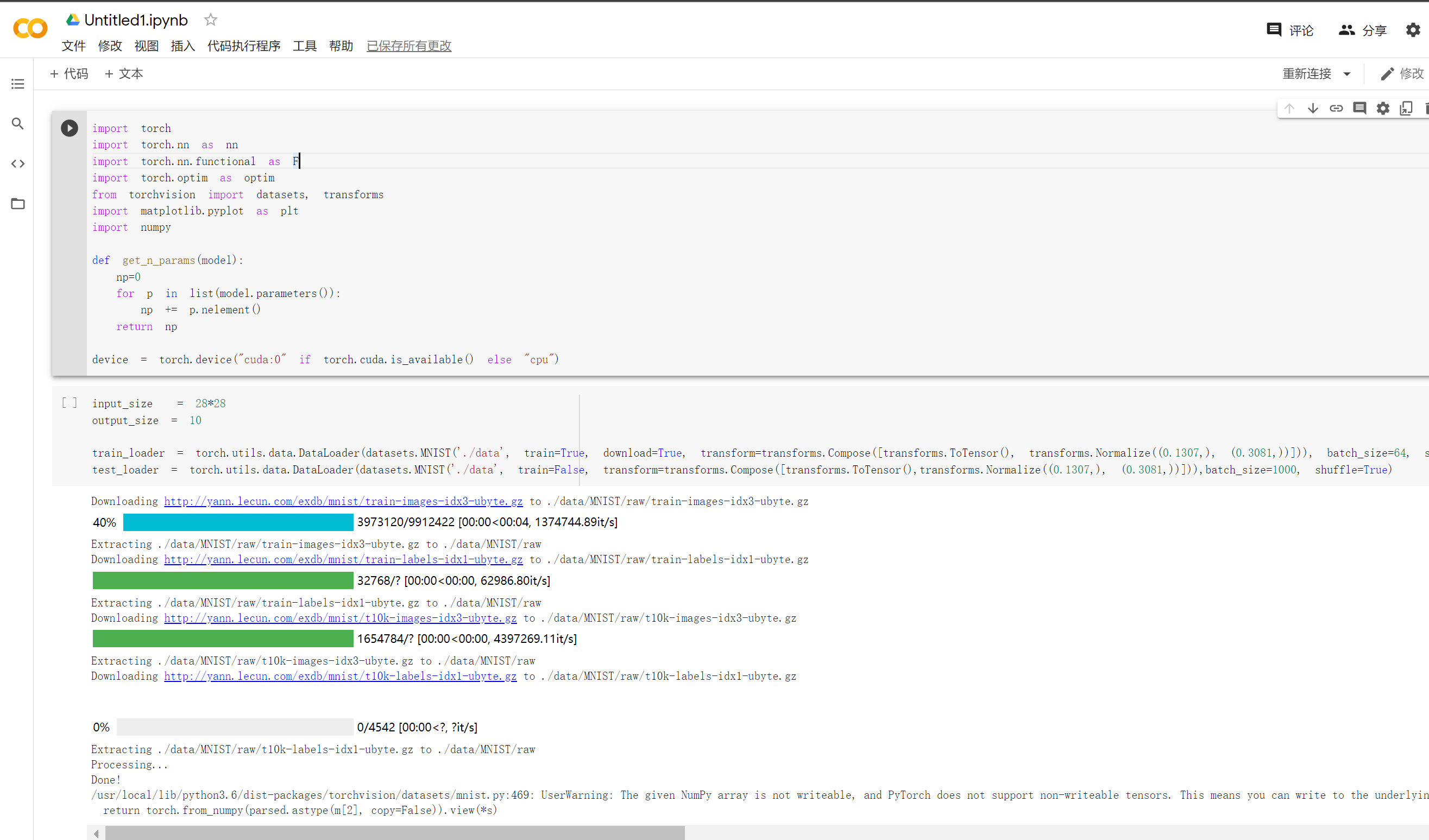

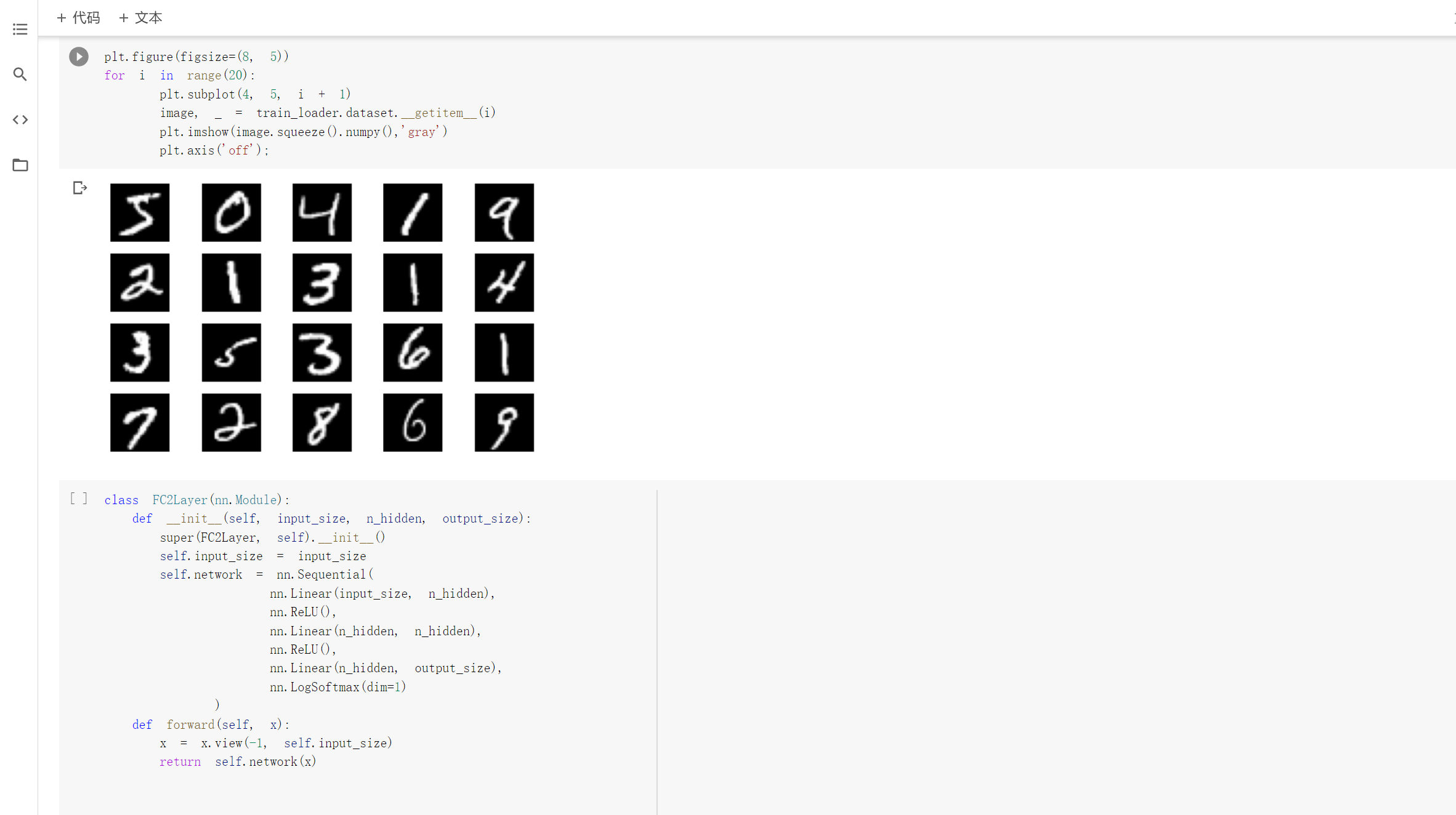

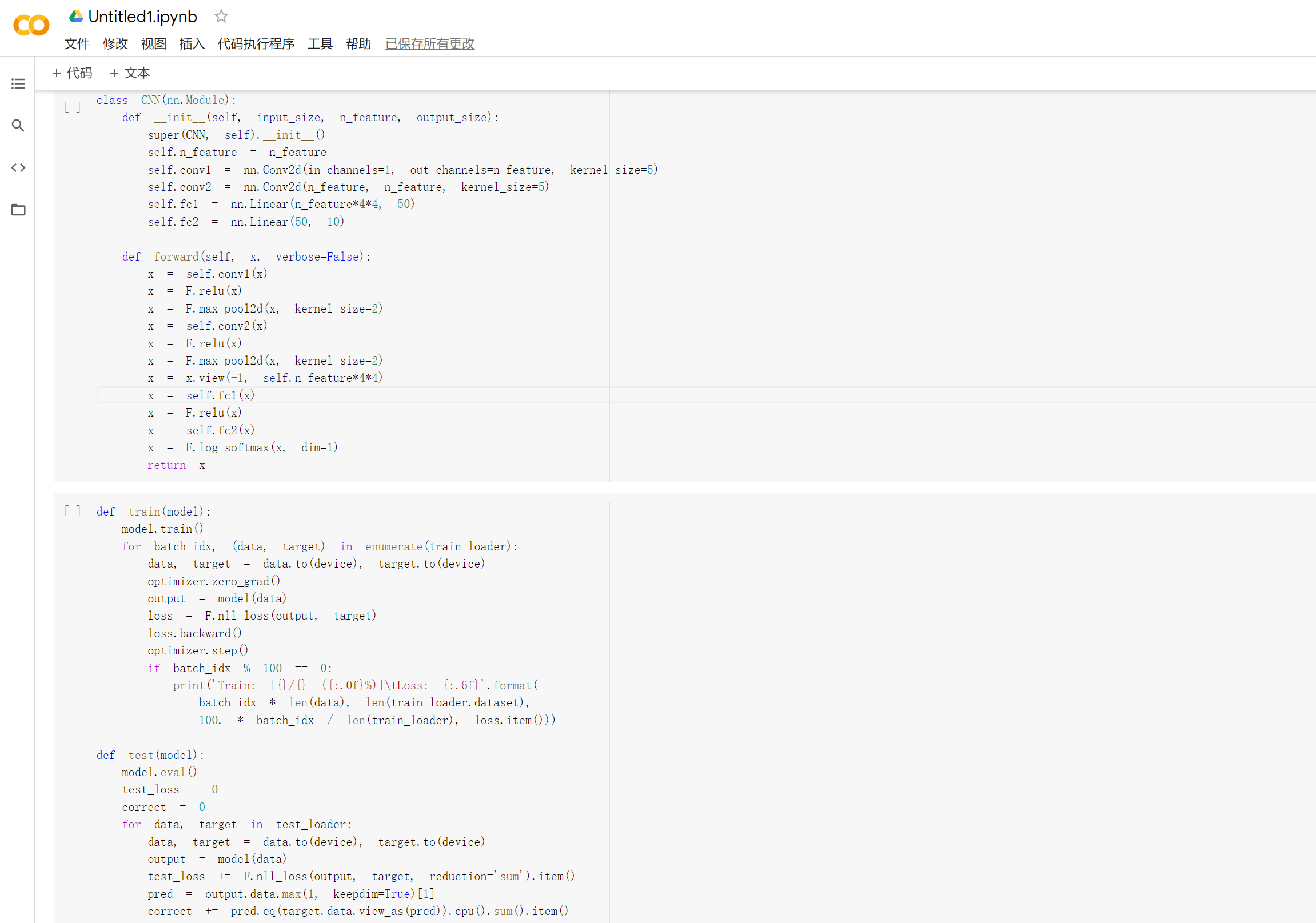

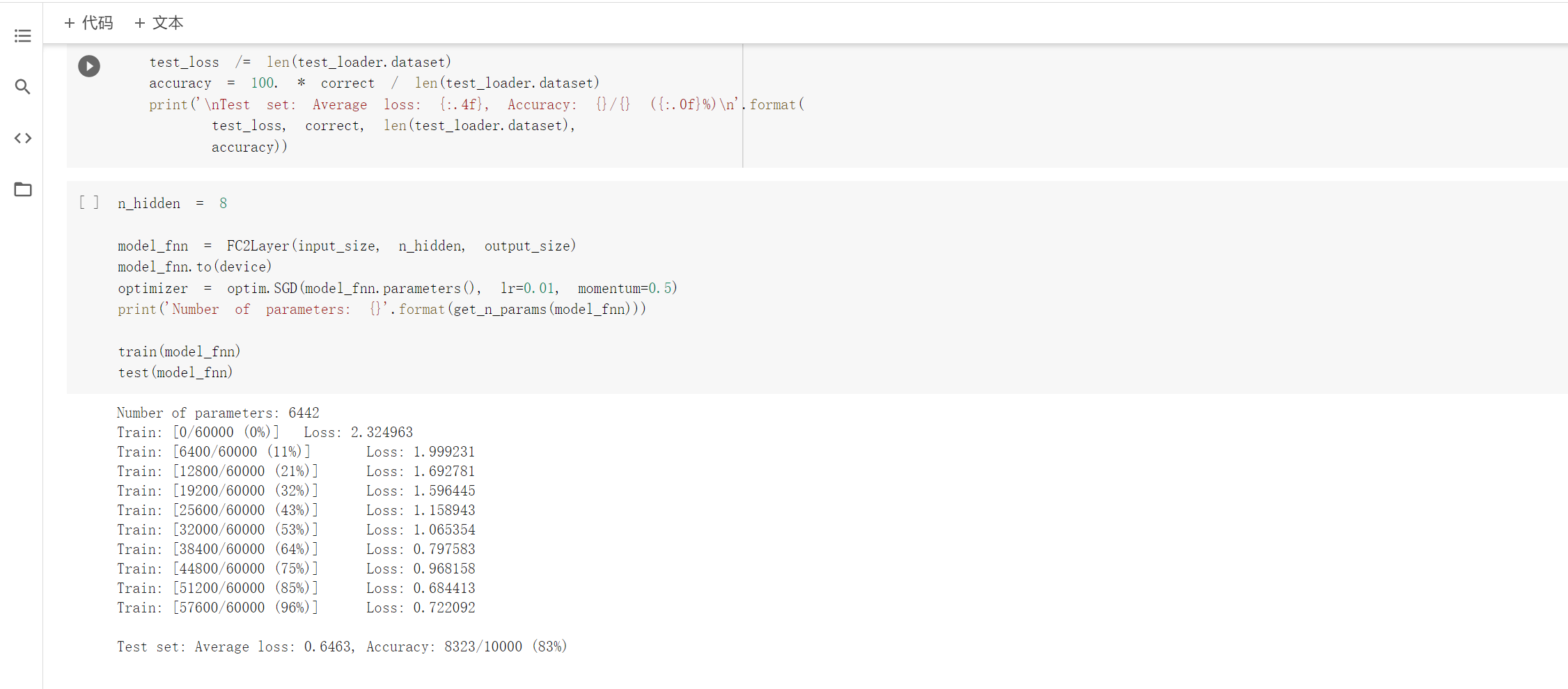

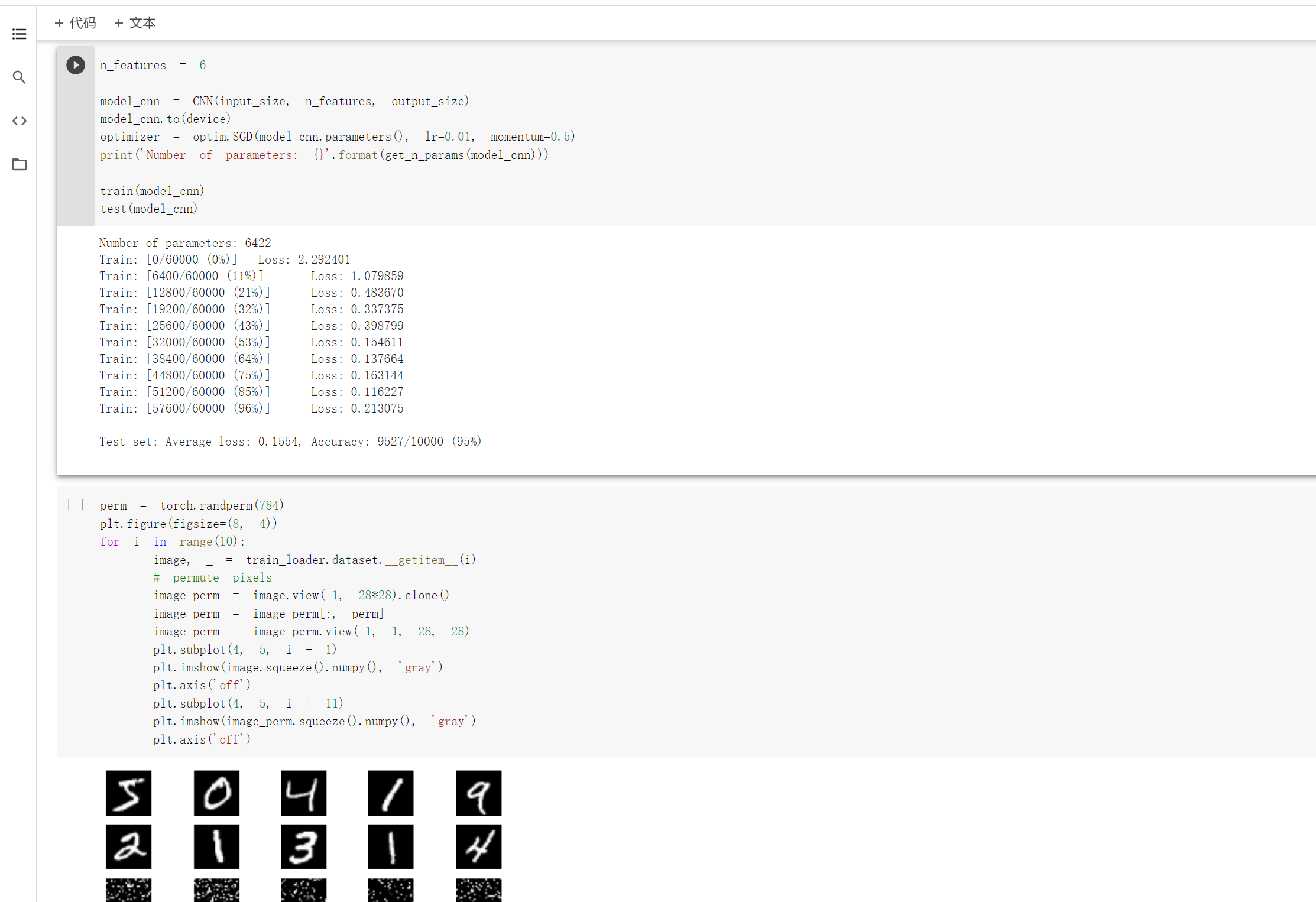

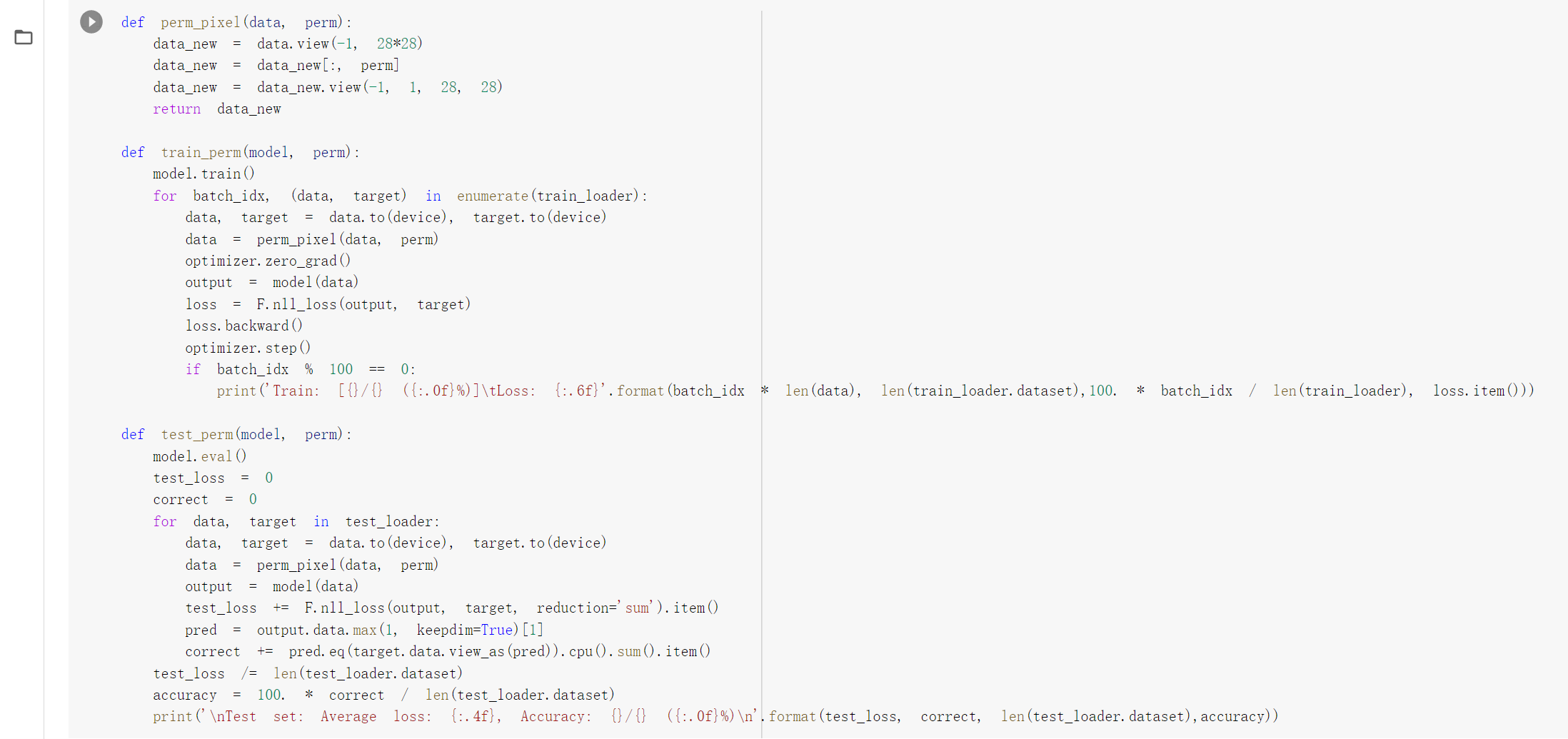

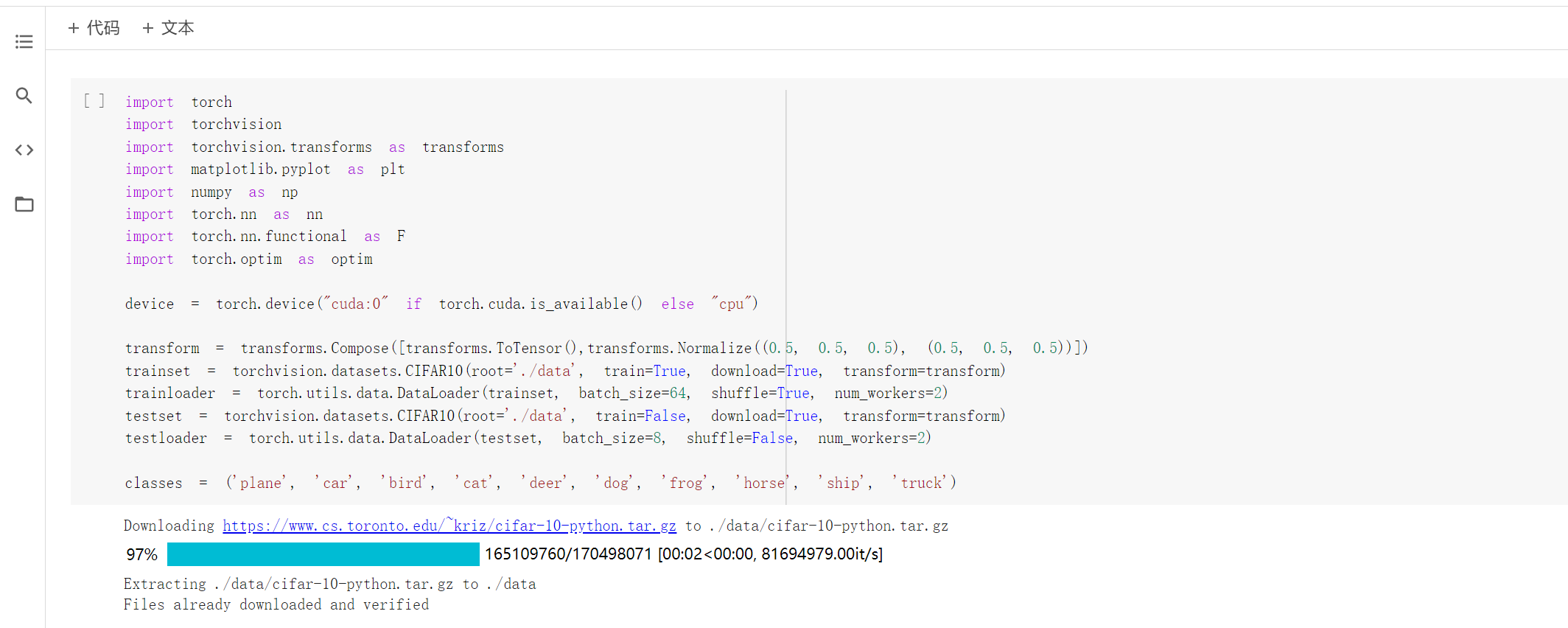

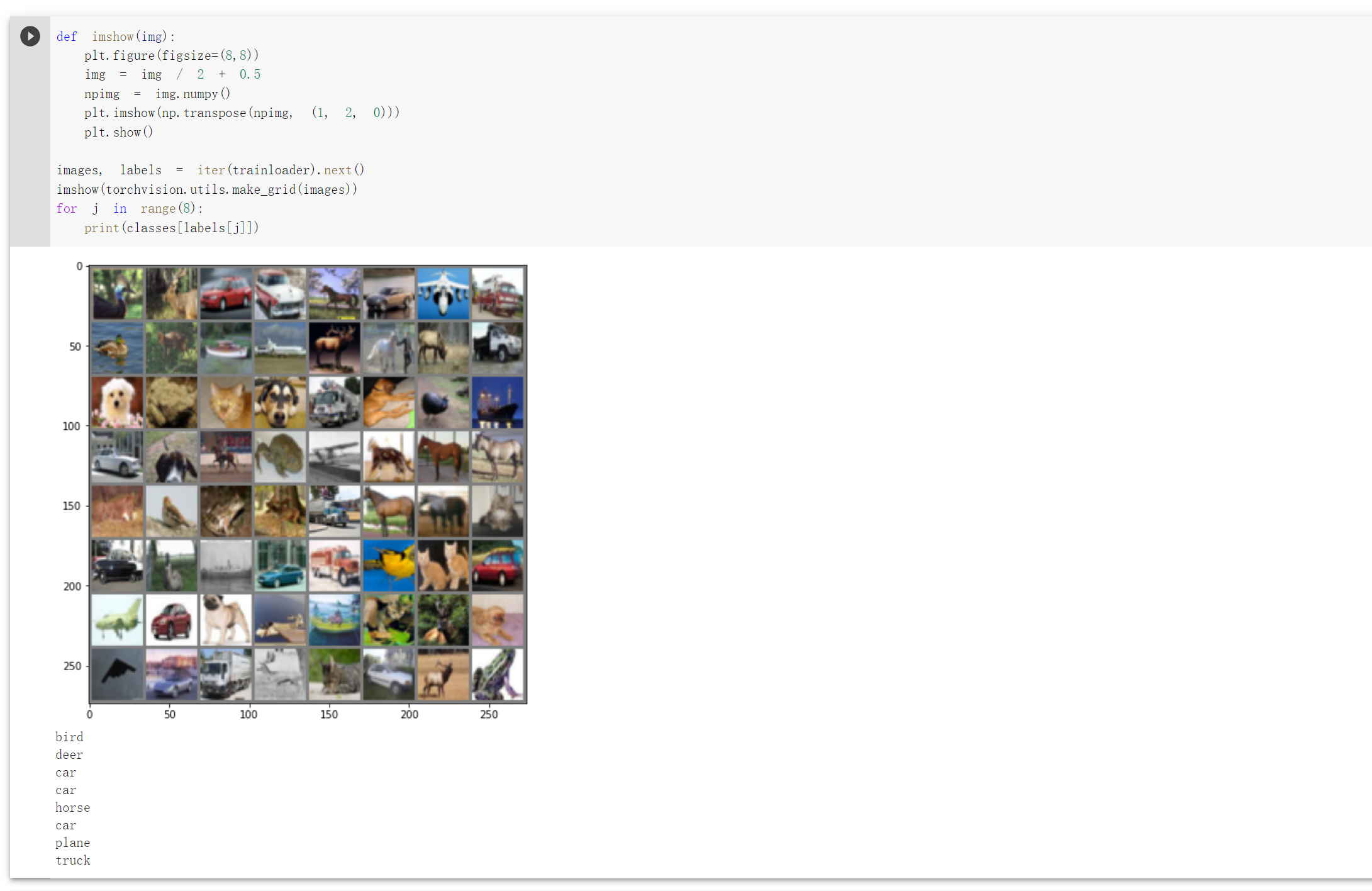

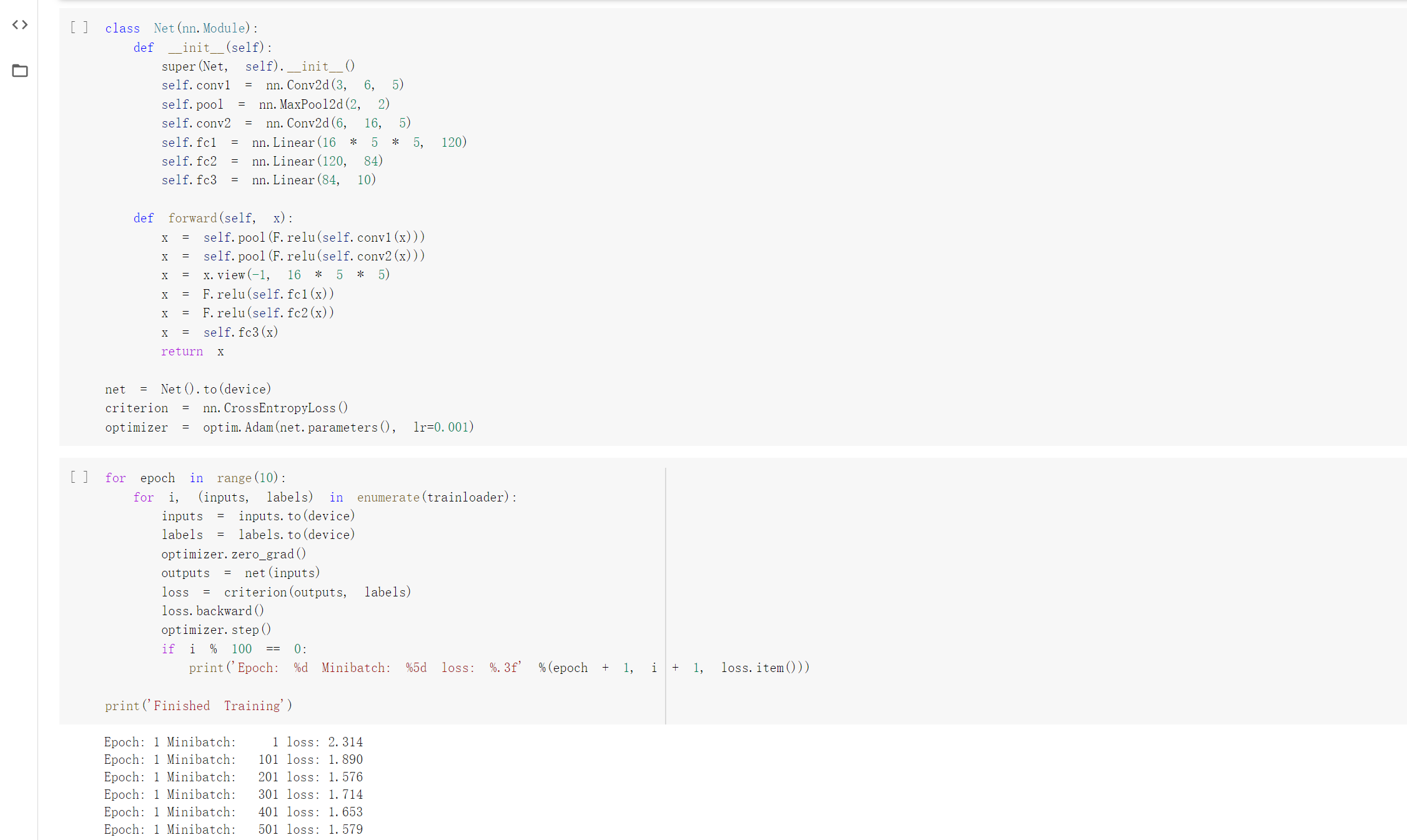

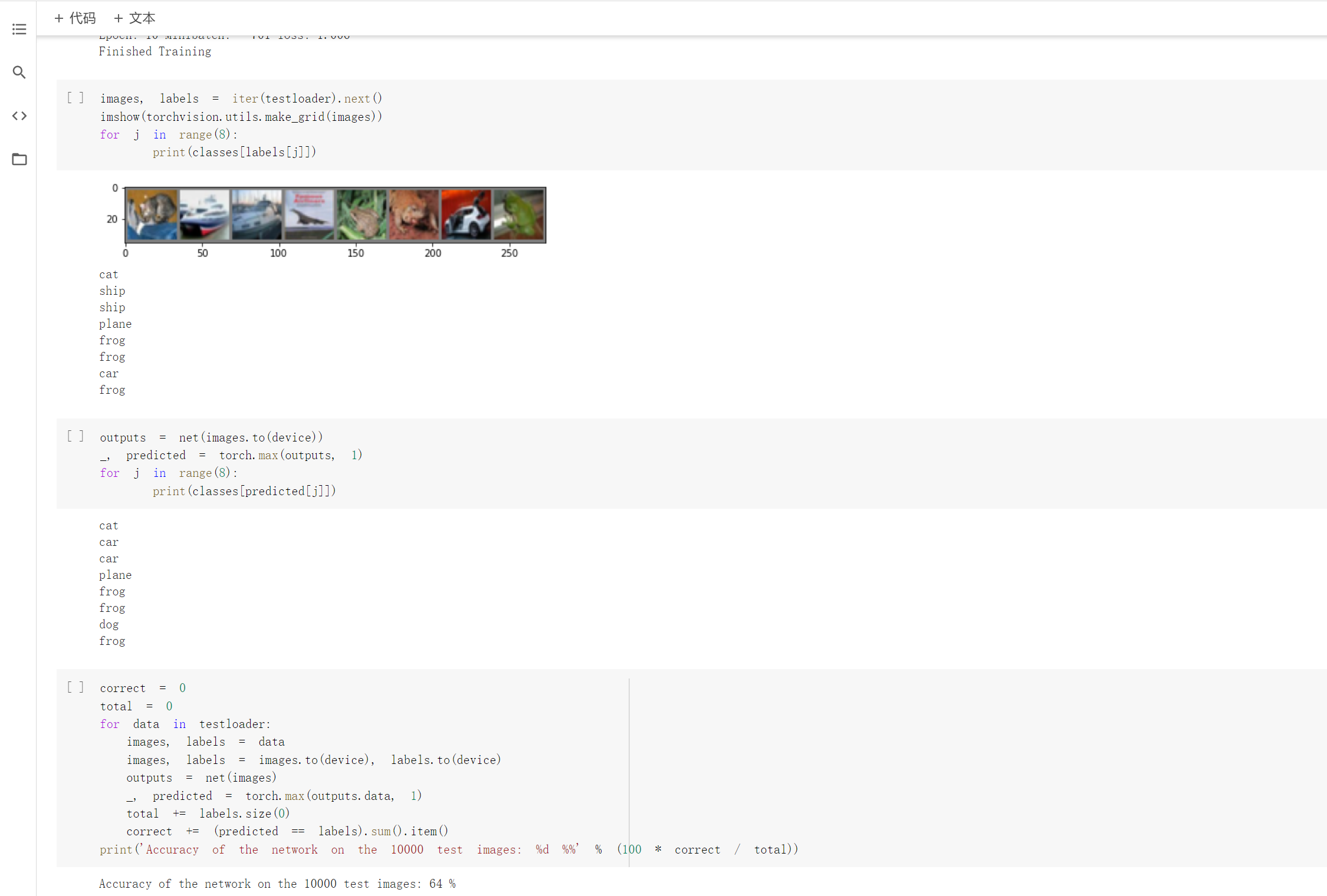

构建简单的CNN对 mnist 数据集进行分类的过程中,在创建网络之后,做好定义以及测试函数等之后通过在全连接网络以及CNN训练后发现含有相同参数的CNN效果要明显优于简单的全连接网络,因为CNN通过池化和卷积能够更好的挖掘图像中的信息,通过打乱像素顺序的方法破坏池化和卷积的作用来验证因为池化和卷积所以CNN训练效果比全连接网络好,验证成功,的确如此。使用 CNN 和VGG16网络对 CIFAR10 数据集进行分类VGG16效果更好。

邓皓文

第一个视频讲机器学习数学基础和机器学习三要素(模型,策略以及算法)学习了梯度下降是神经网络的共同基础,以及奥卡姆剃刀原理选择最简单的模型。还有介绍了频率学派贝叶斯学派两种可能性学派。和beyond深度学习。第二个视频讲卷积神经网络的应用以及基本组成结构(卷积、池化、全连接)和卷积神经网络典型结构(1.AlexNet 2.ZFNet 3.vGG 4.GoogleNet 5.ResNet)

问题1:训练模型怎么解决遇到特殊情况下的识别问题?

问题2:损失函数原理应用到现实还是不太了解。

杨思恒

机器学习中运用到了大量线性代数、概率论(信息论)和高等数学的知识。数据的表示和数据空间变换是基于线性代数,而模型假设和策略设计是基于概率论,求解目标函数的具体算法就要用到微积分的知识。在神经网络中,梯度下降时所有神经网络模型的共同基础。

机器学习的三要素是模型(问题建模,确定假设空间)、策略(确定目标函数)和算法(求解模型参数)。

神经网络在训练时可能会出现欠拟合或者过拟合的情况。解决欠拟合需要提高模型复杂度,而解决过拟合需要降低模型的复杂度。

卷积神经网络在分类、检索、检测、分割、人脸识别、表情识别、图像生成、图像风格转化、自动驾驶中都有着广泛的应用。

相比于传统的全连接神经网络存在的参数过多容易过拟合的特点,卷积神经网络局部管理,参数共享。

卷积神经网络的基本结构是卷积、池化、全连接。卷积是对两个实变函数的一种数学操作;池化保留了主要特征的通识减少参数和计算量,防止过拟合,提高模型泛化能力;全连接是两层之间所有神经元都有权重链接,全连接层参数量是最大的。

此外,视频还介绍了几种卷积神经网络典型结构:AlexNet、ZFNet、VGG、GoogleNet、ResNet。

问题总结

上述几种的典型的神经网络是怎么构造设想出来的?

神经网络结构的调整思路是什么?

卷积层、池化层、全连接层在排列连接上有什么特点和要求?

为什么打乱像素点的顺序后,卷积神经网络的卷积和池化就不起作用了?

卷积和池化具体是怎么发挥作用的?

AlexNet卷积层怎么分的层,不能太理解?

GoogleNex降维那一块不太会。

代码部分

实验一

感想:通过实验发现,卷积神经网络通过卷积层和池化层训练效果要比简单的全连接神经网络好,简单的全连接神经网络的准确率有83%,而卷积神经网络的准确率达到了96%。但是如果打乱像素顺序后训练,发现简单的全连接神经网络的准确率有89%,卷积神经网络却只有83%。

实验二

实验三

感想:发现通过调整了神经网络的结构就能够显著的提高识别准确率。如果继续调整神经网络的结构,准确应该还能进一步提升。