NFS服务简介

什么是NFS?

NFS就是Network File System的缩写,它最大的功能就是可以通过网络,让不同的机器、不同的操作系统可以共享彼此的文件。

NFS服务器可以让PC将网络中的NFS服务器共享的目录挂载到本地端的文件系统中,而在本地端的系统中来看,那个远程主机的目录就好像是自己的一个磁盘分区一样,在使用上相当便利;

NFS一般用来存储共享视频,图片等静态数据。

NFS挂载原理:

图;服务器挂载结构图

如上图示:

当我们在NFS服务器设置好一个共享目录/home/public后,其他的有权访问NFS服务器的NFS客户端就可以将这个目录挂载到自己文件系统的某个挂载点,这个挂载点可以自己定义,如上图客户端A与客户端B挂载的目录就不相同。并且挂载好后我们在本地能够看到服务端/home/public的所有数据。如果服务器端配置的客户端只读,那么客户端就只能够只读。如果配置读写,客户端就能够进行读写。挂载后,NFS客户端查看磁盘信息命令:#df –h。

既然NFS是通过网络来进行服务器端和客户端之间的数据传输,那么两者之间要传输数据就要有想对应的网络端口,NFS服务器到底使用哪个端口来进行数据传输呢?基本上NFS这个服务器的端口开在2049,但由于文件系统非常复杂。因此NFS还有其他的程序去启动额外的端口,这些额外的用来传输数据的端口是随机选择的,是小于1024的端口;既然是随机的那么客户端又是如何知道NFS服务器端到底使用的是哪个端口呢?这时就需要通过远程过程调用(Remote Procedure Call,RPC)协议来实现了!

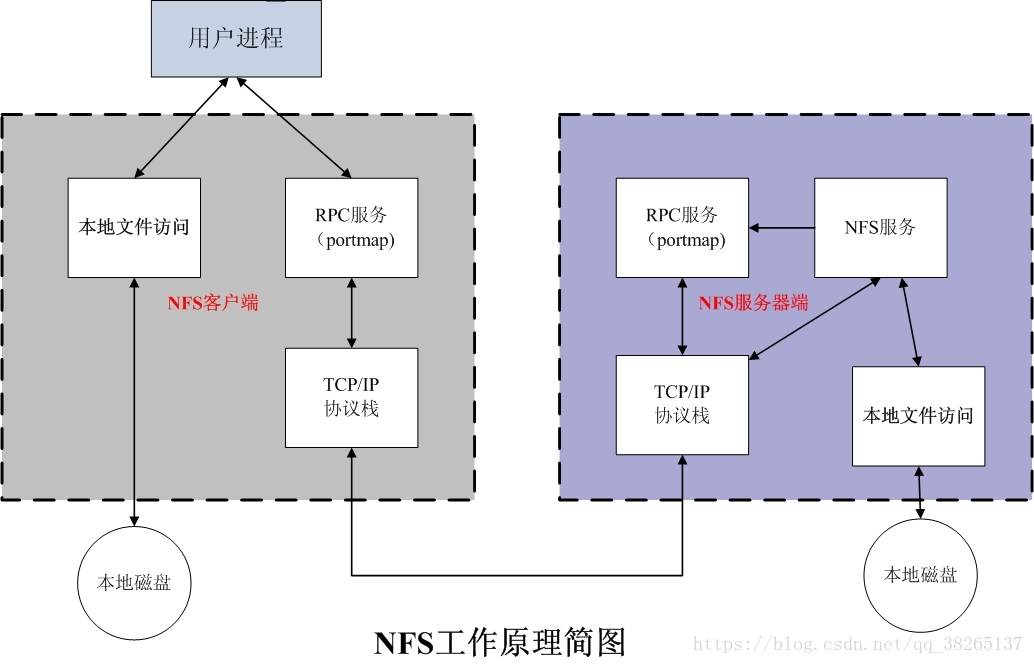

RPC与NFS通讯原理:

因为NFS支持的功能相当多,而不同的功能都会使用不同的程序来启动,每启动一个功能就会启用一些端口来传输数据,因此NFS的功能对应的端口并不固定,客户端要知道NFS服务器端的相关端口才能建立连接进行数据传输,而RPC就是用来统一管理NFS端口的服务,并且统一对外的端口是111,RPC会记录NFS端口的信息,如此我们就能够通过RPC实现服务端和客户端沟通端口信息。PRC最主要的功能就是指定每个NFS功能所对应的port number,并且通知客户端,记客户端可以连接到正常端口上去。

那么RPC又是如何知道每个NFS功能的端口呢?

首先当NFS启动后,就会随机的使用一些端口,然后NFS就会向RPC去注册这些端口,RPC就会记录下这些端口,并且RPC会开启111端口,等待客户端RPC的请求,如果客户端有请求,那么服务器端的RPC就会将之前记录的NFS端口信息告知客户端。如此客户端就会获取NFS服务器端的端口信息,就会以实际端口进行数据的传输了。

注意:在启动NFS SERVER之前,首先要启动RPC服务(即portmap服务,下同)否则NFS SERVER就无法向RPC服务区注册,另外,如果RPC服务重新启动,原来已经注册好的NFS端口数据就会全部丢失。因此此时RPC服务管理的NFS程序也要重新启动以重新向RPC注册。特别注意:一般修改NFS配置文档后,是不需要重启NFS的,直接在命令执行systemctl reload nfs或exportfs –rv即可使修改的/etc/exports生效

NFS客户端和NFS服务器通讯过程:

图:NFS工作原理图

首先服务器端启动RPC服务,并开启111端口

服务器端启动NFS服务,并向RPC注册端口信息

客户端启动RPC(portmap服务),向服务端的RPC(portmap)服务请求服务端的NFS端口

服务端的RPC(portmap)服务反馈NFS端口信息给客户端。

客户端通过获取的NFS端口来建立和服务端的NFS连接并进行数据的传输。

Linux下NFS服务器部署

NFS服务所需软件及主要配置文件:

安装NFS服务,需要安装两个软件,分别是:

RPC主程序:rpcbind

NFS 其实可以被视为一个 RPC 服务,因为启动任何一个 RPC 服务之前,我们都需要做好 port 的对应 (mapping) 的工作才行,这个工作其实就是『 rpcbind 』这个服务所负责的!也就是说, 在启动任何一个 RPC 服务之前,我们都需要启动 rpcbind 才行! (在 CentOS 5.x 以前这个软件称为 portmap,在 CentOS 6.x 之后才称为 rpcbind 的!)。

NFS主程序:nfs-utils

就是提供 rpc.nfsd 及 rpc.mountd 这两个 NFS daemons 与其他相关 documents 与说明文件、执行文件等的软件!这个就是 NFS 服务所需要的主要软件。

NFS的相关文件:

主要配置文件:/etc/exports

这是 NFS 的主要配置文件了。该文件是空白的,有的系统可能不存在这个文件,主要手动建立。NFS的配置一般只在这个文件中配置即可。

NFS 文件系统维护指令:/usr/sbin/exportfs

这个是维护 NFS 分享资源的指令,可以利用这个指令重新分享 /etc/exports 变更的目录资源、将 NFS Server 分享的目录卸除或重新分享。

分享资源的登录档:/var/lib/nfs/*tab

在 NFS 服务器的登录文件都放置到 /var/lib/nfs/ 目录里面,在该目录下有两个比较重要的登录档, 一个是 etab ,主要记录了 NFS 所分享出来的目录的完整权限设定值;另一个 xtab 则记录曾经链接到此 NFS 服务器的相关客户端数据。

客户端查询服务器分享资源的指令:/usr/sbin/showmount

这是另一个重要的 NFS 指令。exportfs 是用在 NFS Server 端,而 showmount 则主要用在 Client 端。showmount 可以用来察看 NFS 分享出来的目录资源。

服务端安装NFS服务步骤:

第一步:安装NFS和rpc。

[root@localhost ~]# yum install -y nfs-utils

#安装nfs服务

[root@localhost ~]# yum install -y rpcbind

#安装rpc服务

第二步:启动服务和设置开启启动:

注意:先启动rpc服务,再启动nfs服务。

[root@localhost ~]# systemctl start rpcbind #先启动rpc服务

[root@localhost ~]# systemctl enable rpcbind #设置开机启动

[root@localhost ~]# systemctl start nfs-server nfs-secure-server

#启动nfs服务和nfs安全传输服务

[root@localhost ~]# systemctl enable nfs-server nfs-secure-server

[root@localhost /]# firewall-cmd --permanent --add-service=nfs

success #配置防火墙放行nfs服务

[root@localhost /]# firewall-cmd --reload

success

第三步:配置共享文件目录,编辑配置文件:

首先创建共享目录,然后在/etc/exports配置文件中编辑配置即可。

[root@localhost /]# mkdir /public

#创建public共享目录

[root@localhost /]# vi /etc/exports

/public 192.168.245.0/24(ro)

/protected 192.168.245.0/24(rw)

[root@localhost /]# systemctl reload nfs

#重新加载NFS服务,使配置文件生效

配置文件说明:

格式: 共享目录的路径 允许访问的NFS客户端(共享权限参数)

如上,共享目录为/public , 允许访问的客户端为192.168.245.0/24网络用户,权限为只读。

请注意,NFS客户端地址与权限之间没有空格。

NFS输出保护需要用到kerberos加密(none,sys,krb5,krb5i,krb5p),格式sec=XXX

none:以匿名身份访问,如果要允许写操作,要映射到nfsnobody用户,同时布尔值开关要打开,setsebool nfsd_anon_write 1

sys:文件的访问是基于标准的文件访问,如果没有指定,默认就是sys, 信任任何发送过来用户名

krb5:客户端必须提供标识,客户端的表示也必须是krb5,基于域环境的认证

krb5i:在krb5的基础上做了加密的操作,对用户的密码做了加密,但是传输的数据没有加密

krb5p:所有的数据都加密

用于配置NFS服务程序配置文件的参数:

参数 作用

ro 只读

rw 读写

root_squash 当NFS客户端以root管理员访问时,映射为NFS服务器的匿名用户

no_root_squash 当NFS客户端以root管理员访问时,映射为NFS服务器的root管理员

all_squash 无论NFS客户端使用什么账户访问,均映射为NFS服务器的匿名用户

sync 同时将数据写入到内存与硬盘中,保证不丢失数据

async 优先将数据保存到内存,然后再写入硬盘;这样效率更高,但可能会丢失数据

NFS客户端挂载配置:

**第一步:**使用showmount命令查看nfs服务器共享信息。输出格式为“共享的目录名称 允许使用客户端地址”。

[root@localhost ~]# showmount -e 192.168.245.128

Export list for 192.168.245.128:

/protected 192.168.245.0/24

/public 192.168.245.0/24

showmount命令的用法;

参数 作用

-e 显示NFS服务器的共享列表

-a 显示本机挂载的文件资源的情况NFS资源的情况

-v 显示版本号

**第二步,**在客户端创建目录,并挂载共享目录。

[root@localhost ~]# mkdir /mnt/public

[root@localhost ~]# mkdir /mnt/data

[root@localhost ~]# vim /etc/fstab

#在该文件中挂载,使系统每次启动时都能自动挂载

192.168.245.128:/public /mnt/public nfs defaults 0 0

192.168.245.128:/protected /mnt/data nfs defaults 0 1

[root@localhost ~]# mount -a #是文件/etc/fstab生效

第三步:检查:

[root@mail ~]# df -Th

Filesystem Type Size Used Avail Use% Mounted on

/dev/mapper/rhel-root xfs 17G 3.1G 14G 18% /

devtmpfs devtmpfs 1.4G 0 1.4G 0% /dev

tmpfs tmpfs 1.4G 140K 1.4G 1% /dev/shm

tmpfs tmpfs 1.4G 9.1M 1.4G 1% /run

tmpfs tmpfs 1.4G 0 1.4G 0% /sys/fs/cgroup

/dev/sda1 xfs 1014M 173M 842M 18% /boot

tmpfs tmpfs 280M 32K 280M 1% /run/user/0

/dev/sr0 iso9660 3.6G 3.6G 0 100% /mnt/cdrom

192.168.245.128:/public nfs4 17G 3.7G 14G 22% /mnt/public

192.168.245.128:/protected nfs4 17G 3.7G 14G 22% /mnt/data

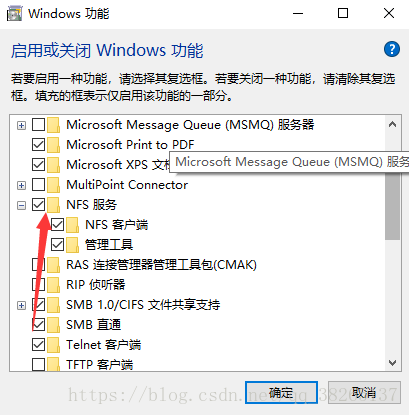

在Window上挂载NFS

第一步:在控制面板–>添加程序和功能–>添加NFS组件。

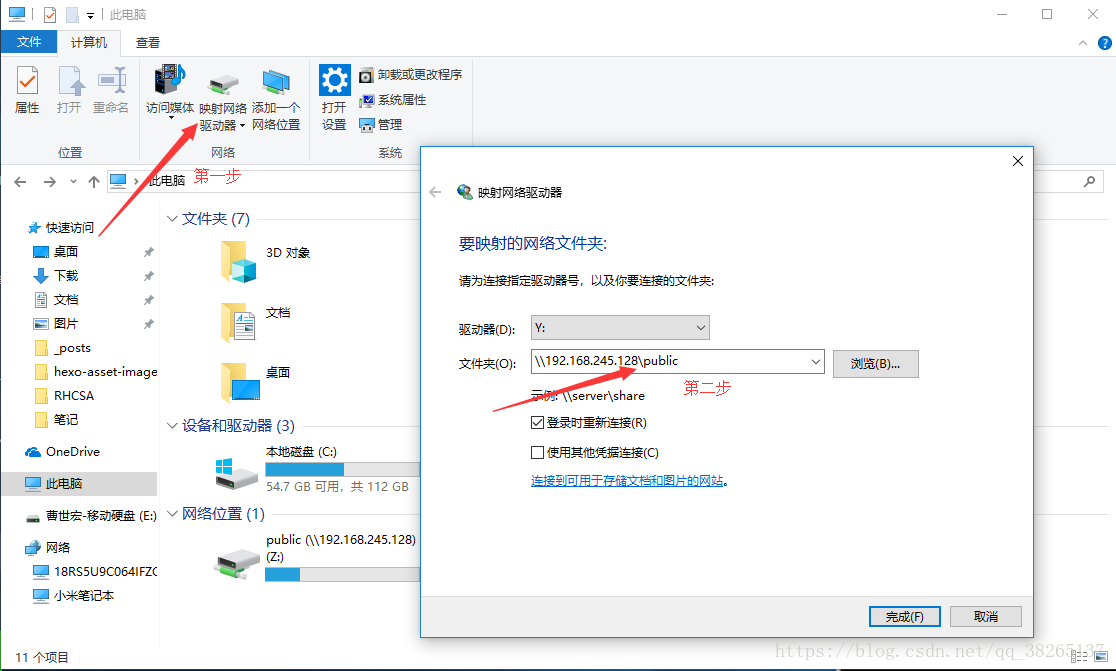

第二步:在此电脑,映射驱动器中添加nfs地址,和要共享的文件夹。

第三步:如果权限有问题,打开注册表:regedit, 在HKEY_LOCAL_MACHINESOFTWAREMicrosoftClientForNFSCurrentVersionDefault 下新建两个OWORD(64)位值,添加值AnonymousGid,值默认为0,AnonymousUid,值默认为0。

————————————————

版权声明:本文为CSDN博主「曹世宏的博客」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/qq_38265137/article/details/83146421