一、jieba 库简介

(1) jieba 库的分词原理是利用一个中文词库,将待分词的内容与分词词库进行比对,通过图结构和动态规划方法找到最大概率的词组;除此之外,jieba 库还提供了增加自定义中文单词的功能。

(2) jieba 库支持3种分词模式:

精确模式:将句子最精确地切开,适合文本分析。

全模式:将句子中所以可以成词的词语都扫描出来,速度非常快,但是不能消除歧义。

搜索引擎模式:在精确模式的基础上,对长分词再次切分,提高召回率,适合搜索引擎分词。

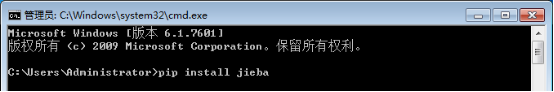

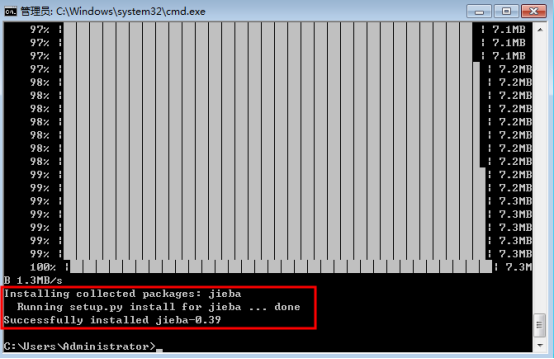

二、安装库函数

(1) 在命令行下输入指令:

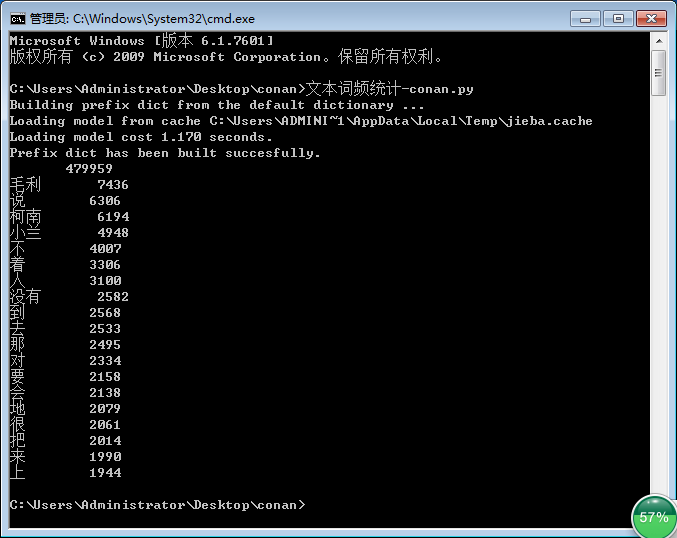

现在我们来用jieba库统计一篇文章的词频,课本是统计三国演义,我们来统计一下名侦探柯南里面的主要人物

废话不多说,直接上代码

# -*- coding:utf-8 -*- from jieba import * def Replace(text,old,new): #替换列表的字符串 for char in old: text = text.replace(char,new) return text def getText(filename): #读取文件内容(utf-8 编码格式) #特殊符号和部分无意义的词 sign = '''!~·@¥……*“”‘’ (){}【】;:"'「,」。-、?''' txt = open('{}.txt'.format(filename),encoding='utf-8').read() return Replace(txt,sign," ") def word_count(passage,N): #计算passage文件中的词频数,并将前N个输出 words = lcut(passage) #精确模式分词形式 counts = {} #创建计数器 --- 字典类型 for word in words: #消除同意义的词和遍历计数 if word == '小五' or word == '小五郎' or word == '五郎': rword = '毛利' elif word == '柯' or word == '南': rword = '柯南' elif word == '小' or word == '兰': rword = '小兰' elif word == '目' or word == '暮' or word == '警官': rword = '暮目' else: rword = word counts[rword] = counts.get(rword,0) + 1 excludes = lcut_for_search("你我事他和她在这也有什么的是就吧啊吗哦呢都了一个") for word in excludes: #除去意义不大的词语 del(counts[word]) items = list(counts.items()) #转换成列表形式 items.sort(key = lambda x : x[1], reverse = True ) #按次数排序 for i in range(N): #依次输出 word,count = items[i] print("{:<7}{:>6}".format(word,count)) if __name__ == '__main__': passage = getText('Detective_Novel') #输入文件名称读入文件内容 word_count(passage,20) #调用函数得到词频数

注:代码使用的文档 >>> Detective_Novel(utf-8).zip [点击下载],也可自行找 utf-8 编码格式的txt文件。

结果如下:

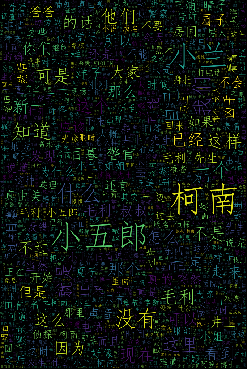

高逼格一点的云图,我们用jieba和wordcloud 库一起,代码如下:

# -*- coding:utf-8 -*- from wordcloud import WordCloud import matplotlib.pyplot as plt import numpy as np from PIL import Image from jieba import * def Replace(text,old,new): #替换列表的字符串 for char in old: text = text.replace(char,new) return text def getText(filename): #读取文件内容(utf-8 编码格式) #特殊符号和部分无意义的词 sign = '''!~·@¥……*“”‘’ (){}【】;:"'「,」。-、?''' txt = open('{}.txt'.format(filename),encoding='utf-8').read() return Replace(txt,sign," ") def creat_word_cloud(filename): #将filename 文件的词语按出现次数输出为词云图 text = getText(filename) #读取文件 wordlist = lcut(text) #jieba库精确模式分词 wl = ' '.join(wordlist) #生成新的字符串 #设置词云图 font = r'C:WindowsFontssimfang.ttf' #设置字体路径 wc = WordCloud( background_color = 'black', #背景颜色 max_words = 2000, #设置最大显示的词云数 font_path = font, #设置字体形式(在本机系统中) height = 1200, #图片高度 width = 1600, #图片宽度 max_font_size = 100, #字体最大值 random_state = 100, #配色方案的种类 ) myword = wc.generate(wl) #生成词云 #展示词云图 plt.imshow(myword) plt.axis('off') plt.show() #以原本的filename命名保存词云图 wc.to_file('{}.png'.format(filename)) if __name__ == '__main__': creat_word_cloud('Detective_Novel') #输入文件名生成词云图

结果如下:

这样就搞定了~~~~