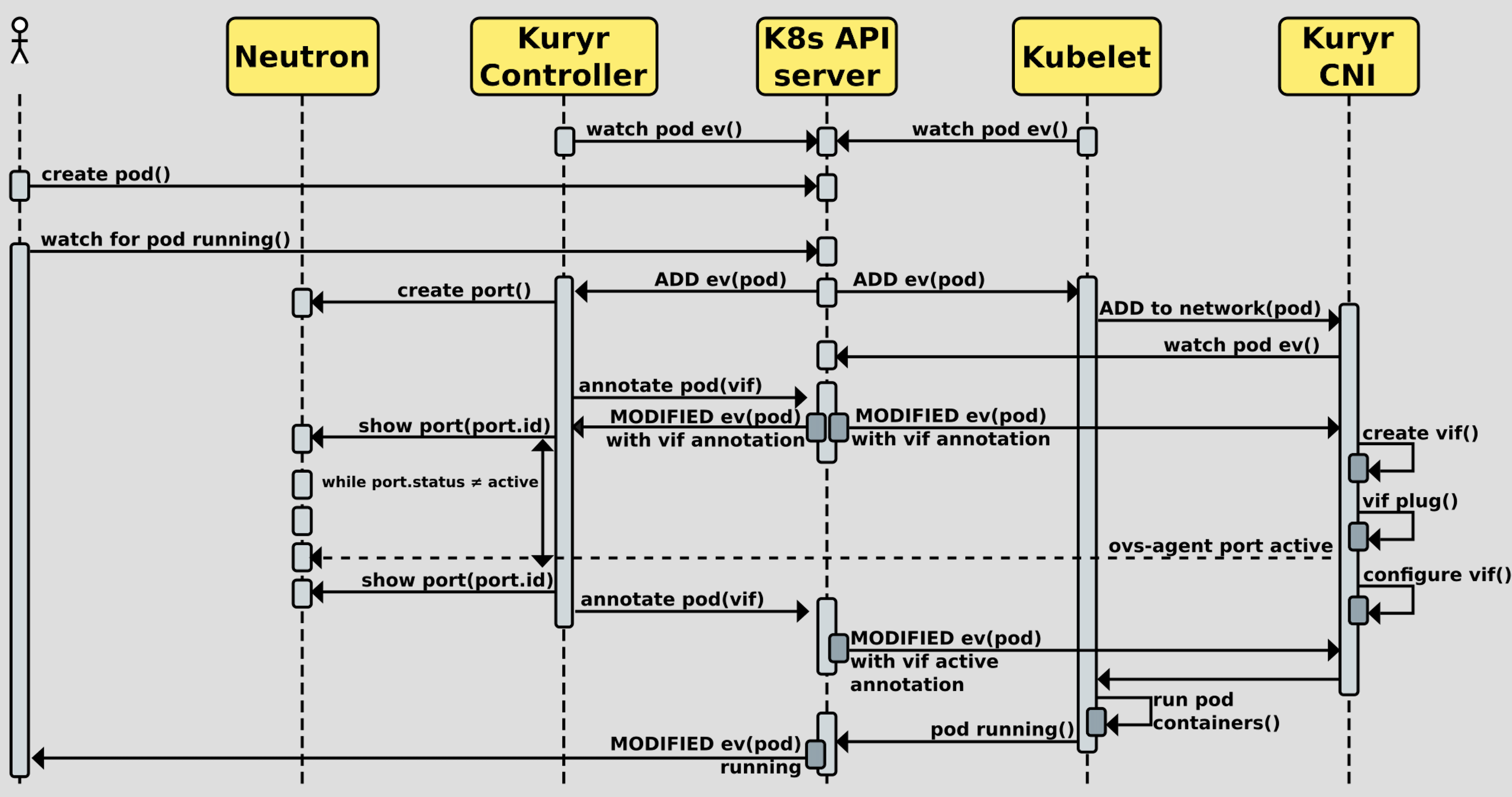

官方项目目路径下提供的创建pod时序图:

简要描述下:

Kuryr-controller作为独立的进程使用,作为中k8s控制neutron的“信使”,需要和k8s以及neutron都存在交互。创建pod时,请求从用户到达k8s后,kuryr-controller通过list & watch (pod, service, endpoint)资源来获取到创始的pod的信息,在neutron侧创建完port后,将port信息annotate到pod上,

由于neutron-openvswitch-agent实现了租户的其他访问资源的创建(包括租户隔离、同节点、跨节点通信l),所以这里只要完成虚拟机实现的网络功能即可,即创建虚拟设备,配置三层信息(ip、路由、网关)

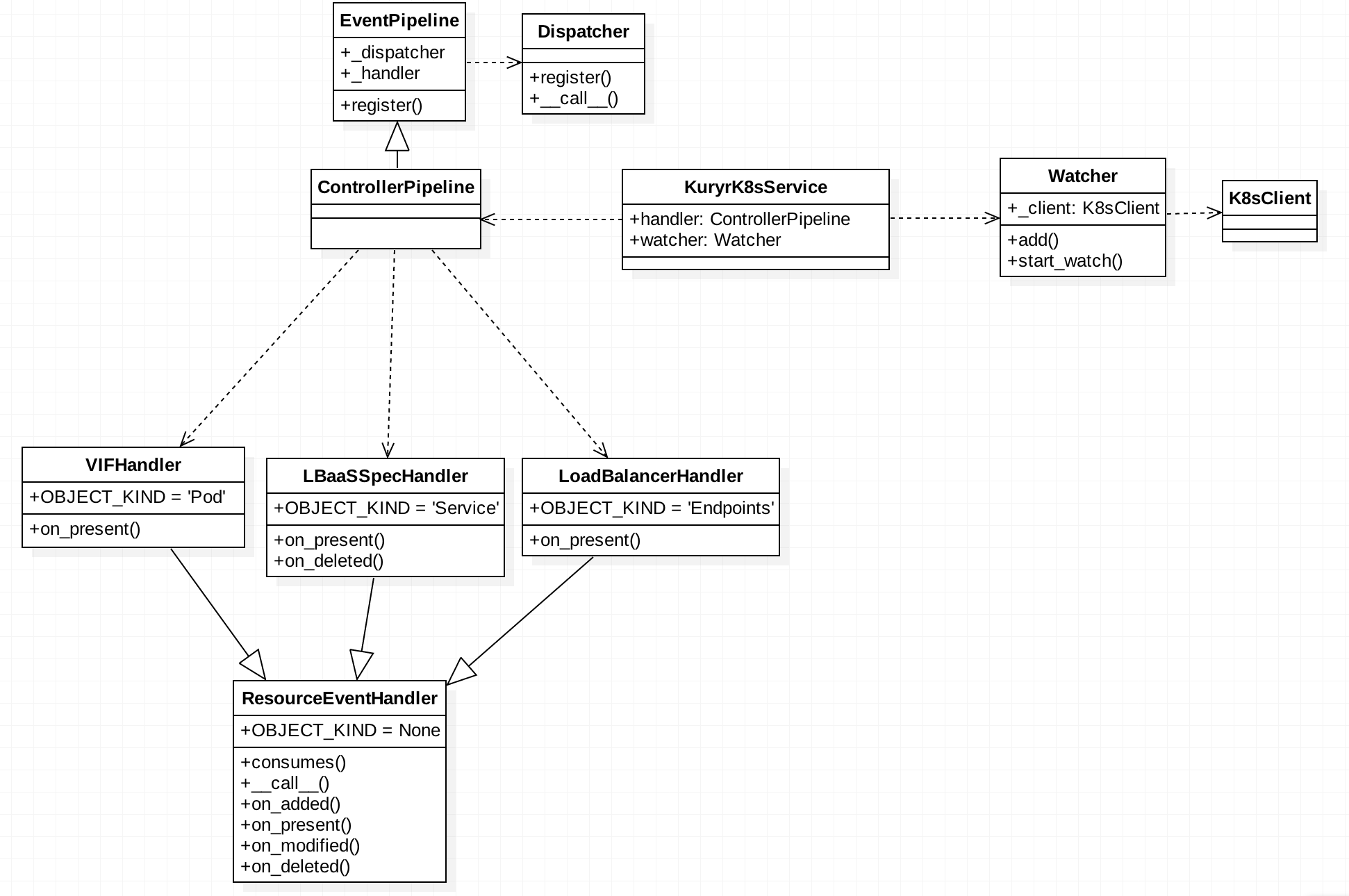

注:由于k8s未使用租户信息,所以从k8s资源到neutron资源的映射实现时,暂时仅实现了默认租户,也就是仅对某一个租户实现了资源的转换。

kuryr-contronller中配置了可以管理员的权限的租户信息,用于申请token。对于所有的租户操作都会使用此token,并指定该租户id操作port、lb资源。由于openstack neutron在框架中属于南向资源,被动接收kuryr-controller的资源,所以如果要完成openstack租户和k8s租户的对应,还需要kuryr-controller 从k8s watch到的资源中携带租户信息。

kuryr-controller结构图

Kuryr-cni 结构图

对于kuryr(ˈkʊrɪə)-cni,只完成了网口的添加和删除,及三层交换所需信息

def connect(vif, instance_info, ifname, netns=None):

driver = _get_binding_driver(vif)

os_vif.plug(vif, instance_info)

driver.connect(vif, ifname, netns) # 添加虚拟设备,并加入命名空间,具体设备实现根据所用driver,如openvswitch

_configure_l3(vif, ifname, netns) # 配置学ip、Mac、路由和网关(openstack管理的vm起动时也会使用dhcp request来获取对应信息)