前言

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理。

Python爬虫、数据分析、网站开发等案例教程视频免费在线观看

基本开发环境

- Python 3.6

- Pycharm

相关模块的使用

import requests import re

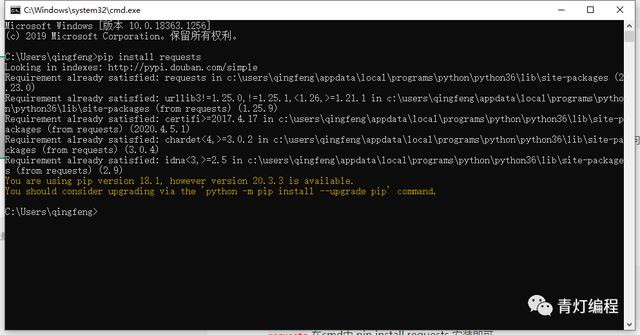

requests 在cmd中 pip install requests 安装即可

我这是显示已经安装过了的,如果你没有安装的话,是会有安装进度条的。

目标网页分析

就选择B站排行榜第一的视频。

如何找到弹幕数据?

如上图所示:

1、点击进入网页之后,F12打开开发者工具,选择Ntework

2、点击查看历史弹幕,选择日期就有相对应的数据加载出来

3、点击选择有日期的url地址,弹幕的数据都包含在内了(如下图所示)

弹幕数据的url地址既然都知道了,那么就可以直接爬取下来了。

代码实现部分

1、请求网页获取源代码数据

import requests url = 'https://api.bilibili.com/x/v2/dm/history?type=1&oid=279984604&date=2021-01-10' headers = { 'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36' } response = requests.get(url=url, headers=headers) print(response.text)

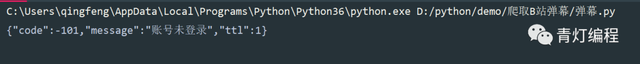

爬取这些数据是需要加上cookie的,如果没有加cookie的话会显示你未登录账号

所以需要在headers里面添加cookie

cookie怎么添加呢?

在开发者工具当中,选择你所需要爬取的url地址,查看headers其中的requests headers 中的cookie就是了。

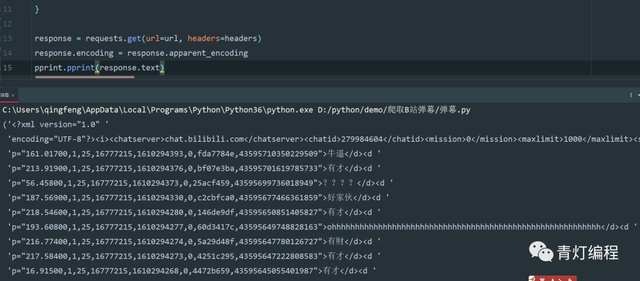

当给了cookie之后又出现问题了

虽然数据是有了,但是出现乱。其实只需要加一行代码就可以解决,还是比较万能的转码方式。

response.encoding = response.apparent_encoding

遇到乱码问题都可以这样使用,如果使用之后还是出现乱码问题,就要根据网页的编码进行转码了。

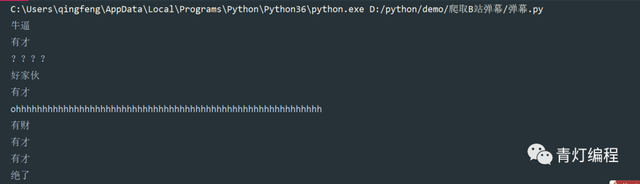

2、使用正则表达式提取弹幕数据

result = re.findall('p=".*?">(.*?)</d><d ', response.text) for i in result: print(i)

正则表达式提取出来的数据,是列表格式,所以需要遍历提取出每一条弹幕数据。

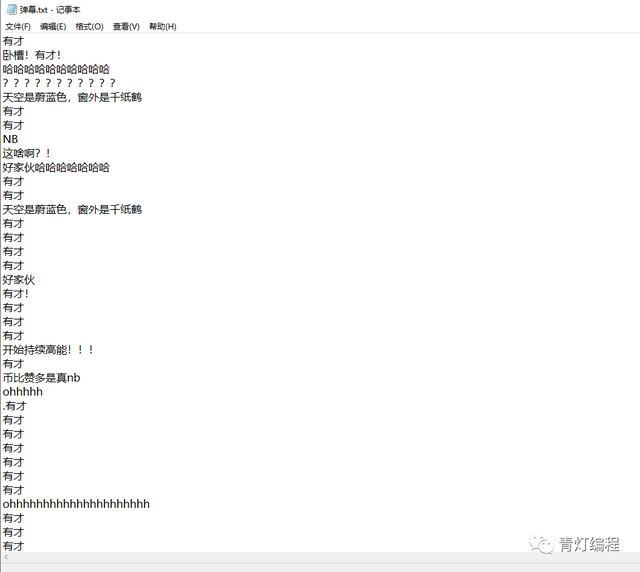

3、保存数据至本地

with open('弹幕.txt', mode='a', encoding='utf-8') as f: f.write(i) f.write(' ')

mode='a':写入模式为a,追加写入

encoding='utf-8':指定写入编码,文字内容均为 'utf-8'

写入一个换行符,每写入一条数据,就重新换一个行写入

4、批量爬取弹幕数据

之前只是爬取一天的弹幕数据,如果想要爬取一段时间内容的弹幕数据的话,只需要改变url地址中的日期就可以了

for date in range(9, 12): url = f'https://api.bilibili.com/x/v2/dm/history?type=1&oid=279984604&date=2021-01-{date}'

就是从9号爬取到11号的数据,这个视频也刚出来三天。

爬虫完整代码

import requests import re for date in range(9, 12): url = f'https://api.bilibili.com/x/v2/dm/history?type=1&oid=279984604&date=2021-01-{date}' headers = { "cookie": "输入你自己的cookie", 'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36' } response = requests.get(url=url, headers=headers) response.encoding = response.apparent_encoding result = re.findall('p=".*?">(.*?)</d><d ', response.text) for i in result: with open('弹幕.txt', mode='a', encoding='utf-8') as f: f.write(i) f.write(' ') print(i)

通过代码量可以看得出来,B站弹幕的爬取还是比较简单的,16行就能搞定,说到底还是python代码简洁优雅。

弹幕词云代码

import jieba import wordcloud import imageio # 导入imageio库中的imread函数,并用这个函数读取本地图片,作为词云形状图片 # py = imageio.imread('图片路径') 如何你想要改变词云图的形状,可以添加 # 读取文件内容 f = open('弹幕.txt', encoding='utf-8') txt = f.read() # jiabe 分词 分割词汇 txt_list = jieba.lcut(txt) string = ' '.join(txt_list) # 词云图设置 wc = wordcloud.WordCloud( width=1000, # 图片的宽 height=700, # 图片的高 background_color='white', # 图片背景颜色 font_path='msyh.ttc', # 词云字体 # mask=py, # 所使用的词云图片 scale=15, # stopwords={''}, # 停用词 # contour_width=5, # contour_color='red' # 轮廓颜色 ) # 给词云输入文字 wc.generate(string) # 词云图保存图片地址 wc.to_file('out.png')

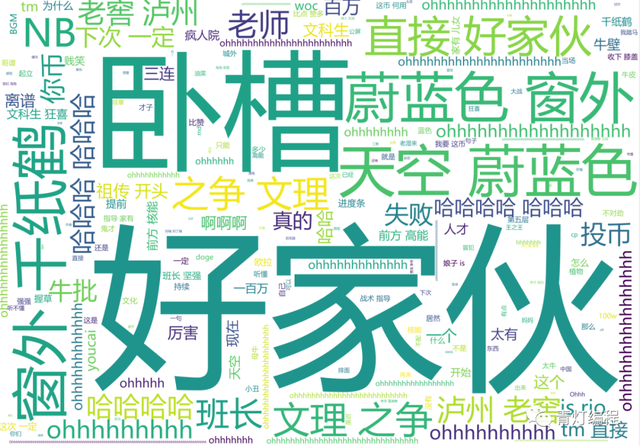

实现效果