从计算的角度来讲,数据处理过程中需要计算资源(内存 & CPU)和计算模型(逻辑)。

执行时,需要将计算资源和计算模型进行协调和整合。

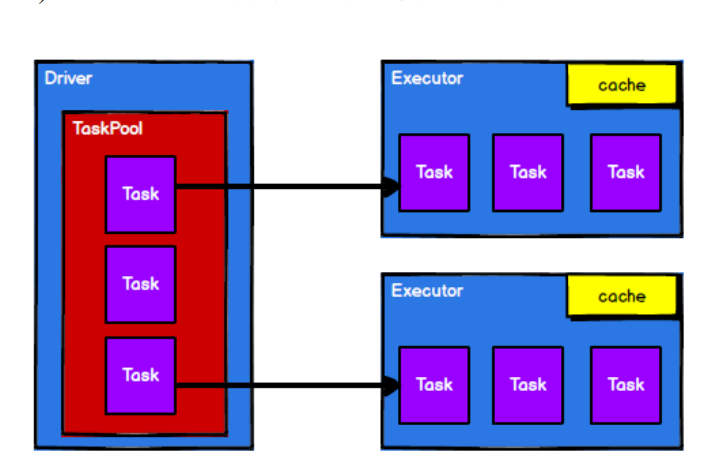

Spark 框架在执行时,先申请资源,然后将应用程序的数据处理逻辑分解成一个一个的

计算任务。然后将任务发到已经分配资源的计算节点上, 按照指定的计算模型进行数据计

算。最后得到计算结果。

RDD 是 Spark 框架中用于数据处理的核心模型,接下来我们看看,在 Yarn 环境中,RDD

的工作原理:

1) 启动 Yarn 集群环境

从以上流程可以看出 RDD 在整个流程中主要用于将逻辑进行封装,并生成 Task 发送给

Executor 节点执行计算,接下来我们就一起看看 Spark 框架中 RDD 是具体是如何进行数据

处理的