摘要: 4月25日,华为云发布盘古系列超大规模预训练模型,包括30亿参数的全球最大视觉(CV)预训练模型,以及与循环智能、鹏城实验室联合开发的千亿参数、40TB训练数据的全球最大中文语言(NLP)预训练模型。后续,华为云还将陆续发布多模态、科学计算等超大预训练模型。

4月25日,华为云发布盘古系列超大规模预训练模型,包括30亿参数的全球最大视觉(CV)预训练模型,以及与循环智能、鹏城实验室联合开发的千亿参数、40TB训练数据的全球最大中文语言(NLP)预训练模型。后续,华为云还将陆续发布多模态、科学计算等超大预训练模型。

华为云人工智能领域首席科学家、IEEE Fellow田奇表示:“预训练大模型是解决AI应用开发定制化和碎片化的重要方法。华为云盘古大模型可以实现一个AI大模型在众多场景通用、泛化和规模化复制,减少对数据标注的依赖,并使用ModelArts平台,让AI开发由作坊式转变为工业化开发的新模式。”

▲华为云人工智能领域首席科学家、IEEE Fellow田奇

全球最大中文语言预训练模型,刷新CLUE三项榜单世界纪录

盘古NLP大模型是全球最大的千亿参数中文语言预训练模型,由华为云、循环智能和鹏城实验室联合开发,预训练阶段学习了40TB中文文本数据,并通过行业数据的样本调优提升模型在场景中的应用性能。

盘古NLP大模型在三个方面实现了突破性进展:

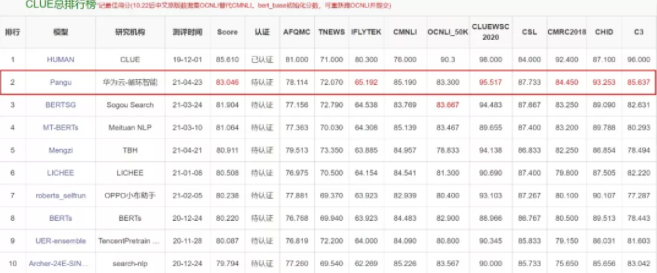

第一,具备领先的语言理解和模型生成能力:在权威的中文语言理解评测基准CLUE榜单中,盘古NLP大模型在总排行榜及分类、阅读理解单项均排名第一,刷新三项榜单世界历史纪录;总排行榜得分83.046,多项子任务得分业界领先, 向人类水平(85.61)迈进了一大步。

▲盘古NLP大模型位列CLUE榜单总排行榜第一

在NLPCC2018文本摘要任务中,盘古NLP大模型取得了Rouge平均分0.53的业界最佳成绩,超越第二名百分之六十。

第二,盘古NLP大模型在预训练阶段沉淀了大量的通用知识,既能做理解又能做生成。除了能像GPT-3等仅基于端到端生成的方式以外,大模型还可以通过少样本学习对意图进行识别,转化为知识库和数据库查询。通过功能的模块化组合支持行业知识库和数据库的嵌入,进而对接行业经验,使能全场景的快速适配与扩展。比如在华为云和循环智能合作构建的金融客服场景中,盘古NLP大模型能更好地赋能销售环节,帮助服务人员快速提升业务水平,重塑消费者体验。

第三,盘古NLP大模型采用大模型小样本调优的路线,实现了小样本学习任务上超越GPT系列。比如在客户需求分析场景中,使用盘古NLP大模型生产语义标签时,得到目标结果所需的样本量仅为GPT系列模型的十分之一,即AI生产效率可提升十倍。

30亿参数,全球最大视觉预训练模型

盘古CV大模型是目前业界最大的视觉预训练模型,包含超过30亿参数。盘古CV大模型首次兼顾了图像判别与生成能力,从而能够同时满足底层图像处理与高层语义理解需求,同时能够方便融合行业知识微调,快速适配各种下游任务。盘古CV大模型性能表现优异,在ImageNet 1%、10%数据集上的小样本分类精度上均达到目前业界最高水平(SOTA)。

盘古CV大模型致力于解决AI工程难以泛化和复制的问题,开创AI开发工业化新模式,大大节约研发成本。此外,盘古CV大模型提供模型预训练、微调、部署和迭代的功能,形成了AI开发完整闭环,极大提升AI开发效率。目前,盘古CV大模型已经在医学影像、金融、工业质检等100余项实际任务中得到了验证,不仅大幅提升了业务测试精度,还能平均节约90%以上的研发成本。

盘古CV大模型助力无人机电力智能巡检

国网重庆永川供电公司是国内早期应用无人机电力智能巡检技术的电网企业。传统的无人机智能巡检AI模型开发主要面临两大挑战:一是如何对海量数据进行高效标注;二是缺陷种类多达上百种,需要数十个AI识别模型,开发成本高。

华为云与国网重庆永川供电公司合作,在无人机智能巡检AI模型开发上,华为云盘古CV大模型相对于传统开发模式,展现了其强大的优势。

在数据标注方面,盘古CV大模型利用海量无标注电力数据进行预训练,并结合少量标注样本微调的高效开发模式,独创性地提出了针对电力行业的预训练模型,使得样本筛选效率提升约30倍,筛选质量提升约5倍,以永川每天采集5万张高清图片为例,可节省人工标注时间170人天。

在模型通用性方面,结合盘古搭载的自动数据增广以及类别自适应损失函数优化策略,可以做到一个模型适配上百种缺陷,替代原有20多个小模型,极大地减少了模型维护成本,平均精度提升18.4%,模型开发成本降低90%。

盘古大模型背后的支撑

盘古NLP大模型涉及千亿参数、40TB训练数据,对算法、算力、海量数据处理、并行优化都提出了很大挑战。

在算法方面,华为云的算法团队和循环智能(Recurrent AI)的NLP团队联合攻关,突破了大模型微调的难题。

鹏城实验室的国内最大规模AI训练集群鹏城云脑II,在盘古NLP大模型训练中展示出强大的AI算力和数据吞吐能力,为盘古大模型训练打下坚实的基础。

另一方面,华为底层软件、训练框架、ModelArts平台协同优化,充分释放算力,达成全栈性能最优。首先,针对底层算子性能,基于华为CANN采用了算子量化、算子融合优化等技术,将单算子性能提升30%以上。其次,华为MindSpore创新性地采用了“流水线并行、模型并行和数据并行”的多维自动混合并行技术,大幅降低了手动编码的工作量,并提升集群线性度20%。华为云ModelArts平台提供E级算力调度,同时结合物理网络拓扑,提供动态路由规划能力,为大模型训练提供了最优的网络通信能力。此外,借助ModelArts平台的高效处理海量数据能力,仅用7天就完成了40TB文本数据处理。

截至目前,华为云已经在全国10多个行业超过600个项目进行了人工智能落地和实践,帮助城市、交通、医疗、钢铁、纺织、能源、金融等行业智能升级。未来,华为云将持续通过技术创新,驱动产业智能升级。