1.中软国际华南区技术总监曾老师还会来上两次课,同学们希望曾老师讲些什么内容?(认真想一想回答)

a讲一下python的实际应用

b直接教我们使用python做更厉害的大程序

c讲一下Python开发工程师要具备什么资质

d大数据除了Python还有什么比较热门

2.中文分词

- )下载一中文长篇小说,并转换成UTF-8编码。

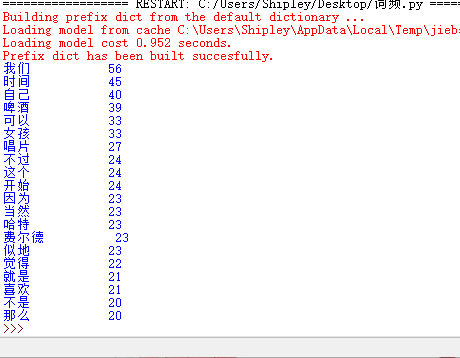

- )使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

- )**排除一些无意义词、合并同一词。

- )**使用wordcloud库绘制一个词云。

import jieba txt = open('且听风吟.txt',"r",encoding='utf-8').read() ex = {'一边','什么','一个','为什么','一种','怎么','没有','这样'} ls = [] words = jieba.lcut(txt) counts = {} for word in words: ls.append(word) if len(word) == 1: continue else: counts[word] = counts.get(word,0)+1 for word in ex: del(counts[word]) items = list(counts.items()) items.sort(key = lambda x:x[1], reverse = True) for i in range(20): word , count = items[i] print ("{:<10}{:>5}".format(word,count))

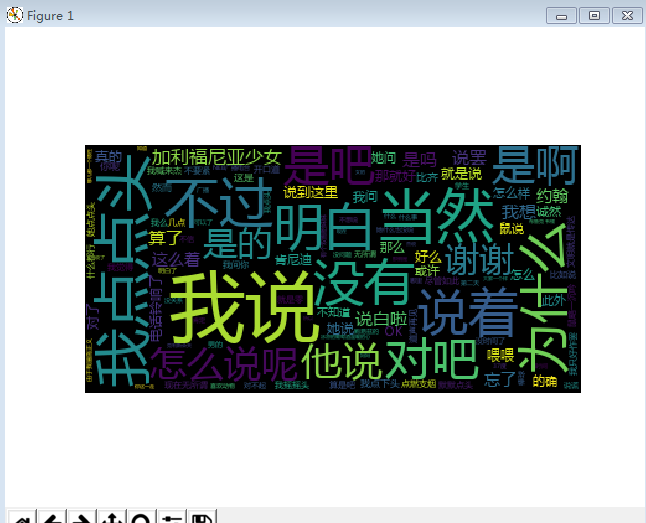

结果:

使用wordcloud库绘制一个词云

#coding:utf-8 import jieba from wordcloud import WordCloud import matplotlib.pyplot as plt text =open("且听风吟.txt",'r').read() wordlist = jieba.cut(text,cut_all=True) wl_split = "/".join(wordlist) mywc = WordCloud().generate(text) plt.imshow(mywc) plt.axis("off") plt.show()

结果: