参考:1. pytorch学习笔记(九):PyTorch结构介绍

2.pytorch学习笔记(七):pytorch hook 和 关于pytorch backward过程的理解

3.Pytorch入门学习(三):Neural Networks

4.forward

神经网络的典型处理如下所示:

1. 定义可学习参数的网络结构(堆叠各层和层的设计);

2. 数据集输入;

3. 对输入进行处理(由定义的网络层进行处理),主要体现在网络的前向传播;

4. 计算loss ,由Loss层计算;

5. 反向传播求梯度;

6. 根据梯度改变参数值,最简单的实现方式(SGD)为:

weight = weight - learning_rate * gradient

下面是利用PyTorch定义深度网络层(Op)示例:

-

class FeatureL2Norm(torch.nn.Module):

-

def __init__(self):

-

super(FeatureL2Norm, self).__init__()

-

-

def forward(self, feature):

-

epsilon = 1e-6

-

# print(feature.size())

-

# print(torch.pow(torch.sum(torch.pow(feature,2),1)+epsilon,0.5).size())

-

norm = torch.pow(torch.sum(torch.pow(feature,2),1)+epsilon,0.5).unsqueeze(1).expand_as(feature)

-

return torch.div(feature,norm)

-

class FeatureRegression(nn.Module):

-

def __init__(self, output_dim=6, use_cuda=True):

-

super(FeatureRegression, self).__init__()

-

self.conv = nn.Sequential(

-

nn.Conv2d(225, 128, kernel_size=7, padding=0),

-

nn.BatchNorm2d(128),

-

nn.ReLU(inplace=True),

-

nn.Conv2d(128, 64, kernel_size=5, padding=0),

-

nn.BatchNorm2d(64),

-

nn.ReLU(inplace=True),

-

)

-

self.linear = nn.Linear(64 * 5 * 5, output_dim)

-

if use_cuda:

-

self.conv.cuda()

-

self.linear.cuda()

-

-

def forward(self, x):

-

x = self.conv(x)

-

x = x.view(x.size(0), -1)

-

x = self.linear(x)

-

return x

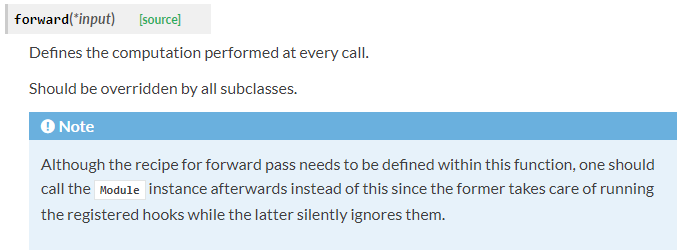

由上例代码可以看到,不论是在定义网络结构还是定义网络层的操作(Op),均需要定义forward函数,下面看一下PyTorch官网对PyTorch的forward方法的描述:

那么调用forward方法的具体流程是什么样的呢?具体流程是这样的:

以一个Module为例:

1. 调用module的call方法

2. module的call里面调用module的forward方法

3. forward里面如果碰到Module的子类,回到第1步,如果碰到的是Function的子类,继续往下

4. 调用Function的call方法

5. Function的call方法调用了Function的forward方法。

6. Function的forward返回值

7. module的forward返回值

8. 在module的call进行forward_hook操作,然后返回值

上述中“调用module的call方法”是指nn.Module 的__call__方法。定义__call__方法的类可以当作函数调用,具体参考Python的面向对象编程。也就是说,当把定义的网络模型model当作函数调用的时候就自动调用定义的网络模型的forward方法。nn.Module 的__call__方法部分源码如下所示:

-

def __call__(self, *input, **kwargs):

-

result = self.forward(*input, **kwargs)

-

for hook in self._forward_hooks.values():

-

#将注册的hook拿出来用

-

hook_result = hook(self, input, result)

-

...

-

return result

可以看到,当执行model(x)的时候,底层自动调用forward方法计算结果。具体示例如下:

-

class Function:

-

def __init__(self):

-

...

-

def forward(self, inputs):

-

...

-

return outputs

-

def backward(self, grad_outs):

-

...

-

return grad_ins

-

def _backward(self, grad_outs):

-

hooked_grad_outs = grad_outs

-

for hook in hook_in_outputs:

-

hooked_grad_outs = hook(hooked_grad_outs)

-

grad_ins = self.backward(hooked_grad_outs)

-

hooked_grad_ins = grad_ins

-

for hook in hooks_in_module:

-

hooked_grad_ins = hook(hooked_grad_ins)

-

return hooked_grad_ins

model = LeNet()

y = model(x)

如上则调用网络模型定义的forward方法。