1:常见函数的梯度

【注】

导数:一维函数的导数(梯度)没有方向是一个标量

梯度:有方向的向量

2:激活函数的梯度

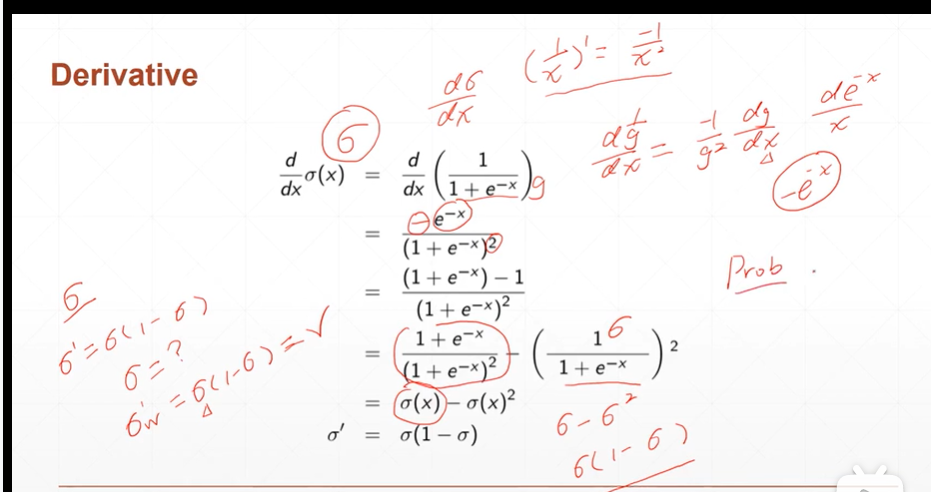

(2.1)激活函数:Sigmoid/Logistic

[注]sigmoid函数输出范围为【0,1】,多用于概率,图像的rgb通道等。

[注]sigmoid函数在torch中的使用有两种方式:

torch.sigmoid()

torch.nn.functional as F F.sigmoid()

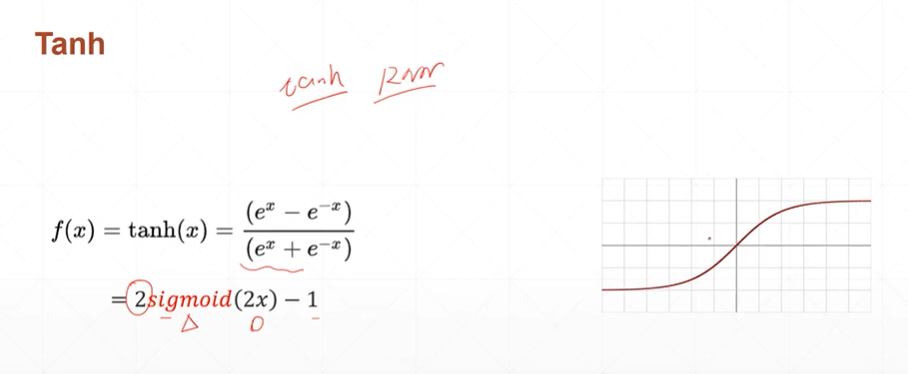

(2.2)激活函数:tanh

[注]:Tanh函数输出范围为【-1,1】多用于RNN循环神经网络。

[注]:Tanh函数在torch中的使用方式:

torch.tanh()

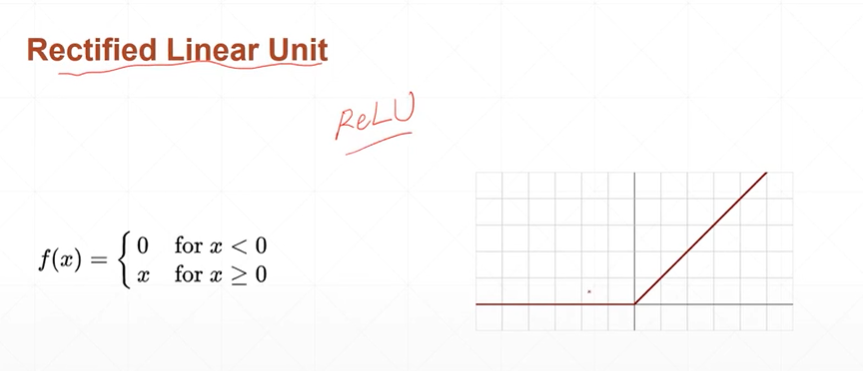

(2.3)激活函数:ReLU(首先推荐使用的激活函数)

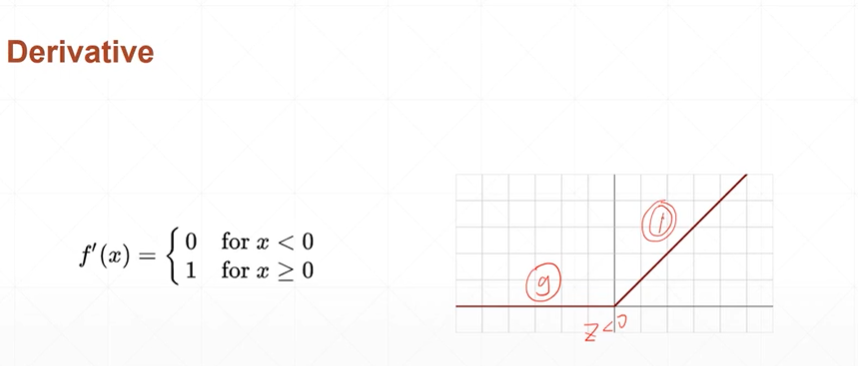

ReLU激活函数的梯度:

【注】ReLU函数有效降低了梯度爆炸和梯度离散的情况。

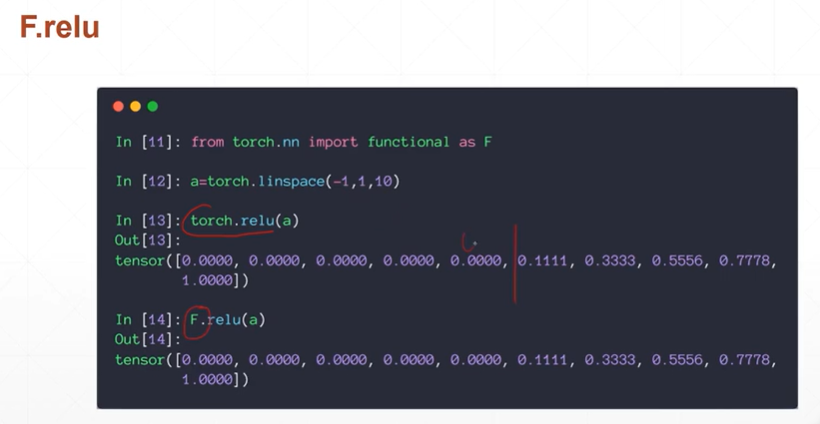

【注】ReLU函数在pytorch中的使用:

torch.relu()

F.relu()

【注】梯度爆炸和梯度离散参考:https://www.cnblogs.com/yangmang/p/7477802.html