1:池化层

(1)Pooling(类似于downsampling)

[注]leNet-5卷积神经网络中的Subsampling是向下采样中的隔行采样。而AlexNet之后的卷积神经网络则开始采用Max pooling或者是Avg sampling采样。

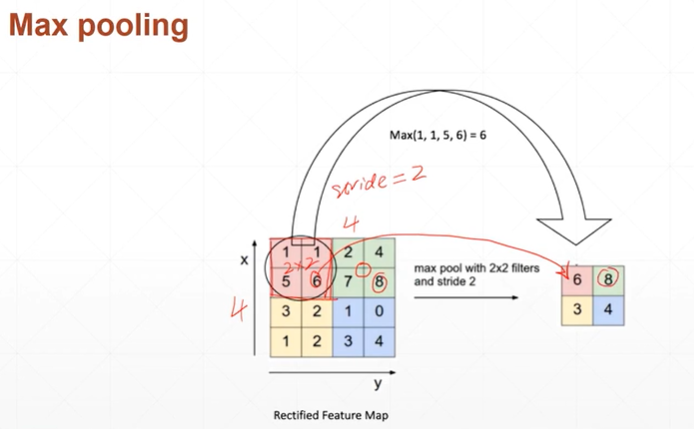

(1.1)Max pooling最大采样

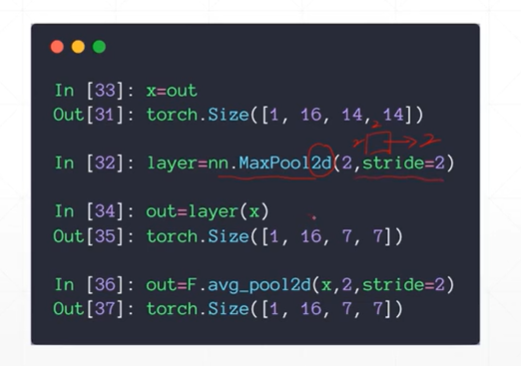

(1.2)Avg pooling平均采样

【注】pytorch中提供了两种采样方式。nn,MaxPool2d(pa1,stride=)参数1表示移动窗口的大小(x*x),stride表示步长。

(2)upsampling向上采样

[注]之所以pytorch提供向上采样的函数,是因为python提供的主要针对numpy,其为了适应自己的tensor类型数据,故提供了向上采样的实现。

【注】1.0版本之前对向上采样的提供使用的是:F.upsamplin()参数和1.0及以上F.interpolate中的参数相同。

【注】F.interpolate(pa1,scale_factor=,mode=)pa1表示为上一层的输出,scale_factor表示扩大的倍数,mode表示扩大所使用的差值(其值可以为:'nearest','bi....','fri....')。

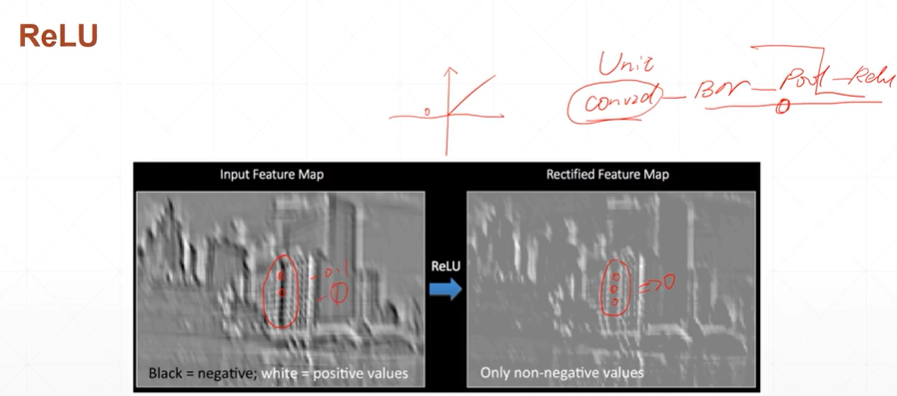

(3)ReLU激活函数:进行矫正

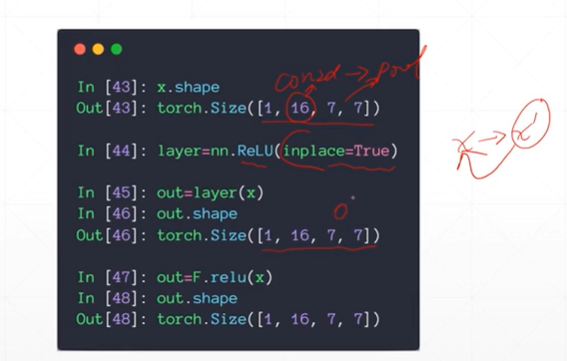

pytorch中两种风格的使用:1:layer=nn.ReLU(inplace=true)然后layer(x)。2:F.relu(x)

[注]ReLu函数可以帮助过滤掉一些负数值,过滤之后的最小值为0.

[注]inplace=true的意思是进行原地操作,可以节省运算内存。

详细解释可以参考:https://www.jianshu.com/p/8385aa74e2de