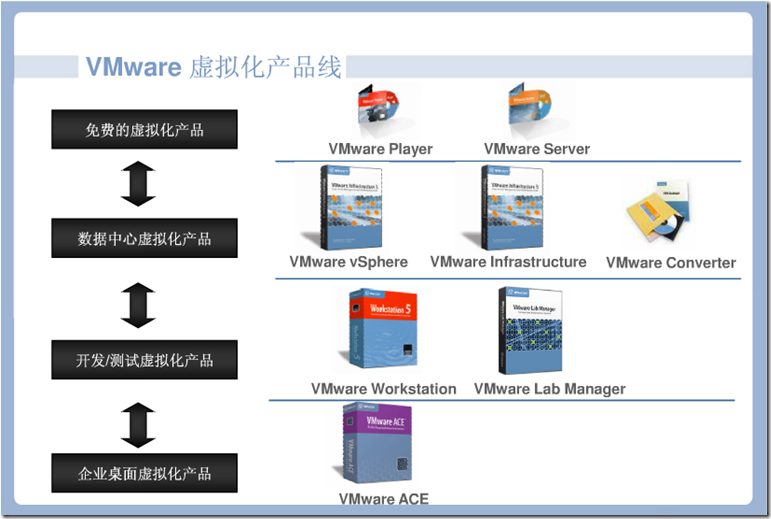

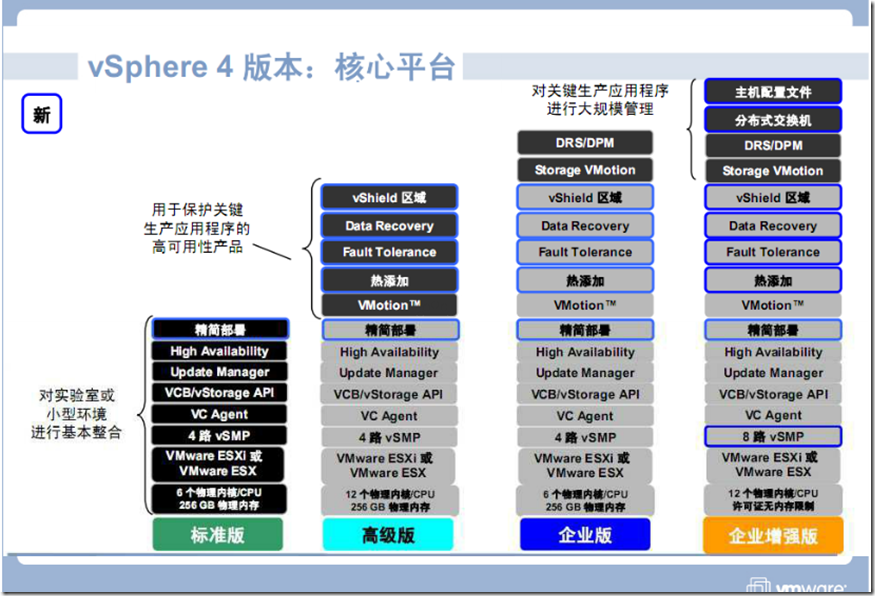

ESXi免费版本60天试用期后锁定高级特性。可以用来测试或者验证微软产品补丁,例如用p2v克隆生产主机验证补丁

例如不能备份,因为API被锁定了,还有32GB内存限制

付费的最小功能版本为VMware vSphere Essentials,可以做备份。和snapshot,可以管理3个ESXi主机用vcenter

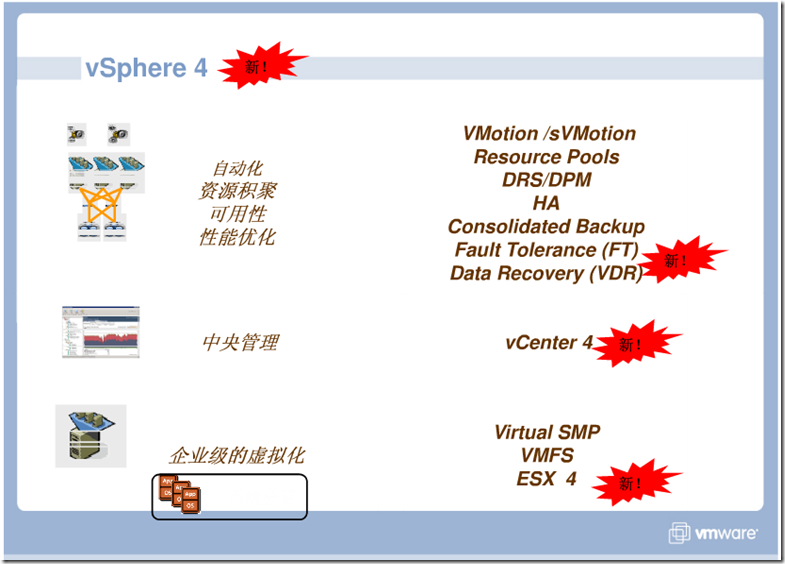

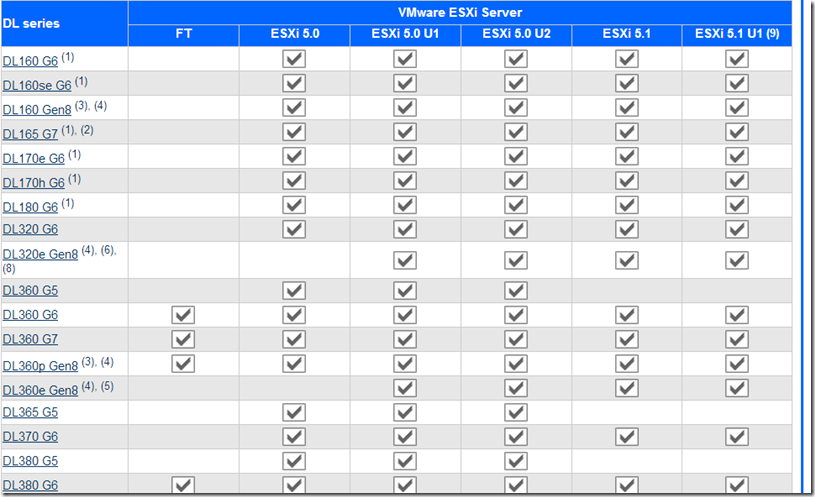

VMware已经正式发布了vSphere 5的产品组件,其中核心产品—-服务器虚拟化产品,由原来的两个产品VMware ESX Server与VMware ESXi,变成了单一的VMware ESXi 5

Dell的DRAC的虚拟介质

使用虚拟介质,管理员可以远程引导其受管服务器,安装应用程序,更新驱动程序,甚至从虚拟 CD/DVD 和软盘驱动器远程安装新操作系统。虚拟介质为受管服务器的操作系统和 BIOS 定义了两种设备:软盘设备和光盘设备

vsphere 5.1新改进

http://www.vmware.com/files/pdf/products/vsphere/vmware-what-is-new-vsphere51.pdf

选购服务器时要参考的文章:

iSCSI 是唯一受 Exchange 2007 支持的基于网络的存储。虽然 iSCSI 通过以太网将服务器连接到存储,但要将其视为您的存储连接并将 iSCSI 存储网络与其他所有网络通信完全隔离,这很重要。流控制、服务质量 (QoS) 和大型帧等选项(如果可用)可进一步提高性能。Microsoft iSCSI Initiator 2.0 支持多路径 I/O (MPIO)。在 Microsoft 测试实验室中,我们在 3 块网卡上测到的速率都超过了 250 MB/秒,证实了 iSCSI 能够作为要求高吞吐量的方案的存储传输。http://technet.microsoft.com/zh-CN/library/bb738146(v=exchg.80).aspx

http://hi.baidu.com/lanbo0829/item/11712ade2682ed1dd78ed011

需要注意的是,这里的FC一枝独秀是因为FC是4Gb/s带宽,而其他3种则是1Gb/s的千兆以太网)

以上性能测试是基于相同的单个千兆链路来比较的。但是,实际应用中,NFS不支持多个vmkernel连接到同一个datastore,而iSCSI则通 过VMware原生的多路径(NMP, Native Multi-Path)支持,因此用iSCS连接I可以聚合多条千兆链路,因此到一个datastore的总 吞吐量iSCSI大于NFS。当然,对于单个VM来说,因为一个TCP session被局限在一个通路(path)上,所以单VM的datastore访问总是有1Gb/s的上限。对于整个HOST访问同一个 datastore来说,iSCSI的吞吐量性能胜过NFS许多。

只有FC支持MSCS(微软集群),如 果你必须用MSCS,那只有一个选择了。其次,FC和iSCSI支持VMware NMP (Native Multi-Path)

说说我的环境,每台email服务器的平均吞吐量在 60Mbps, 平均disk IO大概是60/s,峰值时disk IO可以到200;SQL server的平均吞吐量在1Mbps,disk IO 10左右;其他各种应用服务器的平均disk IO均在3以下,多数1-2,Throughput在0.xMbps。因为我不打算将已经做了群集的邮件服务器和SQL服务器虚拟化,所以对于大多数服务 器来说,迁移到虚拟平台上,单Gb的通道已经足够。所以我最终还是选择NFS作为我的存储连接协议。

2008年。目前,英特尔不仅有针对CPU虚拟化的VT-X(X86平台)和VT-I(安腾平台)技术,也有针对芯片组的VT-D,还有这种最新的针对网络IO连接的虚拟化技术VT-C

虚拟化由于有二层的软交换,以往的做法是需要对每一个数据包进行处理,这样会导致网络吞吐量下降,CPU负载增加,使系统运行速度变慢。

据现场技术人员介绍,针对这种瓶颈,英特尔通过将硬件上的多个虚拟化设备队列和多个CPU内核之间进行映射,这样就使得之间的交换是以队列为单位,而不是以包为单位,即从包交换的级别提升到了队列交换的级别,从而大大提升了网络的吞吐量。

英特尔现场还进行了DEMO演示,在一台运行8个VMWARE虚拟机的系统上,如果没有采用英特尔的VMDQ(虚拟化设备队列)技术,万兆以太网的带宽是4GB/s,而如果有了这个技术,就能够达到9.2GB/s。

现场技术人员进一步解释到,这种技术主要是存于以太网芯片的MAC层,一个端口做很多个队列,一个应用进来,可以放到一个队列里面,然后和CPU核进行对应,所以,以往的应用是一个核一个队列,现在是多个核多个队列,从而可以充分发挥多核架构的性能。