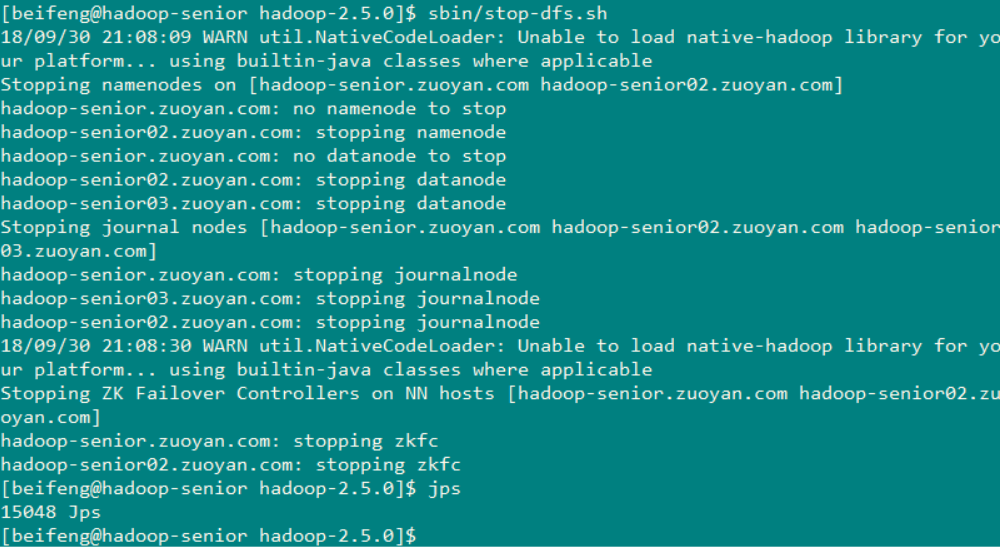

1.首先关闭机器上之前配置的分布式Hadoop

命令: (在hadoop的安装目录中) sbin/stop-dfs.sh

关闭: yarn 命令: sbin/stop-yarn.sh

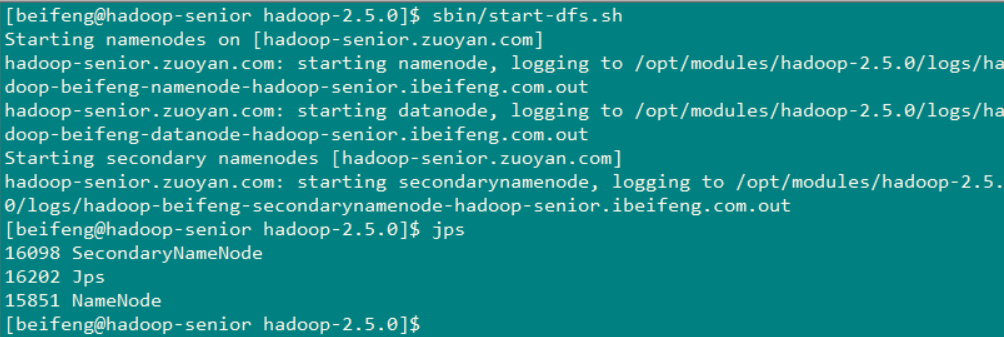

2.先使用hadoop-senior.zuoyan.com 上的 伪分布式Hadoop进行配置 Hive (将需要的文件上传到服务器上)

2.1 启动 hdfs

2.2 启动yarn

2.3 将secondaryNamenode 停止掉 节省点内存 命令:sbin/hadoop-daemon.sh stop secondarynamenode

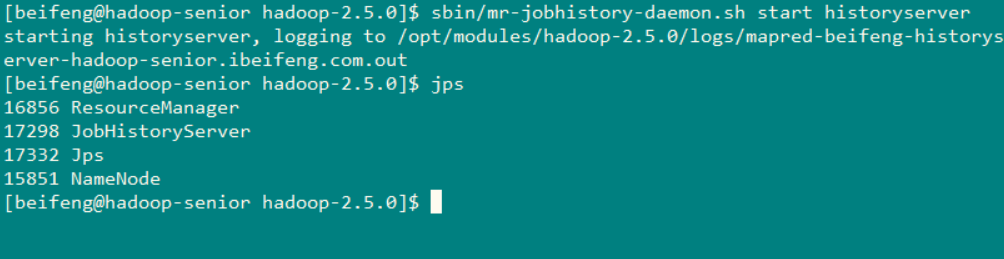

2.4 启动historyserver

命令: sbin/mr-jobhistory-daemon.sh start historyserver

3.将Hive的安装包进行解压

tar -zxvf apache-hive-0.13.1-bin.tar.gz -C /opt/modules/

更改一下名称:

mv apache-hive-0.13.1-bin/ hive-0.13.1

4.进入Hive解压目录中进行配置文件

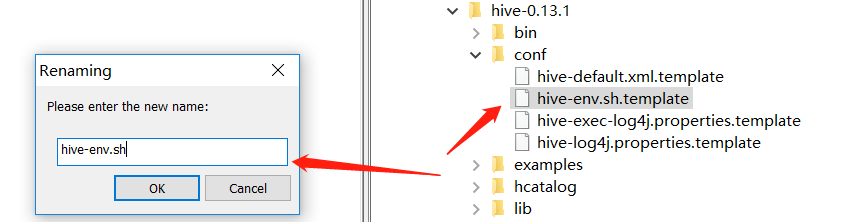

4.1 更改文件名称 将 hive-env.sh.template 更改为hive.env.sh

4.2 设置Hadoop_Home 和Hive的conf

这个具体的目录 根据自己的实际情况来改

4.3查看dfs文件系统上的文件目录 创建 tmp 文件目录 和 /user/hive/warehouse(如果没有这个目录,默认创建的就是这个目录,用来存放Hive中的表)

创建dfs上的目录 命令 :

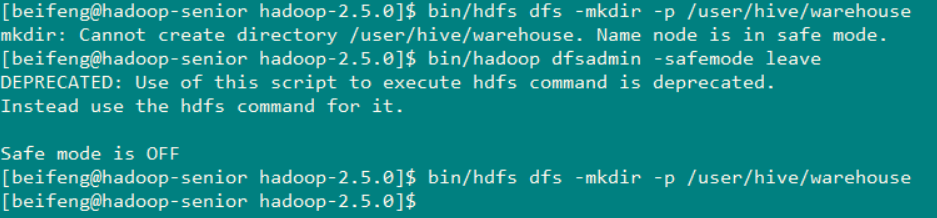

mkdir: Cannot create directory /user/hive/warehouse. Name node is in safe mode.

结果出现了意外 !!! Σ( ° △ °|||)︴

![]()

可以很明白的看见 在安全模式下

执行命令 :bin/hadoop dfsadmin -safemode leave 就可以解决这个问题,然后在创建文件目录

创建好文件目录后,就需要对这两个文件目录赋予权限

命令

bin/hdfs dfs -chmod g+x /tmp bin/hdfs dfs -chmod g+x /user/hive/warehouse

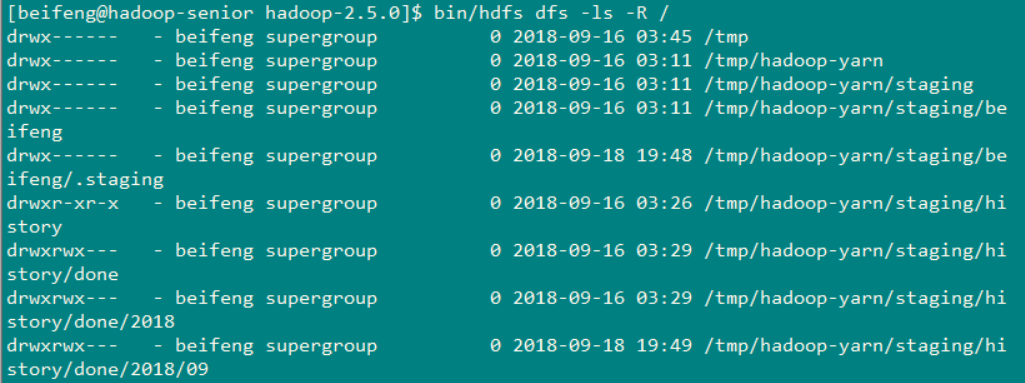

查看一下权限 bin/hdfs dfs -ls -R /

![]()

![]()

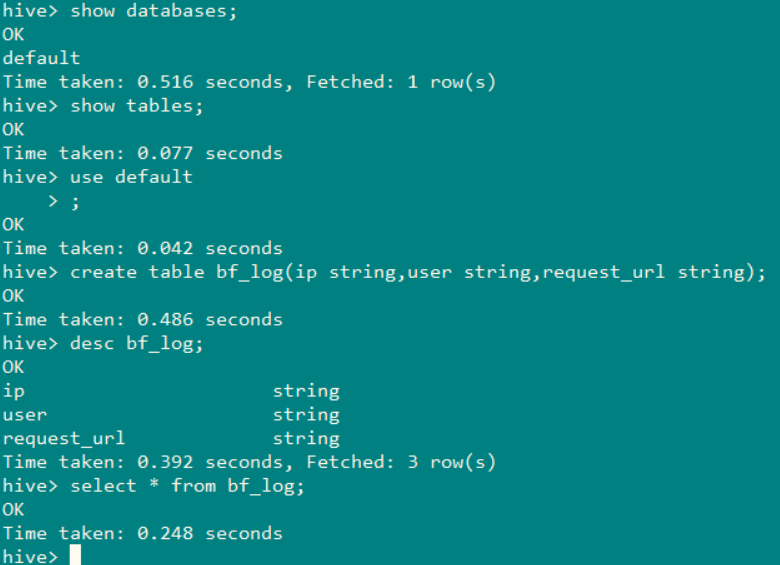

5.打开Hive

使用命令: bin/hive

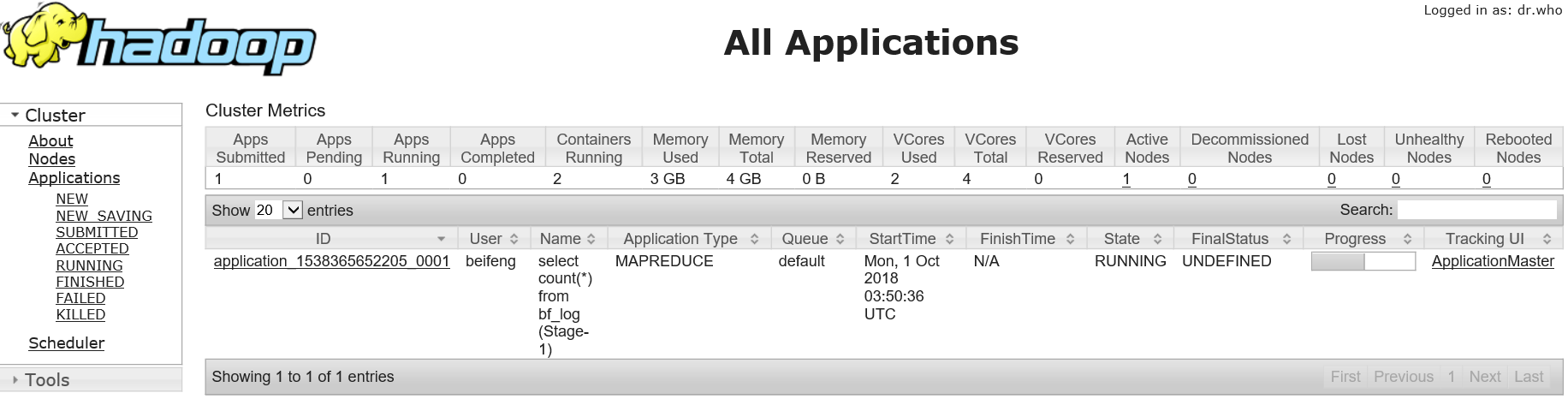

可以使用count(*) 命令来统计 ,可以查看出使用的就是yarn