Abstract

The recent success of deep neural networks relies on massive amounts of labeled data. For a target task where labeled data is unavailable, domain adaptation can transfer a learner from a different source domain. In this paper, we propose a new approach to domain adaptation in deep networks that can jointly learn adaptive classifiers and transferable features from labeled data in the source domain and unlabeled data in the target domain. We relax a shared-classifier assumption made by previous methods and assume that the source classifier and target classifier differ by a residual function. We enable classifier adaptation by plugging several layers into deep network to explicitly learn the residual function with reference to the target classifier. We fuse features of multiple layers with tensor product and embed them into reproducing kernel Hilbert spaces to match distributions for featureadaptation. Theadaptationcanbeachievedinmostfeed-forwardmodelsby extending them with new residual layers and loss functions, which can be trained efficiently via back-propagation. Empirical evidence shows that the new approach outperforms state of the art methods on standard domain adaptation benchmarks.

深度神经网络最近的成功依赖于大量的标记数据。对于标记数据不可用的目标任务,域自适应可以从不同的源域传输学习者。在本文中,我们提出了一种深层网络领域适应的新方法,它可以从源域的标记数据和目标域中的未标记数据联合学习自适应分类器和可转换特征。我们放宽先前方法所做的共享分类假设,并假设源分类器和目标分类器因残差函数而不同。我们通过将多个图层插入深度网络来实现分类器自适应,以参照目标分类器明确地学习残差函数。我们将张量积的多层特征融合,并将它们嵌入到再生核Hilbert空间中,以匹配特征的分布。通过扩展新的残余层和损失函数,可以实现适应性最优的前馈模型,这些函数可以通过反向传播有效地训练。经验证据表明,这种新方法优于标准域适应基准测试方法

1 Introduction

深度网络已经显着改善了各种机器学习问题和应用的现状。 不幸的是,这些令人印象深刻的业绩增长只有当大量的标签数据可用于监督培训。 由于对不同应用领域的足够培训数据进行手工标记通常是禁止的,对于缺乏标签数据的问题,建立有效的算法来减少贴标签消费是有强烈的动机的,通常是利用现成的标签 来自不同但相关来源域的数据。 然而,这种学习模式受到不同领域的数据分布的变化的影响,这为适应目标任务的预测模型提出了一个主要障碍[1]。

领域适应[1]是在训练和测试分布之间转换的机器学习。 丰富的领域适应方法旨在通过学习领域不变的特征表示而不使用目标标签来衔接源域和目标域,也就是说,源自域的类可以应用于目标域。 最近的研究表明,衰退网络可以阻止更多的可转换特性,从而保持领域的完整性[2,3]。 将领域适应嵌入到深度学习领域,获得了最新的进展,这些领域的领域是不变的表示[4,5,6,7]。

Thepreviousdeepdomainadaptationmethodsworkundertheassumptionthatthesourceclassifiercan be directly transferred to the target domain upon the learned domain-invariant feature representations. This assumption is rather strong as in practical applications, it is often infeasible to check whether the source classifier and target classifier can be shared or not. Hence we focus in this paper on a more general, and safe, domain adaptation scenario in which the source classifier and target classifier differ by a small perturbation function. The goal of this paper is to simultaneously learn adaptive classifiers and transferable features from labeled data in the source domain and unlabeled data in the target domain by embedding the adaptations of both classifiers and features in a unified deep architecture.

以前的深入研究方法的工作是假设源类可以直接通过学习的域不变特征表示转移到目标域。 这个假设在实际应用中相当强大,检查源分类器和目标分类器是否可以共享是不可行的。 因此,本文将重点放在一个更一般和安全的领域适应场景中,其中源分类器和目标分类器的区别在于一个小的扰动函数。 本文的目标是通过将分类器和特征的适应性嵌入到统一的深层架构中,同时从源域中的标记数据和目标域中的未标记数据中学习自适应分类器和可转换特征。

Motivated by the state of the art deep residual learning [8], winner of the ImageNet ILSVRC 2015 challenge, we propose a new Residual Transfer Network (RTN) approach to domain adaptation in deepnetworkswhichcansimultaneouslylearnadaptiveclassifiersandtransferablefeatures. Werelax the shared-classifier assumption made by previous methods and assume that the source and target classifiers differ by a small residual function. We enable classifier adaptation by plugging several layersintodeepnetworkstoexplicitlylearntheresidualfunctionwithreferencetothetargetclassifier. In this way, the source classifier and target classifier can be bridged tightly in the back-propagation procedure. The target classifier is tailored to the target data better by exploiting the low-density separation criterion. We fuse features of multiple layers with tensor product and embed them into reproducingkernelHilbertspacestomatchdistributionsforfeatureadaptation. Theadaptationcanbe achieved in most feed-forward models by extending them with new residual layers and loss functions, and can be trained efficiently using standard back-propagation. Extensive evidence suggests that the RTN approach outperforms several state of art methods on standard domain adaptation benchmarks.

受到ImageNet ILSVRC 2015挑战赛冠军的深度残留学习[8]的启发,我们提出了一种新的残留传输网络(RTN)方法来实现深层网络中的域适应,同时具有自适应的分类和可传输特性。 Werelax通过以前的方法所做的共享分类器假设,并假设源和目标分类器的差别在于一个小的残差函数。我们通过插入多个层次的网络来实现分类器的适应性,并且参照目标分类器来隐式地描述个别的功能。这样,源分类器和目标分类器就可以在反向传播过程中被紧密地桥接起来。目标分类器是通过利用低密度分离标准更好地适应目标数据。我们融合了张量产品的多层特征,并将它们嵌入到复制核心空间的空间分布中,以供用户使用。在大多数前馈模型中,可以通过扩展新的残差层和损失函数来实现适应性,并且可以使用标准的反向传播有效地进行训练。大量的证据表明,RTN方法在标准域适应基准方面胜过了几种最先进的方法。

2 RelatedWork

Domain adaptation [1] builds models that can bridge different domains or tasks, which mitigates the burden of manual labeling for machine learning [9, 10, 11, 12], computer vision [13, 14, 15] and natural language processing [16]. The main technical problem of domain adaptation is that the domain discrepancy in probability distributions of different domains should be formally reduced. Deep neural networks can learn abstract representations that disentangle different explanatory factors of variations behind data samples [17] and manifest invariant factors underlying different populations that transfer well from original tasks to similar novel tasks [3]. Thus deep neural networks have been explored for domain adaptation [18, 19, 15], multimodal and multi-task learning [16, 20], where significant performance gains have been witnessed relative to prior shallow transfer learning methods.

领域适应[1]建立模型,可以桥接不同的领域或任务,这减轻了机器学习[9,10,11,12],计算机视觉[13,14,15]和自然语言处理[16]。 领域适应的主要技术问题是正式减少不同领域的概率分布的领域差异。 深度神经网络可以学习抽象表示,这些抽象表示可以解决数据样本背后的不同变化的解释因素[17],并显示不同种群之间不变的因素,从不同的原始任务转移到类似的新任务[3]。 因此,深层神经网络已经被用于领域适应[18,19,15],多模式和多任务学习[16,20],其中相对于现有的浅层传递学习方法已经见证了显着的性能增益。

However, recent advances show that deep networks can learn abstract feature representations that can only reduce, but not remove, the cross-domain discrepancy [18, 4]. Dataset shift has posed a bottleneck to the transferability of deep features, resulting in statistically unbounded risk for target tasks [21, 22]. Some recent work addresses the aforementioned problem by deep domain adaptation, which bridges the two worlds of deep learning and domain adaptation [4, 5, 6, 7]. They extend deep convolutional networks (CNNs) to domain adaptation either by adding one or multiple adaptation layers through which the mean embeddings of distributions are matched [4, 5], or by adding a fully connected subnetwork as a domain discriminator whilst the deep features are learned to confuse the domain discriminator in a domain-adversarial training paradigm [6, 7]. While performance was significantly improved, these state of the art methods may be restricted by the assumption that under the learned domain-invariant feature representations, the source classifier can be directly transferred to the target domain. In particular, this assumption may not hold when the source classifier and target classifier cannot be shared. As theoretically studied in [22], when the combined error of the ideal joint hypothesis is large, then there is no single classifier that performs well on both source and target domains, so we cannot find a good target classifier by directly transferring from the source domain.

然而,最近的进展表明,深度网络可以学习抽象的特征表示,只能减少,但不能消除跨域的差异[18,4]。数据集转换已经成为深度特征转移的瓶颈,导致目标任务的统计无限风险[21,22]。最近的一些工作通过深层领域适应来解决上述问题,它们将深度学习和领域适应这两个世界联系在一起[4,5,6,7]。它们将深度卷积网络(CNN)扩展到域自适应,要么增加一个或多个适配层,通过这个层来平均分布的嵌入匹配[4,5],要么增加一个完全连接的子网络作为域鉴别器,而深度特征是在领域对抗训练模式中学会混淆领域鉴别器[6,7]。虽然性能得到了显着的改善,但是这些最先进的方法可能受到以下假设的限制:在学习的域不变特征表示下,源分类器可以直接转移到目标域。特别是,当源分类器和目标分类器不能共享时,这个假设可能不成立。正如理论上在[22]中所研究的那样,当理想联合假设的组合误差很大时,在源域和目标域都没有单独的分类器,所以我们无法通过直接从源头转移来找到一个好的目标分类器域。

This work is primarily motivated by Heetal.[8],thewinneroftheImageNetILSVRC2015challenge. They present deep residual learning to ease the training of very deep networks (hundreds of layers), termed residual nets. The residual nets explicitly reformulate the layers as learning residual functions ∆F(x) with reference to the layer inputs x, instead of directly learning the unreferenced functions F(x) = ∆F(x) + x. The method focuses on standard deep learning in which training data and test data are drawn from identical distributions, hence it cannot be directly applied to domain adaptation. In this paper, we propose to bridge the source classifier fS(x) and target classifier fT(x) by the residual layers such that the classifier mismatch across domains can be explicitly modeled by the residual functions ∆F(x) in a deep learning architecture. Although the idea of adapting source classifier to target domain by adding a perturbation function has been studied by [23, 24, 25], these methods require target labeled data to learn the perturbation function, which cannot be applied to unsupervised domain adaptation, the focus of this study. Another distinction is that their perturbation function is defined in the input space x, while the input to our residual function is the target classifier fT(x), which can capture the connection between the source and target classifiers more effectively.

这项工作的主要动机是Heetal [8],是图像网络VRC2015挑战者。他们提出了深度的剩余学习,以减轻深度网络(数百层)的训练,被称为残余网络。剩余网络明确地将层重新定义为参照层输入x的学习残差函数ΔF(x),而不是直接学习非参考函数F(x)=ΔF(x)+ x。该方法重点在于标准的深度学习,其中训练数据和测试数据是从相同的分布得出的,因此不能直接应用于域的适应。在本文中,我们建议通过残差层来连接源分类器fS(x)和目标分类器fT(x),使得在深度学习中残差函数ΔF(x)可以明确地建模跨域的分类器失配建筑。尽管通过添加扰动函数来调整源分类器到目标域的思想已经被[23,24,25]研究,但是这些方法需要目标标记的数据来学习扰动函数,其不能应用于无监督域适应,焦点这项研究。另一个区别是它们的扰动函数是在输入空间x中定义的,而剩余函数的输入是目标分类器fT(x),它可以更有效地捕获源分类器和目标分类器之间的连接。

3 ResidualTransferNetworks

在无监督的域自适应问题中,我们给出了源标签的示例,并给出了一个未标记示例的目标域Ds = {xt j} nt j = 1。 源域和目标域分别从不同的概率分布p和q中采样,并且p 6 = q。 本文的目的是设计一个深度神经网络,使得能够学习转移分类器y = fs(x)和y = ft(x)来关闭源 - 目标差异,使得预期目标风险Rt(ft)= E(x,y)〜q [ft(x)6 = y]可以通过利用源域监督数据来限制。

无监督域自适应的挑战在于目标域没有标记数据,而在源域D上训练的源分类器fs由于分布差异而不能直接应用到目标域Dt(x,y)6 = q(x,Y)。 分布差异可能引起特征和分类器的不匹配,即p(x)= q(x)和fs(x)= ft(x)。 这两个不匹配应通过特征和分类器的联合调整来确定,以实现有效的域适应。 Classi fi er适应比特征适应更困难,因为它与标签直接相关,但目标域完全没有标签。 请注意,最先进的深度特征自适应方法[5,6,7]通常假设分类器可以共享适应的深度特征。 本文假设fs 6 = ft,并为分类器适应提供了一个端到端的深度学习框架。

深度网络[17]可以学习自然数据(如图像和文本)的分布式,组合和抽象表示。 本文针对深度网络中的无监督域适应问题,联合学习可转移特征和自适应分类器。 我们将深度卷积网络(CNN),即AlexNet [26]扩展到如图1所示的新型残差传输网络(RTN)。 用fs(x)表示源分类器,源域数据D上CNN的经验误差为L(·,·)为交叉熵损失函数。 基于深度卷积网络中特征可转移性的量化研究[3],卷积层可以学习跨域转移的泛型特征[3]。 因此,当将预先训练好的深层模型从源域转移到目标域时,我们选择调整而不是直接调整卷积层的特征。

3.1 FeatureAdaptation

与DAN [5]不同,DAN使用多个MMD惩罚来适应多个特征层,本文首先融合多个特征层,然后对融合特征进行自适应。 我们的方法与DAN的优势在于,我们的方法可以捕获多层特征之间的全面交互,并且更容易进行模型选择,而DAN [5]需要| L |独立的MMD惩罚来适应| L |层。

图1:(左)基于完善的体系结构的用于域自适应的剩余传输网络(RTN)。 由于数据集的移动,(1)最后一层的特征是针对不能安全转移的领域特定的结构,因此我们增加了一个瓶颈层fcb,它由张量MMD模块与分类层fcc联合调整; (2)有监督的分类器是不可安全转移的,因此通过剩余的层来运行它们,其中f(x)= fT(x)+Δf(x)。 (中)用于多层特征适应的张量MMD模块。 (右)用于深度残差学习的构件;我们用它来将源分类器fS(x)和目标分类器fT(x)与x,fT(x),F (x),fS(x)和ΔF(x),Δf(x)。

3.2 ClassifierAdaptation

由于特征自适应不能消除分类模型中的不匹配,我们进一步执行分类器自适应来学习使得域适应更有效的传递分类器。虽然源分类器fs(x)和目标分类器ft(x)是不同的,fs(x)6 = ft(x),它们应该相关以确保域适应的可行性。假设fs(x)和ft(x)仅通过微扰函数Δf(x)是有区别的。先前的分类器自适应[23,24,25]的工作假设ft(x)= fs(x)+Δf(x),其中扰动Δf(x)是输入特征x的函数。然而,这些方法要求目标标记的数据学习扰动函数,不能应用于目标域没有标记数据的无监督域自适应。如何在框架中桥接fs(x)和ft(x)是无监督域适应的关键挑战。假设源分类器和目标分类器被正确连接,我们假定扰动函数Δf(x)可以从源标签数据和目标未标签数据共同学习。

To enable classifier adaptation, consider fitting F(x) as an original mapping by a few stacked layers (convolutional or fully connected layers) in Figure 1 (right), where x denotes the inputs to the first of these layers [8]. If one hypothesizes that multiple nonlinear layers can asymptotically approximate complicated functions, then it is equivalent to hypothesize that they can asymptotically approximate the residual functions, i.e. F(x)−x. Rather than expecting stacked layers to approximate F(x), one explicitly lets these layers approximate a residual function ∆F(x) , F(x)−x, with the original function being ∆F(x) + x. The operation ∆F(x) + x is performed by a shortcut connection and an element-wise addition, while the residual function is parameterized by residual layers within each residualblock. Although both forms are able to asymptotically approximate the desired functions,the ease of learning is different. In reality, it is unlikely that identity mappings are optimal, but it should be easier to find the perturbations with reference to an identity mapping, than to learn the function as new. The residual learning is the key to the successful training of very deep networks. The deep residual network (ResNet) framework [8] bridges the inputs and outputs of the residual layers by the shortcut connection (identity mapping) such that F(x) = ∆F(x) + x, which eases the learning of residual function ∆F(x) (similar to the perturbation function across the source and target classifiers).

为了实现分类器自适应,考虑将F(x)作为原始映射,由图1(右)中的几个堆叠层(卷积层或完全连接层)进行映射,其中x表示第一层的输入[8]。如果假设多个非线性层可以渐近逼近复杂函数,那么相当于假设它们可以渐近地逼近剩余函数,即F(x)-x。而不是期望堆叠层接近F(x),明确地让这些层接近残留函数ΔF(x),F(x)-x,原始函数是ΔF(x)+ x。操作ΔF(x)+ x通过快捷连接和元素相加执行,而残差函数由每个残差块内的残差层参数化。虽然双方都可以简单地接近所需的功能,但是学习的难度是不同的。在现实中,身份映射不太可能是最优的,但是参照身份映射发现扰动应该更容易,而不是学习新的功能。剩余学习是深度网络成功培训的关键。深度残差网络(ResNet)[8]通过快捷连接(恒等映射)桥接剩余层的输入和输出,使得F(x)=ΔF(x)+ x,这简化了剩余函数的学习ΔF(x)(类似于源和目标分类器的扰动函数)。

基于这一关键观察,我们通过插入残余块来扩展CNN架构(图1,左侧)(图1,右侧)。 我们通过设x,fT(x),F(x),fS(x)和ΔF(x),Δf(x)来重构残差块以桥接源分类器fS(x)和目标分类器fT X)。 请注意,fS(x)是元素加法运算符的输出,fT(x)是目标分类层fcc的输出,在softmax激活之前(),fs(x),σ(fS(x) ),ft(x),σ(fT(x))。 我们可以将源分类器和目标分类器(在激活之前)通过剩余块连接起来

我们使用softmax之前的残差块的函数fS和fT来确保最终的分类器fs和ft将输出概率。 剩余层fc1-fc2是具有c×c个单元的完全连接层,其中c是类的数量。 我们将源分类器fS设置为残差块的输出,以便通过深度残差学习从源标记的数据更好地训练[8]。 换句话说,如果我们将fT设置为残差块的输出,那么我们可能无法成功地学习它,因为我们没有目标标记的数据,因此反向传播将不起作用。 深度残差学习[8]确保输出有效的分类器|Δf(x)|?| fT(x)|≈| fS(x)|,更重要的是使扰动函数Δf(x) 目标分类器fT(x)(由于函数依赖)以及源分类器fS(x)(由于反向传播流水线)。

尽管我们成功地将分类器自适应投入到剩余学习框架中,而剩余学习框架倾向于使目标分类器ft(x)不会偏离源分类器fs(x),但是我们仍然不能保证ft(x) 目标特定的结构很好。 为了解决这个问题,我们进一步利用熵最小化原则[28]来提高分类器的适应性,通过最小化类条件分布的熵来促进类之间的低密度分离。()()() = j | xt i; ft)在目标域dataDt上

其中H(·)是类条件分布的熵函数,定义为H(ft(xt i))= -Pc j = 1 ft j(xt i)logft j(xt i),c 类别的数量,并且ft j(xt i)是将点xt i预测到类别j的概率。 通过最小化熵惩罚(4),目标分类器ft(x)可直接被目标未标记的数据访问,并将自身修改为通过目标低密度区域

3.3 ResidualTransferNetwork

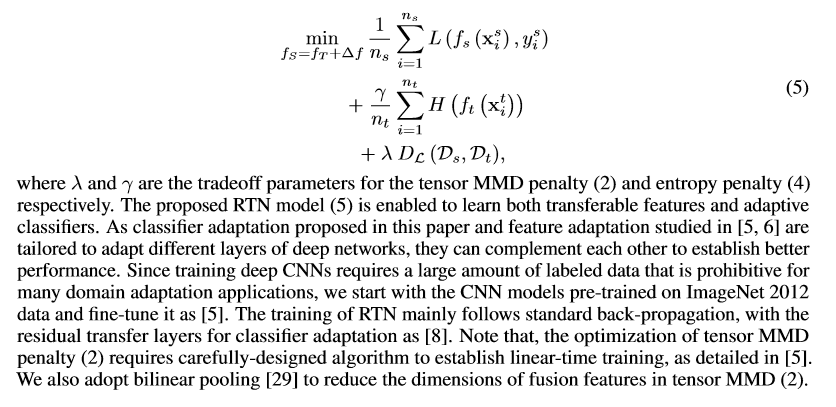

为了实现有效的无监督域自适应,我们提出了结合深度特征学习(1),特征适应(2)和分类器适应(3) - (4)共同学习可转移特征和自适应分类器的剩余转移网络(RTN) 端到端学习框架,

其中λ和γ分别是张量MMD惩罚(2)和熵惩罚(4)的权衡参数。建议的RTN模型(5)能够学习可传递的特征和自适应分类器。由于本文提出的分类器自适应和[5,6]研究的特征适应是针对深层网络的不同层次进行调整的,因此可以互相补充教授其他方面来建立更好的性能。由于训练深度的CNN需要大量的标记数据,这对于许多领域适应应用来说是禁止的,所以我们从预先在ImageNet 2012数据上训练的CNN模型开始,并将其调整为[5]。 RTN的训练主要遵循标准的反向传播,剩余传输层用于分类器适配[8]。请注意,张量MMD惩罚(2)的优化需要仔细设计算法来建立线性时间训练,详见[5]。我们也采用双线性汇聚[29]来减少张量MMD中融合特征的维数(2)。

4 Experiments

我们评估残余传输网络对艺术转移学习和深度学习方法。 代码sanddata集将可在https://github.com/thuml/transfer-caffe。

4.1 Setup

文献[31]是一个域名适应的基准,其中包括从三个不同领域收集的31个类别中的4110个图像:包含从amazon.com,Webcam(W)和DSLR(D)下载的图像的Amazon(A) 包含分别由网络摄像机和数码单反相机拍摄的具有不同照片设置的图像。 为了实现无偏评估,我们评估了所有六个传输任务A→W,D→W,W→D,A→D,D→AandW→Aasin的所有方法[5,7]。

加州理工学院[14]是通过选择Of-ce-31和Caltech256(C)共享的10个常见类别而建立的,并被以前的方法广泛使用[14,30]。 我们可以建立12个传输任务:A→W,D→W,W→D,A→D,D→A,W→A,A→C,W→C,D→C,C→A,C→W ,C→D。 而办公室-31有更多的类别,更难以适应领域的算法,办公室加州理工学院提供更多的转移任务,使无偏见的数据集偏见[31]。 我们采用DeCAF7 [2]特征作为浅转换方法,采用原始图像作为深度适应方法。

我们比较常规和最先进的转移学习和深度学习方法:转移成分分析(TCA)[9],测地流核(GFK)[14],深度卷积神经网络(AlexNet [26]),深度域混淆(DDC)[4],深度适应网络(DAN)[5]和反向梯度(RevGrad)[6]。 TCA是一种基于MMD正则化Kernel PCA的传统学习方法。 GFK是一种多种学习方法,可以插入无限多个中间子空间以桥接域。 DDC是通过使用线性内核MMD向AlexNet添加适配层来最大化域不变性的第一种方法[27]。 DAN通过嵌入多个特定任务层的深层特征来再现核Hilbert空间(RKHS),并使用多核MMD优化匹配不同分布,从而学习更多的可转换特性。 RevGrad通过一个对立的训练范例,使得源域和目标域对于一个有区别的域分类器不可区分,从而改善了域的适应性

我们遵循标准协议,并使用所有标记的源数据和所有未标记的目标数据进行域适应[5]。 我们使用三个随机实验来比较每个传输任务的平均分类精度。 对于基于MMD的方法(TCA,DDC,DAN和RTN),我们使用带宽b设置为训练数据中值平均距离的高斯核,即中值启发式[27]。 由于在无监督的领域适应没有目标标记的数据,模型选择证明是困难的。 对于所有的方法,我们对带标签的源数据进行交叉评估以选择候选参数,然后对传输任务A进行验证→从目标域中的每个类别需要一个标记示例作为验证集,并在所有传输任务中选择所选参数。

我们实现了所有基于Caffe深度学习框架的深层方法,并从Caffe提供的AlexNet [26]模型中对ImageNet进行了预先训练。对于RTN,我们通过标准的反向传播对所有的功能层,trainbottlenecklayer fcb,classi fi erlayer fcc和residuallayers fc1-fc2进行微调。由于这些新层是从零开始训练的,我们将他们的学习速率设置为其他层次的10倍。我们使用动量为0.9的小批量随机梯度下降(SGD)和在RevGrad中实现的学习速率退火策略[6]:学习速率不是通过网格搜索由于高计算成本而被选择 - 它在SGD使用期间被调整下面的公式为:ηp=η0(1 +αp)β,其中p是从0到1线性变化的训练过程,η0= 0.01,α= 10和β= 0.75,针对源域的低误差进行了优化。由于RTN可以在不同的传输任务中稳定工作,MMD惩罚参数λ和熵惩罚γ首先在A→W上选择,然后固定为λ= 0.3,对于所有其他传输任务γ= 0.3。

4.2 Results

表1显示了Of-ce-31的6个传输任务的分类精度结果,表2显示了Of-ce-Caltech的12个传输任务的结果。基于AlexNet的RTN模型(图1)优于所有的比较 大多数转移任务的方法。 特别地,RTN大大提高了硬传输任务的准确性,例如, A→WandC→W,其中源域和目标域是非常不同的,并且在容易的转移任务D→WandW→D,其中源域和目标域相似的情况下,具有相当的准确性[13]。 这些结果表明,RTN能够学习更多的适应性分类器和更安全的域适应的可转换特征。

5 Conclusion

本文提出了一种在深度网络中进行无监督域自适应的新方法,它可以实现自适应分类器和可转换特征的端到端学习。 类似于许多现有的领域适应技术,特征适应是通过匹配域之间的特征分布来实现的。 然而,与以前的工作不同,所提出的方法也支持分类器自适应,它通过一个新的残差传输模块来实现,这个模块连接了源分类器和目标分类器。 这使得这种方法成为现有技术的一个很好的补充。 该方法可以通过标准的反向传播进行培训,这是可扩展的,可以通过最深入的学习包来实现。 未来的工作构成了半监督域适配扩展。