Redis-Cluster

redis使用中遇到的瓶颈

我们日常在对于redis的使用中,经常会遇到一些问题

1、高可用问题,如何保证redis的持续高可用性。

2、容量问题,单实例redis内存无法无限扩充,达到32G后就进入了64位世界,性能下降。

3、并发性能问题,redis号称单实例10万并发,但也是有尽头的。

redis-cluster的优势

1、官方推荐,毋庸置疑。

2、去中心化,集群最大可增加1000个节点,性能随节点增加而线性扩展。

3、管理方便,后续可自行增加或摘除节点,移动分槽等等。

4、简单,易上手。

redis-cluster名词介绍

1、master 主节点、

2、slave 从节点

3、slot 槽,一共有16384数据分槽,分布在集群的所有主节点中。

redis-cluster简介

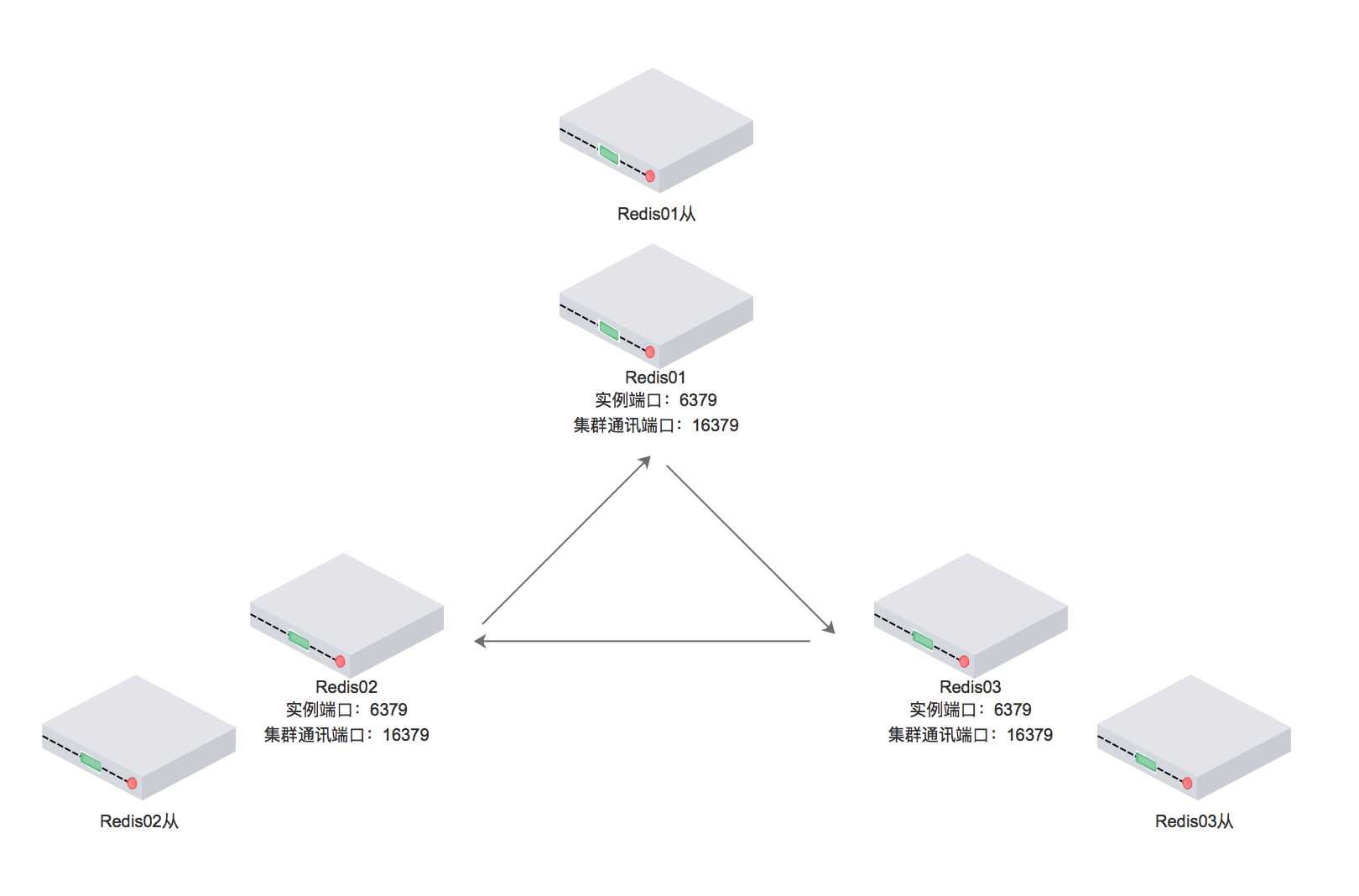

图中描述的是六个redis实例构成的集群

6379端口为客户端通讯端口

16379端口为集群总线端口

集群内部划分为16384个数据分槽,分布在三个主redis中。

从redis中没有分槽,不会参与集群投票,也不会帮忙加快读取数据,仅仅作为主机的备份。

三个主节点中平均分布着16384数据分槽的三分之一,每个节点中不会存有有重复数据,仅仅有自己的从机帮忙冗余。

集群部署

测试部署方式,一台测试机多实例启动部署。

安装redis

$ wget http://download.redis.io/releases/redis-3.2.8.tar.gz $ tar xzf redis-3.2.8.tar.gz $ cd redis-3.2.8 $ make

修改配置文件 redis.conf

#redis.conf默认配置 daemonize yes pidfile /var/run/redis/redis.pid #多实例情况下需修改,例如redis_6380.pid port 6379 #多实例情况下需要修改,例如6380 tcp-backlog 511 bind 0.0.0.0 timeout 0 tcp-keepalive 0 loglevel notice logfile /var/log/redis/redis.log #多实例情况下需要修改,例如6380.log databases 16 save 900 1 save 300 10 save 60 10000 stop-writes-on-bgsave-error yes rdbcompression yes rdbchecksum yes dbfilename dump.rdb #多实例情况下需要修改,例如dump.6380.rdb slave-serve-stale-data yes slave-read-only yes repl-diskless-sync no repl-diskless-sync-delay 5 repl-disable-tcp-nodelay no slave-priority 100 appendonly yes appendfilename "appendonly.aof" #多实例情况下需要修改,例如 appendonly_6380.aof appendfsync everysec no-appendfsync-on-rewrite no auto-aof-rewrite-percentage 100 auto-aof-rewrite-min-size 64mb aof-load-truncated yes lua-time-limit 5000 slowlog-log-slower-than 10000 slowlog-max-len 128 latency-monitor-threshold 0 notify-keyspace-events "" hash-max-ziplist-entries 512 hash-max-ziplist-value 64 list-max-ziplist-entries 512 list-max-ziplist-value 64 set-max-intset-entries 512 zset-max-ziplist-entries 128 zset-max-ziplist-value 64 hll-sparse-max-bytes 3000 activerehashing yes client-output-buffer-limit normal 0 0 0 client-output-buffer-limit slave 256mb 64mb 60 client-output-buffer-limit pubsub 32mb 8mb 60 hz 10 #################自定义配置 #系统配置 #vim /etc/sysctl.conf #vm.overcommit_memory = 1 aof-rewrite-incremental-fsync yes maxmemory 4096mb maxmemory-policy allkeys-lru dir /opt/redis/data #多实例情况下需要修改,例如/data/6380 #集群配置 cluster-enabled yes cluster-config-file /opt/redis/6380/nodes.conf #多实例情况下需要修改,例如/6380/ cluster-node-timeout 5000 #从ping主间隔默认10秒 #复制超时时间 #repl-timeout 60 #远距离主从 #config set client-output-buffer-limit "slave 536870912 536870912 0" #config set repl-backlog-size 209715200

启动六个实例:

/编译安装目录/src/redis-server redis.conf

注意,redis.conf应为6个不同的修改过的多实例配置文件。

注意,配置文件复制六分后,有许多需要你修改的地方。

注:

安装部署部分不是无脑复制即可,请结合你的主机情况进行操作,若有问题可以联系我 QQ:2169866431

谢土豪