基础操作命令

rm jdk-7u7-linux-i586.tar.gz #删除文件命令

rm -rf 文件夹名 #删除文件夹(包括所有子文件)

mv jdk-7u7-linux-i586.tar.gz /usr/lib/java/ #文件移动

tar –xvf jdk-7u7-linux-i586.tar.gz #解压

mkdir /usr/lib/java #创建目录

cp -rf /conf/zoo_simple.cfg conf/zoo.cfg #拷贝文件移动

1.VwmareTools 工具安装(使用Ubuntu 最大化工具,虚拟机和windows机器自由复制)

1.1 菜单->虚拟机->重新安装VmwareTools工具

1.1 或者 apt-get install open-vm-tools

1.2 拷贝文件至桌面

mv VMwareTools-10.0.0-29977863.tar.gz ~/Desktop

这里的~线含义

cd ~ 当前用户目录

cd / 系统目录

cd - 打印当前目录层级

1.3 解压gz包

tar –zxvf VMwareTools-10.0.0-29977863.tar.gz

1.4 安装工具

sudo su #安装文件需要root 用户

vmware-install.pl #安装VMwareTools工具

shutdown -r now #重启

2.系统设置成默认登陆root 用户

2.1 安装vim,gedit编辑工具。

apt-get install vim

apt-get install gedit

2.2 编辑conf命令,使root用户可以自动登陆

vim etc/lightdm/lightdm.conf #编辑conf文件

[SeatDefaults]

greeter-session=unity-greeter

user-session=ubuntu

greeter-show-manual-login=ture

allow-guest=falseautologin-user=root

Esc:wq 保存并退出

sudo passwd root #设置登陆root用户的密码

shutdown -r now #重启

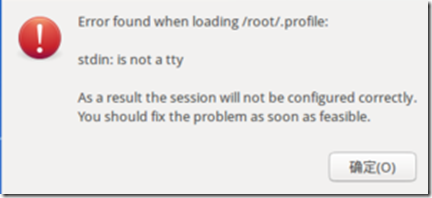

重启完毕后可能会出现以下错误

参照

http://jingyan.baidu.com/article/d5c4b52be0807fda560dc586.html

3. 安装JDK

3.1 查看Ubuntu 操作系统是64位,还是32位

sudo uname --m

x86_64 64位操作系统

i686 32位操作系统

3.2 下载对应的jdk版本,创建/usr/lib/java目录,并且把jdk拷贝到此目录下,并且解压

3.3 加入环境变量

vim ~/.bashrc #编辑环境变量

export JAVA_HOME=/usr/lib/java/jdk1.7.0_25

export JRE_HOME=$JAVA_HOME/jre #tomcat需要

export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

Esq:wq 保存并且退出

source ~/.bashrc #生效环境变量

3.4 查看java版本

java -version

4.安装ssh,ssh的主要作用是远程登陆

apt-get install ssh

/etc/init.d/ssh start #ssh 启动

ps -e |grep ssh #查看ssh 是否正常启动

ssh-keygen -t rsa -p "" #生成产品的公私钥

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys #把公钥放入登录目录中

ssh localhost #验证是否可以远程登陆

5.安装hadoop(这里下载的是hadoop-2.7.2版本)

5.1 下载对应的hadoop 版本,解压至/usr/local/hadoop目录下。

5.2 hadoop-env.sh 文件进行配置,该文件在/usr/local/hadoop/hadoop-2.7.2/etc/hadoop

export JAVA_HOME=/usr/lib/java/jdk1.7.0_25

export HADOOP_PID_DIR=/usr/local/hadoop/tmp

5.3 修改环境变量,追加Hadoop的工作路径

vim ~/.bashrc

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

注意:环境变量修改成下面的语句,追加hadoop的bin目录

export PATH=$JAVA_HOME/bin:/usr/local/hadoop/hadoop-2.7.2/bin:/usr/local/hadoop/hadoop-2.7.2/sbin:$JRE_HOME/bin:$PATH

5.4 查看hadoop 版本

hadoop version

5.5 hadoop 配置工作

/usr/local/hadoop/hadoop-2.7.2/etc/hadoop/core-site.xml

<configuration> <property> <name>fs.defalutFS</name> <value>hdfs://Master:8020</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/usr/local/hadoop/tmp</value> </property> </configuration>

/usr/local/hadoop/hadoop-2.7.2/etc/hadoop/hdfs-site.xml

<configuration> <property> <name>dfs.namenode.secondary.http-address</name> <value>Master:9001</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>/usr/local/hadoop/dfs/name</value> <!--建议先手动建好该目录--> </property> <property> <name>dfs.datanode.data.dir</name> <value>/usr/local/hadoop/dfs/data</value> <!--建议先手动建好该目录--> </property> <property> <name>dfs.replication</name> <value>3</value> <!--副本数目不能大于datanode数目--> </property> <property> <name>dfs.webhdfs.enabled</name> <value>true</value> </property> <property> <name>dfs.permissions</name> <!--防止出现不允许远程读写hdfs--> <value>false</value> </property> <property> <name>dfs.heartbeat.interval</name> <!--namenode每三秒发一个心跳信号--> <value>3</value> </property> <property> <name>dfs.namenode.heartbeat.recheck-interval</name> <!--心跳机制recheck的间隔--> <value>35000</value> </property> </configuration>

/usr/local/hadoop/hadoop-2.7.2/etc/hadoop/mapred-site.xml

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>mapreduce.jobhistory.address</name> <value>Master:10020</value> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>Master:19888</value> </property> </configuration>

/usr/local/hadoop/hadoop-2.7.2/etc/hadoop/yarn-site.xml

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property> <property> <name>yarn.resourcemanager.scheduler.address</name> <value>Master:8030</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>Master:8031</value> </property> <property> <name>yarn.resourcemanager.address</name> <value>Master:8032</value> </property> <property> <name>yarn.resourcemanager.admin.address</name> <value>Master:8033</value> </property> <property> <name>yarn.resourcemanager.webapp.address</name> <value>Master:8088</value> </property> </configuration>

/usr/local/hadoop/hadoop-2.7.2/etc/hadoop/slaves

slaver01

slaver02

gedit /etc/hosts

127.0.0.1 Master

192.168.39.135 slaver01

192.168.39.136 slaver02

gedit /etc/hostname

Master

hostname -F /etc/hostname #把hostname绑定到 /etc/hostname上面

执行hadoop 命令

hadoop namenode –format