1、安装依赖包

yum install -y gcc openssh-clients

2、升级glib2.14

升级glibc-2.14用到的rpm

下载地址:https://pan.baidu.com/s/1v-Uk579TGM6498cExst6ow

开始升级glib2.14

rpm -Uvh glibc-2.14.1-6.x86_64.rpm glibc-common-2.14.1-6.x86_64.rpm glibc-headers-2.14.1-6.x86_64.rpm glibc-devel-2.14.1-6.x86_64.rpm nscd-2.14.1-6.x86_64.rpm

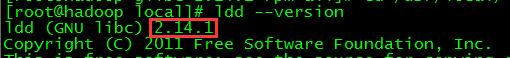

查看glib版本

ldd --version

3、配置jdk1.8

下载地址:https://pan.baidu.com/s/1wCJ4P3049nJyOCQDu8PYzw

将gz包放在/usr/local下

tar zxvf jdk-8u161-linux-x64.tar.gz mv jdk1.8.0_161 jdk

配置/etc/profile文件,在最后增加如下内容

vi /etc/profile

export JAVA_HOME=/usr/local/jdk export JRE_HOME=/usr/local/jdk/jre export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH export PATH=$JAVA_HOME/bin:$PATH

让配置生效

source /etc/profile

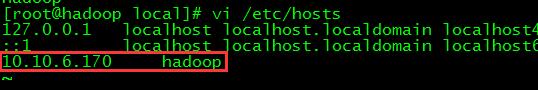

4、配置hosts文件

先用hostname获取机器名

vi /etc/hosts

配置机器的IP和机器名

5、设置ssh-keyge

ssh-keygen -t rsa

一路回车

cd /root/.ssh cat id_rsa.pub >>authorized_keys

6、开始安装hadoop

下载地址:https://pan.baidu.com/s/1Q0171QSfL1E6AgaQs2tQ9g

将gz包放在/usr/local下

tar zxvf hadoop-3.0.0.tar.gz mv hadoop-3.0.0 hadoop

创建目录

mkdir -p /usr/local/hadoop/tmp mkdir -p /usr/local/hadoop/hdfs/name mkdir -p /usr/local/hadoop/hdfs/data

修改配置文件

vi /usr/local/hadoop/etc/hadoop/core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://10.10.6.170:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

</property>

</configuration>

vi /usr/local/hadoop/etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/hdfs/data</value>

</property>

</configuration>

vi /usr/local/hadoop/sbin/start-dfs.sh

vi /usr/local/hadoop/sbin/stop-dfs.sh

这两个文件的第二行增加下如内容:

HDFS_DATANODE_USER=root HDFS_DATANODE_SECURE_USER=hdfs HDFS_NAMENODE_USER=root HDFS_SECONDARYNAMENODE_USER=root

vi /usr/local/hadoop/etc/hadoop/hadoop-env.sh

在55行左右增加如下内容

export JAVA_HOME=/usr/local/jdk/

执行HDFS的格式化

/usr/local/hadoop/bin/hadoop namenode -format

启动HDFS

/usr/local/hadoop/sbin/start-dfs.sh

出现Warning没关系,停止HDFS再启动就没有了

停止HDFS

/usr/local/hadoop/sbin/stop-dfs.sh

简单使用

cd /usr/local/hadoop/bin

查看根目录下的空间使用情况

./hadoop fs -df -h /

使用touchz创建一个空文件

./hadoop fs -touchz /hello

查看根目录下的文件

./hadoop fs -ls /

使用put从其他目录拷贝一个文件到HDFS根目录下

./hadoop fs -put /usr/local/jdk-8u161-linux-x64.tar.gz /

再次查看根目录下的文件

./hadoop fs -ls /