1、下载一中文长篇小说,并转换成UTF-8编码。

2、使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

3、排除一些无意义词、合并同一词。

4、对词频统计结果做简单的解读。

import jieba txt=open('呆梨.txt','r').read() for i in '''.,?“”''': txt=txt.replace(i,'') words=list(jieba.cut(txt)) exc={'了','么','只','不','她','是'} dic={} keys=set(words) keys=keys-exc for w in keys: dic[w]=words.count(w) wc = list(dic.items()) wc.sort(key=lambda x:x[1],reverse=True) for w in range(20): print(wc[w])

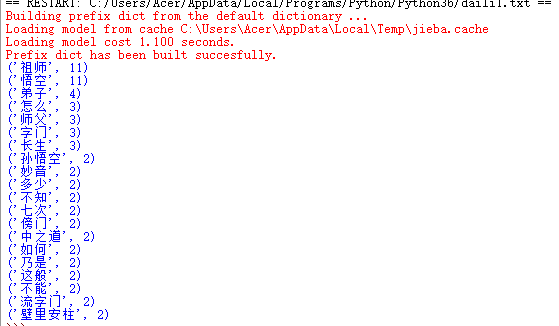

结果如下:

用循环方法:

import jieba txt=open('呆梨.txt','r').read() for i in '''.:?''': txt=txt.replace(i,'') words=list(jieba.cut(txt)) dic={} for w in words: if len(w)==1: continue else: dic[w]=dic.get(w,0)+1 wc = list(dic.items()) wc.sort(key=lambda x:x[1],reverse=True) for w in range(20): print(wc[w])

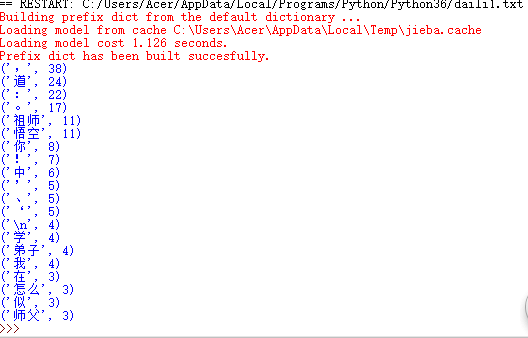

结果如下: