目录

第一章 绪论

1.1 引言

人工智能:

机器学习:

深度学习:

1.4 归纳偏好

(在学习过程中有多个假设可以在训练数据集上fit很好,这时只能靠归纳偏好来约束假设空间,比如越简单越好)

归纳偏好课看做学习算法自身在一个可能很庞大的假设空间中对假设进行选择的启发式或“价值观”,有个一般性的原则来引导算法确立正确的偏好----“奥卡姆剃刀”:若有多个假设与观察一直,则选择最简单的那个

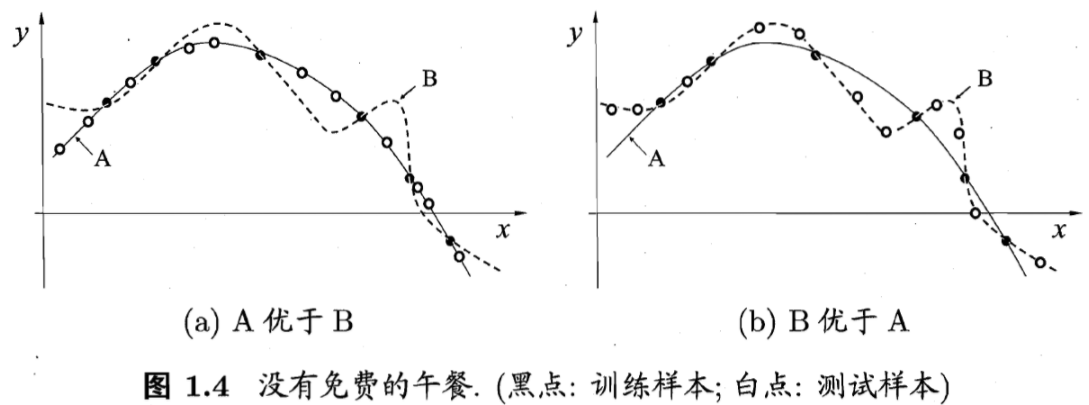

归纳偏好对学习算法本身做出了关于“什么样的模型更好”的假设,但是这种假设不一定完全正确,也有可能更复杂的模型结果能fit更多的测试数据

对于任何一个学习算法La,若它在某些问题上比学习算法Lb好,那么必然存在另一些问题,Lb比La好。这个结论对任何算法均成立(随机胡猜算法Lb也成立),这就是“天下没有免费的午餐”