keywords:

- urllib2,BeautifulSoup,cookielib

题外话:

小弟是编程爱好者,各位看官轻拍。

最近在使用urllib2抓取网页内容,在学习的过程中也查阅了不少资料,并从中收获很多。在查阅资料的过程中,我发现大部分资料都是建立在对urllib2的熟悉基础之上,程序的细节并未顾及到新手看到这份资料会产生怎样的困惑。在接下来的内容中,我会写到我碰到的疑问以及解决方法。如果你也碰到类似的困惑,希望给予你帮助。

一.urllib2简介

urllib2提供一个基础函数urlopen,通过向指定的URL发出请求来获取数据。最简单的形式就是

- import urllib2

- response=urllib2.urlopen('http://www.douban.com')

- html=response.read()

这个过程就是我们平时刷网页的代码表现形式,它基于请求-响应模型。

- response=urllib2.urlopen('http://www.douban.com')

实际上可以看作两个步骤:

我们指定一个域名并发送请求

1.

- request=urllib2.request('http://www.douban.com')

接着服务端响应来自客户端的请求

2.

- response=urllib2.urlopen(request)

也许你会注意到,我们平时除了刷网页的操作,还有向网页提交数据。这种提交数据的行为,urllib2会把它翻译为:

- import urllib

- import urllib2

- url = 'http://www.douban.com'

- info = {'name' : 'Michael Foord',

- 'location' : 'Northampton'}

- data = urllib.urlencode(info) #info 需要被编码为urllib2能理解的格式,这里用到的是urllib

- req = urllib2.Request(url, data)

- response = urllib2.urlopen(req)

- the_page = response.read()

有时你会碰到,程序也对,但是服务器拒绝你的访问。这是为什么呢?问题出在请求中的头信息(header)。

有的服务端有洁癖,不喜欢程序来触摸它。这个时候你需要将你的程序伪装成浏览器来发出请求。请求的方式就包含在header中。

常见的情形:

- import urllib

- import urllib2

- url = 'http://www.someserver.com/cgi-bin/register.cgi'

- user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'# 将user_agent写入头信息

- values = {'name' : 'Michael Foord',

- 'location' : 'Northampton',

- 'language' : 'Python' }

- headers = { 'User-Agent' : user_agent }

- data = urllib.urlencode(values)

- req = urllib2.Request(url, data, headers)

- response = urllib2.urlopen(req)

- the_page = response.read()

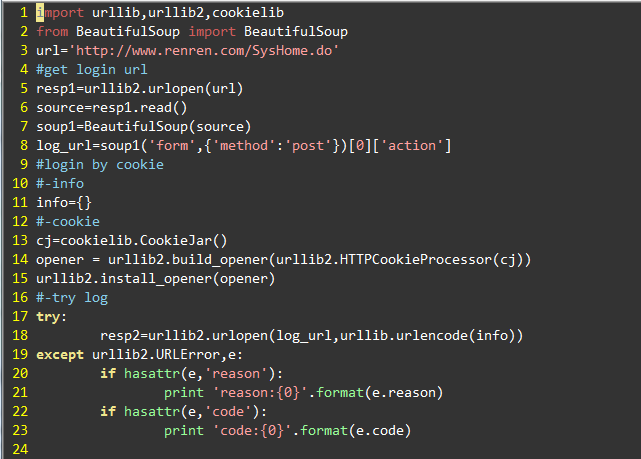

二.示例

模拟一个利用cookie登录人人网的过程

2012-03-07 21:34 上传

说明:

1.人人网的登录地址需要用BeautifulSoup来抓取。

2.个人信息存在info中。info是一个字典{'email':'xx','password':'xx'}.key的命名需要根据实际网页中定义,比如豆瓣的定义是{'form_email':'xx','form_password':'xx'}

3.使用cookie的好处在于,登录之后你可以使用cookie中保存的信息作为头信息的一部分,利用已经保存的头信息接着访问网站。

参考:

HOWTO Fetch Internet Resources Using urllib2

Beautiful Soup 中文文档

How to use Python to login to a webpage and retrieve cookies for later usage?